Академический Документы

Профессиональный Документы

Культура Документы

Invst Marcov

Загружено:

Fech ShcАвторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Invst Marcov

Загружено:

Fech ShcАвторское право:

Доступные форматы

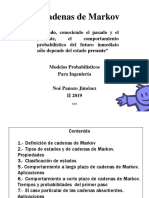

ndice 1. 2. 3. 4. 5. 6. 7. 8. 9.

Introduccin Cadenas de Markov Ecuaciones de Chapman-Kolmogorov Clasificacin de los estados en una cadena de Markov Tiempos de primera pasada Estados Absorbentes Cadenas de Markov en tiempo continuo Algunas v. a. importantes Probabilidades de estado estable

10. Ejemplos explicativos

Introduccin

Las cadenas de Markov se incluyen dentro de los denominados procesos estocsticos. Dichos estudian el comportamiento de variables aleatorias a lo largo del tiempo X(t,w). Se definen como una coleccin de variables aleatorias {X(t,w), t I}, donde X (t,w) puede representar por ejemplo los niveles de inventario al final de la semana t. El inters de los procesos estocsticos es describir el comportamiento de un sistema e operacin durante algunos periodos. Los procesos estocsticos se pueden clasificar atendiendo a dos aspectos: si el espacio de estados posibles de la variable aleatoria contiene valores discretos o continuos y de si los valores del tiempo son discretos o continuos. Las cadenas de Markov es un proceso estocstico en el que los valores del tiempo son discretos y los estados posibles de la variable aleatoria contiene valores discretos, es decir, es una cadena estocstica de tiempo discreto. Las cadenas de Markov, se clasifican, adems, dentro de los procesos estocsticos de Markov, que son aquellos en el que el estado futuro de un proceso es independiente de los estados pasados

y solamente depende del estado presente. Por lo tanto las probabilidades de transicin entre los estados para los tiempos k-1 y k solamente depende de los estados que la variable adquiere dichos tiempos. INDICE

Cadenas de Markov

Las cadenas de Markov estn constituidas por un conjunto de valores {Xn , n :0,1,2...} que cumplen la probabilidad de alcanzar cualquier estado j de la variable depende exclusivamente del estado i alcanzado en el instante de tiempo anterior. P[Xn+1= j / Xn = i, Xn-1 = i1,..., X0=in]=P[Xn+1=j / Xn=i] i,j Se define para cada par de estados (i, j) que se alcanzan en dos pasos consecutivos de n y n+1 una probabilidad condicional denominada probabilidad de transicin pij. P[X+1=j / Xn=i] = pij Las probabilidades de transicin de un paso son estacionarias, es decir, que no cambian con el tiempo. Si pij no depende del instante n se dice que la cadena de Markov es homognea. Las probabilidades de transicin estructuradas en forma matricial da lugar a lo que se denomina matriz de transicin. Dicha matriz relaciona los estados de la variable en dos pasos consecutivos y n+1 a travs de sus probabilidades de transicin.

Periodo n+1 Estado 1 ... Estado 1 p11 Periodo n .... P*1 p1* p** pM* Estado M p1M p*M pMM

Estado M pM 1

Una probabilidad de transicin pij ^(n) de n pasos entre los estados i y j indica la probabilidad de que partiendo del estado i en pasos se llegue al estado j.

INDICE

Ecuaciones de Chapman-Kolmogorov

Estas ecuaciones proporcionan un mtodo para determinar las probabilidades de que un proceso del estado i notada por pij ^(n). pij ^(n) = k=0..K pik ^(m) pkj ^(-m) ; i,j,n; 0<m n

Cada sumando representa la probabilidad de que partiendo del estado i se llegue al estado k transcurridos m perodos y posteriormente desde el estado k se llegue al estado j en n-m perodos. INDICE

Clasificacin de los estados en una cadena de Markov

Las probabilidades de transicin asociadas a los estados juegan un papel importante en el estudio de las cadenas de Markov. Para describir con mas detalles las propiedades de una cadena de Markov es necesario presentar algunos conceptos y definiciones que se refieren a estos estados. U estado j es accesible desde el estado i si para algn n se tiene que pij ^(n) >0. Una cadena de Markov se puede dividir en clases. Una clase est formada por todos los estados que son accesibles entre s .

Considerando las probabilidades fii de que el proceso regrese al estado i comenzando en el estado i se puede clasificar los estados en recurrente s fii =, transitorio s fii <1y absorbente s pii =1. En una cadena de Markov finita e irreducible todos los estados de dicha cadena so recurrentes. El perodo de u estado i es el nmero T de perodos para el cual se cumple que pij ^(n) =0, siendo los valores distintos de T, 2T, 3T,.. y T es el valor ms elevado que cumple esa propiedad. Un estado es apriodico si la variable aleatoria puede encontrarse en el mismo estado en dos perodos consecutivos. Un estado i es recurrente positivo si comenzando en el estado i el tiempo esperado para que el proceso regrese al estado i es finito.

Un estado se denomina esgrico si es recurrente positivo y adems aperidico. Una cadena es ergrica si todos sus estados son esgricos. INDICE

Tiempos de primera pasada.

Es importante el n de transiciones de que hace el proceso al ir del estado i al j por primera vez; a esto se llama tiempo de 1 pasada. Tiempo de recurrencia ser una particularizacin de lo anterior para i=j (n de transiciones hasta volver al estado inicial i). En general los tiempos de 1 pasada son variables aleatorias, donde las distribuciones de probabilidad dependen de las probabilidades de transicin del proceso. stas probabilidades satisfacen lo siguiente:

fij(1)=pij(1)=pij fij(1)= pik fkj(1) kj fij(n)= pik fkj(n-1) kj

La ltima suma puede resultar menor que 1, lo que significa que un proceso que comienza en i, puede nunca alcanzar el estado j. Es sencillo calcular el tiempo de primera pasada de i a j; siendo mij esta esperanza: mij = n fij(n)=1 n=1 si fij(n)<1 n=1 si fij(n)=1 n=1

mij satisface de manera nica, la ecuacin:

mij =1+ pik mkj kj

que reconoce que la 1 transicin puede ser al estado j o a algn otro estado k. Para el caso de mii (con j=i)es el n esperado de transiciones para que el proceso regrese al estado i(tiempo esperado de recurrencia).stos se calculan de inmediato de la forma: 1 mii =----- siendo pi las probabilidades de estado estable. pi

INDICE

Estados Absorbentes.

Un estado se llama absorbente si pik =1, es decir, si una vez que el estado llega a k, permanece ah para siempre. Si k es un estado absorbente y el proceso comienza en i, la probabilidad de llegar a k se llama probabilidad de absorcin de k (fik ). Si se tienen 2 o ms estados absorbentes, el proceso ser absorbido por uno de stos. Para saber cual, hay que resolver el sistema de ecuaciones:

M fik= pij fjk j=0 para i=0,1,,M

Esto es importante en las caminatas aleatorias: cadenas de Markov en las que si el sistema se encuentra en el estado i, entonces, en una sola transicin, o permanece en i, o se mueve a uno de los 2 estados inmediatamente adyacentes a i. INDICE

Cadenas de Markov en tiempo continuo

Se etiquetan los estados posibles del sistema 0,1,,M. Se comienza en 0, y t0. Sea la v.a.X(t) el estado del sistema en t. Tomar un valor en 0t<t1 , despus tomar otro valor en t1t<t2, Es interesante conocer el estado del proceso en t=s+t(t unidades en el futuro). Ser sencillo conocerlo si el proceso tiene lapropiedad markoviana: P{X(s+t)=j/X(s)=i y X(r)=x(r)}= P{X(s+t)=j/X(s)=i} "i,j y "r0, s>r y t>0.

P{X(s+t)=j/X(s)=i} es una probabilidad de transicin. Si es independiente de s, se llamar probabilidad de transicin estacionaria.

Un proceso estocstico de tiempo continuo {X(t); t0} es una cadena de Markov de tiempo continuo si tiene la propiedad markoviana. INDICE

Algunas v. a. importantes:

*La distribucin de probabilidad del tiempo que falta para que el proceso haga una transicin fuera de un estado dado es siempre la misma(independientemente del tiempo que el proceso haya pasado en ese estado), es decir:no tiene memoria. La nica distribucin en TC que cumple esto es la distribucin exponencial: P{Tit}=1-e-qt para t0 (parmetro q, media 1/q).

Por tanto, describiremos la cadena de Markov: -La v.a. Ti tiene una distribucin exponencial con media 1/q. -Al salir de un estado i, se pasa a otro j, con probabilidad pij que cumple que pij=0 para toda i, y la suma de todas las pij es 1. -El siguiente estado que se visita tras i, es independiente del tiempo transcurrido en i. Las intensidades de transicin(probabilidades de transicin, pero en TC) : d qi= - pii(0)=lim dt t0 1- pii(t) , para i=0,1,2,,M, t

y d qi= - pij(0)=lim dt t0 1- pij(t) = qi pij , para toda ji t

donde pij es la funcin de probabilidad de transicin de TC, qi y qij son las tasas de transicin(qi= qij ). ij

INDICE

Probabilidades de estado estable:

La funcin de probabilidad de transicin de TC satisface las ecuaciones de Chapman-Kolmogorov, luego para cualequiera estados i,j y nmeros t y s(0s<t):

M pij= pik(s)pkj(t-s) k=1 para i=0,1,,M

Se dice que un par de estados i,j se comunican si existen tiempos t1, t2 tales que pij(t1)>0 y pij(t2)>0. Todos los estados que se comunican forman una clase. Si todos los estados en una cadena forman una clase, entonces la cadena ser irreducible, por lo que: pij(t)>0, para todo t>0 y todos los estados i,j , y ms an: lim pij(t)=pj t llamadas probabilidades de estado estable(o estacionarias).

Las probabilidades estacionarias satisfacen:

pj qj= pi qij ij

para j=0,1,,M

pj=0 j=0

(stas ecuaciones se suelen llamar de balance).

INDICE

Ejemplos explicativos

Problema de ratn:

o o

Texto (.doc) Transparencias (.ppt)

Problema de la telefona mvil

Вам также может понравиться

- Material de Apoyo Tema A.2Документ12 страницMaterial de Apoyo Tema A.2Roger CayllanteОценок пока нет

- Instru Dossier 3Документ18 страницInstru Dossier 3Jose HerreraОценок пока нет

- Informe de Concreto - Consorcio Arauca 806 - Arauquita - V1Документ12 страницInforme de Concreto - Consorcio Arauca 806 - Arauquita - V1Anderson MoralesОценок пока нет

- Fluj 2 V1Документ6 страницFluj 2 V1TatanОценок пока нет

- Certificado de Calibración #M-0344-2021Документ3 страницыCertificado de Calibración #M-0344-2021Juan Manuel Pinto RiveraОценок пока нет

- Pruebas R&RДокумент5 страницPruebas R&RLuis Fernando Giraldo JaramilloОценок пока нет

- Practica #1 LaboratorioДокумент6 страницPractica #1 LaboratorioRancell severinoОценок пока нет

- Cadenas markovNPJ PDFДокумент33 страницыCadenas markovNPJ PDFOchoa VictorОценок пока нет

- Fita 0080 MC7 U4 C7Документ18 страницFita 0080 MC7 U4 C7Francisco Gajardo CidОценок пока нет

- Certificado de Calibraci N 24684 - AQUAVITA S.A.C. - 20220503.20220502Документ3 страницыCertificado de Calibraci N 24684 - AQUAVITA S.A.C. - 20220503.20220502Eulises Vasquez TafurОценок пока нет

- Actividad Puntos Evaluables Procesos Estocasticos (Excelente)Документ5 страницActividad Puntos Evaluables Procesos Estocasticos (Excelente)Jaime Alberto Ricardo NeiraОценок пока нет

- Anexo A: Acreditación E-66Документ1 страницаAnexo A: Acreditación E-66Ramiro OrtegaОценок пока нет

- Ejercicios ARMAДокумент2 страницыEjercicios ARMAAnonymous T02GVGzBОценок пока нет

- Laboratorio de Calibración DimensionalДокумент4 страницыLaboratorio de Calibración DimensionaloscarОценок пока нет

- Henry Andrés Gómez RamírezДокумент6 страницHenry Andrés Gómez RamírezHenry Andrés Gómez RamírezОценок пока нет

- Cadenas de Markov 1Документ76 страницCadenas de Markov 1Andrew Beltrán GrassОценок пока нет

- Acta de AseguramientoДокумент5 страницActa de AseguramientoCDA MR LA LUNAОценок пока нет

- Maestria en Finanzas - Series de TiempoДокумент51 страницаMaestria en Finanzas - Series de TiempoDayra Ibeth Cabrera MunozОценок пока нет

- ProcesosEstocasticos CadenasdeMarkovДокумент88 страницProcesosEstocasticos CadenasdeMarkovRoberto Jahnsen GuerreroОценок пока нет

- Càlculo de Frecuencia de Calibraciòn PTДокумент7 страницCàlculo de Frecuencia de Calibraciòn PTOmar muñozОценок пока нет

- Certificado de Calibración 1Документ1 страницаCertificado de Calibración 1Gerardo Graza100% (1)

- Reporte Grupo 2Документ4 страницыReporte Grupo 2Marcia De la CruzОценок пока нет

- Proceso SДокумент12 страницProceso SJorge JmmsОценок пока нет

- l3 Cadenas de MarkovДокумент46 страницl3 Cadenas de MarkovAshly MadrigalОценок пока нет

- Taller2 Procesos PoissonДокумент2 страницыTaller2 Procesos PoissonDiegoRubianoОценок пока нет

- SERIES DE TIEMPO CON RStudioДокумент12 страницSERIES DE TIEMPO CON RStudioBritman SalcedoОценок пока нет

- Cadenas de MarkovДокумент48 страницCadenas de MarkovCharly KodeОценок пока нет

- 10037-2022 - Termohigrómetro Proskit MT-4616 - PanamarДокумент3 страницы10037-2022 - Termohigrómetro Proskit MT-4616 - PanamarEmanuel TapiaОценок пока нет

- 2.8.1. Variables Aleatorias Conjuntas.Документ23 страницы2.8.1. Variables Aleatorias Conjuntas.Plaga HouseОценок пока нет

- Smi 160065T PDFДокумент2 страницыSmi 160065T PDFROLANDO BURGOSОценок пока нет