Академический Документы

Профессиональный Документы

Культура Документы

1º Trabalho IA Perceptron

Загружено:

Leandro Brigo AntunesИсходное описание:

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

1º Trabalho IA Perceptron

Загружено:

Leandro Brigo AntunesАвторское право:

Доступные форматы

UNIVERSIDADE FEDERALDO TRINGULO MINEIRO

Instituto De Cincias Tecnolgicas e Exatas

Leandro Brigo Antunes (201110828)

Vtor Domingues de Faria (201110858)

.

.

.

Trabalho Perceptron

Prof Virglio de Melo Langoni

Disciplina: Inteligncia Artificil

Uberaba-MG

27/08/2015

Pela anlise de um processo de destilao fracionada de petrleo observou-se que

determinado leo poderia ser classificado em duas classes de purezas {P1 e P2} a partir da

medio de trs grandezas {X1, X2 e X3}, que representam algumas de suas propriedades fsicoqumicas. A equipe de engenheiros e cientistas pretende usar uma rede Perceptron para executar

a classificao automtica das duas classes.

Assim, baseado nas informaes coletadas do processo, formou-se o conjunto de

treinamento apresentado no Apndice I, tomando por conveno o valor 1 para leo pertencente

classe P1 e o valor 1 para leo pertencente classe P2.

Para tanto, o neurnio constituinte do Perceptron ter ento trs entradas e uma sada conforme

ilustrado na figura 3.8.

Utilizando o algoritmo supervisionado de Hebb (regra de Hebb) para classificao de

padres, e assumindo-se a taxa de aprendizagem como 0,01, faa as seguintes atividades:

1) Execute cinco treinamentos para a rede Perceptron, iniciando-se o vetor de pesos {W}

em cada treinamento com valores aleatrios entre zero e um. Se for o caso, reinicie o gerador de

nmeros aleatrios em cada treinamento de tal forma que os elementos do vetor de pesos iniciais

no sejam os mesmos. O conjunto de treinamento encontra-se no apndice 1.

//Trabalho perceptron

//Declarando valores de entrada

x = [-0.6508 0.1097 4.009 ;

-1.4492 0.8896 4.405 ;

2.0850 0.6876 12.0710 ;

0.2626 1.1476 7.7985 ;

0.6418 1.0234 7.0427 ;

0.2569 0.6730 8.3265;

1.1155 0.6043 7.4446;

0.0914 0.3399 7.0677;

0.0121 0.5256 4.6316;

-0.0429 0.4660 5.4323;

0.4340 0.6870 8.2287;

0.2735 1.0287 7.1934;

0.4839 0.4851 7.4850;

0.4089 -0.1267 5.5019;

1.4391 0.1614 8.5843;

-0.9115 -0.1973 2.1962;

0.3654 1.0475 7.4858;

0.2144 0.7515 7.1699;

0.2013 1.0014 6.5489;

0.6483 0.2183 5.8991;

-0.1147 0.2242 7.2435;

-0.7970 0.8795 3.8762;

-1.0625 0.6366 2.4707;

0.5307 0.1285 5.6883;

-1.2200 0.7777 1.7252;

0.3957 0.1076 5.6623;

-0.1013 0.5989 7.1812;

2.4482 0.9455 11.2095;

2.0149 0.6192 10.9263;

0.2012 0.2611 5.4631];

//Declarando valores de sada desejados

d = [-1 -1 -1 1 1 -1 1 -1 1 1 -1 1 -1 -1 -1 -1 1 1 1 1 -1 1 1 1 1 -1 -1 1 -1 1];

//Gerando pesos aleattrios

W = (rand(1,3));

//Taxa de aprendizagem

n = 0.01;

//DDeclarando valor do erro

e = 0.0001;

//Declarando Limiar de ativao

l = (rand(1,3))

// Declarando numero maximo de epocas

maxepocas = 300

function y1=ypercep(x, W, b)

u=W*x + b;

for i=1:(length(W(:,1))*length(x(1,:)))

if (u(i) >= 0) then

y1(i)=1;

else

y1(i)=-1;

end;

end

y1=y1';

endfunction

function [W, b, erroepoca]=train(W, b, x, y, n, maxepocas, e)

erroepoca=[];

t=1;

Erro= e;

while(maxepocas>=t)&(Erro>= e )

Erro=0;

for i=1:size(w,2)

y1 = ypercep(W,b,xin(i));

dif = y(i)-y1;

w=w + (n*dif)*x(:,i)';

b=b+n*dif;

Erro=Erro + (dif)^2;

end

erroepoca=[erroepoca Erro];

t=t+1;

end

endfunction

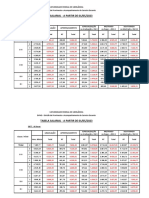

2) Registre os resultados dos cincos treinamentos na tabela 3.2 apresentada a seguir.

Valor de pesos iniciais

Valor de Pesos

finais

Treinamento

w0

w1

w2

w3

w0

w1

w2

1

0.9

0.9

0.9

-1

0.517

0.8836

1

0.2

0.3

0.1

-1

0.4345

0.644

1

0.9

0.8

0.7

-1

0.552

0.8239

1

0.6

0.1

0.2

-1

0.4357

0.64

1

0.1

0.5

0.9

-1

0.4386

0.64

Tabela 3.2- Resultados dos treinamentos do Perceptron.

1

2

3

4

5

w2

-0.2439

-0.219

-0.2401

0.2195

0.2197

pocas

95

188

65

216

147

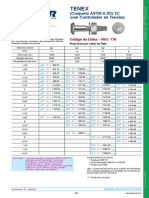

3) Aps o treinamento do Perceptron, coloque o mesmo em operao, aplicando na

classificao automtica das amostras de leo da tabela 3.3, indicando ainda nesta tabela aqueles

resultados das sadas (Classes) referentes aos cinco processos de treinamento realizados no item

1.

Amostra

1

2

3

4

5

6

7

8

9

10

x1

x2

x3

T1

T2

T3

T4

5.989

0.062

5.989

-1

-1

-1

-1

0.7842 1.126

5.591

1

1

1

1

0.3012 0.5611

5.823

1

1

1

1

0.7757 1.064

8.067

1

1

1

1

0.157 0.8028

6.304

1

1

1

1

-0.7014 1.031

3.660

1

1

1

1

0.3748 0.1536

6.153

-1

-1

-1

-1

-0.692 0.9494

4.405

1

1

1

1

-1.397 0.7141

4.926

-1

-1

-1

-1

-1.884 -0.2805 1.254

-1

-1

-1

-1

Tabela 3.3 Amostras de leo para validar a rede Perceptron.

T5

-1

1

1

1

1

1

-1

1

-1

-1

4) Explique porque o nmero de pocas de treinamento em relao a esta aplicao, varia

a cada vez que executamos o treinamento perceptron.

R. Um peso aletorio gerado a cada vez que iniciamos o treinamento, fazendo com que

o nmero de pocas mude.

Вам также может понравиться

- Desenvolvendo Projetos No Energia Para O Msp430 Volume IiОт EverandDesenvolvendo Projetos No Energia Para O Msp430 Volume IiОценок пока нет

- RNA EPC-PMC Classificacao PadraoДокумент6 страницRNA EPC-PMC Classificacao PadraoGustavo Fortes novackОценок пока нет

- Epc01 RnaДокумент3 страницыEpc01 RnathiagoОценок пока нет

- Relatório 1a Aula - 6Документ17 страницRelatório 1a Aula - 6Caio Eduardo Silva33% (3)

- RNA - EPC01 - ResolvidoДокумент5 страницRNA - EPC01 - ResolvidoClaudio ReisОценок пока нет

- Exercício Aula 3 RespostaДокумент9 страницExercício Aula 3 RespostaPedro Canassa100% (1)

- Balancetes Consolidado MonsertecДокумент294 страницыBalancetes Consolidado MonsertecJonathas AlmeidaОценок пока нет

- RNA EPC-PMC Aproximacao FuncionalДокумент4 страницыRNA EPC-PMC Aproximacao FuncionalGustavo Fortes novackОценок пока нет

- ESTUDOS DE CASOS DomingoДокумент7 страницESTUDOS DE CASOS DomingoNadya ByancaОценок пока нет

- 1 X 2Документ20 страниц1 X 2RafaelMonizVieira100% (1)

- Atividade Contextualizada Fundamentos de Topografia - Paulo RicardoДокумент3 страницыAtividade Contextualizada Fundamentos de Topografia - Paulo RicardoPaulo RicardoОценок пока нет

- Apostila Hsi - Ila 05082013 Final PDFДокумент61 страницаApostila Hsi - Ila 05082013 Final PDFMichelle Dos Santos SilvaОценок пока нет

- IC - Trabalho Computacional 1Документ2 страницыIC - Trabalho Computacional 1tiagoОценок пока нет

- Projeto Calculo NuméricoДокумент25 страницProjeto Calculo NuméricoGuilherme Luiz Guerra VicenteОценок пока нет

- TrabalhoFinal OficinasProjetos Elielton ChristianДокумент15 страницTrabalhoFinal OficinasProjetos Elielton ChristianElieltonSilvaОценок пока нет

- Exc. Avaliativo 02Документ5 страницExc. Avaliativo 02Ana Paula LepriОценок пока нет

- Tabela Salarial - A Partir de 01/05/2023Документ3 страницыTabela Salarial - A Partir de 01/05/2023Raul BrandãoОценок пока нет

- IS 10 - Execução de Teste de Aterramento - Rev. BДокумент3 страницыIS 10 - Execução de Teste de Aterramento - Rev. BMatheus PaivaОценок пока нет

- Relatório - Trabalho 2 Motor JGA25Документ17 страницRelatório - Trabalho 2 Motor JGA25SoloTCHERNOZIONОценок пока нет

- Toledo Indicador Gráfico Digital e Analógico Manual de Operação Instalação e Manutenção Moim-8540 Gráfico Re - PDFДокумент146 страницToledo Indicador Gráfico Digital e Analógico Manual de Operação Instalação e Manutenção Moim-8540 Gráfico Re - PDFPaulo Lima Campos67% (3)

- EDS-0081-MDC-001 - PROJETO SISTEMA ENERGIA SOLAR FOTOVOLTAICA 3,64kW - MEMORIAL DESCRITIVO E DE CÁLCULO - PATRÍCIA HELENA DE CARVALHO SILVAДокумент21 страницаEDS-0081-MDC-001 - PROJETO SISTEMA ENERGIA SOLAR FOTOVOLTAICA 3,64kW - MEMORIAL DESCRITIVO E DE CÁLCULO - PATRÍCIA HELENA DE CARVALHO SILVASaul BezerraОценок пока нет

- PTS-SP-28741-21-R3 - CHILLER B - Substituição Módulo Ou SensorДокумент9 страницPTS-SP-28741-21-R3 - CHILLER B - Substituição Módulo Ou SensorEVELYN SOUSAОценок пока нет

- NR 01 Disposições Gerais e Gerenciamento de Riscos OcupacionaisДокумент48 страницNR 01 Disposições Gerais e Gerenciamento de Riscos OcupacionaisMichelly FabreОценок пока нет

- Moim - Impressor 451 PDFДокумент42 страницыMoim - Impressor 451 PDFRodrigo Muniz100% (1)

- 451 Impressor Térmico Cod. de BarrasДокумент42 страницы451 Impressor Térmico Cod. de BarrasFernando WatambakОценок пока нет

- Tabela - Pagamento - 11 Agosto de 2019 EBTTДокумент3 страницыTabela - Pagamento - 11 Agosto de 2019 EBTTluciopatricioОценок пока нет

- DatacenterДокумент3 страницыDatacenterRonaldo AlvesОценок пока нет

- Nvel Intermedirio Com GQ3Документ1 страницаNvel Intermedirio Com GQ3sabrinabrasilОценок пока нет

- Balancete Contabil - CustosДокумент8 страницBalancete Contabil - CustosjoseОценок пока нет

- Relatório 3Документ8 страницRelatório 3Larisa AlvesОценок пока нет

- 300KVA (Memorial)Документ6 страниц300KVA (Memorial)mas283283Оценок пока нет

- Htcms Media PDF Tabela-De-Precos BR Fixadores-Para-Construcao-Civil PDFДокумент46 страницHtcms Media PDF Tabela-De-Precos BR Fixadores-Para-Construcao-Civil PDFalanasantos0% (1)

- Integrantes Do Grupo RA Brandon Kein Honma 180888 Daniel Felipe Rocha Batista 180873 Otavio Yuji Vieira de Paula Oguchi 160187 Reiner Hobus 191470Документ11 страницIntegrantes Do Grupo RA Brandon Kein Honma 180888 Daniel Felipe Rocha Batista 180873 Otavio Yuji Vieira de Paula Oguchi 160187 Reiner Hobus 191470DarlingflaigОценок пока нет

- ICA 172-2 - Cobrança de Serviços Prestados Pelos Órgãos Do SISCEAB - 2005Документ11 страницICA 172-2 - Cobrança de Serviços Prestados Pelos Órgãos Do SISCEAB - 2005kassilva62Оценок пока нет

- 2180 Lava RápidoДокумент34 страницы2180 Lava RápidoBiotronica Assis TecОценок пока нет

- 2023 - Tabela Salarial SorocabaДокумент5 страниц2023 - Tabela Salarial Sorocabalariolive.santosОценок пока нет

- 22 - Campanhas de Servico - Boletins Tecnicos - XRE300-XRE300AДокумент66 страниц22 - Campanhas de Servico - Boletins Tecnicos - XRE300-XRE300AMarcosОценок пока нет

- 8540 NuméricoДокумент84 страницы8540 Numéricoalexandremec1Оценок пока нет

- PTS-SP-28740-21-R1 - CHILLER C - Substituição Módulo Ou SensorДокумент8 страницPTS-SP-28740-21-R1 - CHILLER C - Substituição Módulo Ou SensorEVELYN SOUSAОценок пока нет

- ASSIST e TecC&T NIДокумент4 страницыASSIST e TecC&T NIMayОценок пока нет

- 9091 AC - InoxДокумент80 страниц9091 AC - InoxMarcio AlexandreОценок пока нет

- Relatório 2 Rac Self-ContainedДокумент14 страницRelatório 2 Rac Self-ContainedRafael SantosОценок пока нет

- En 25Документ8 страницEn 25AntonellaОценок пока нет

- 2254 FLCДокумент110 страниц2254 FLCBiotronica Assis TecОценок пока нет

- 8530 CougarДокумент80 страниц8530 CougarRogerio NascimentoОценок пока нет

- Tabela Salarial 2023Документ4 страницыTabela Salarial 2023mayane freitasОценок пока нет

- 5678-22 Plata de Filtragem - PT - R0Документ64 страницы5678-22 Plata de Filtragem - PT - R0LeonardoDeiróОценок пока нет

- Laudo Opacidade DragaДокумент5 страницLaudo Opacidade DragaVania SantosОценок пока нет

- Edital 10 Petrobras PSP 1 - 2023 Retificacao Resultado Final PDFДокумент8 страницEdital 10 Petrobras PSP 1 - 2023 Retificacao Resultado Final PDFCanal do GARFEОценок пока нет

- TabelasSalariais2016 PDFДокумент26 страницTabelasSalariais2016 PDFDanilo Fernandes MunizОценок пока нет

- Laudo CompactadorДокумент6 страницLaudo CompactadorRomário VieiraОценок пока нет

- 00.548-22-Eco-048 - Memorial DrenagemДокумент9 страниц00.548-22-Eco-048 - Memorial DrenagemsratransportesvipОценок пока нет

- ART-3 T12 GabaritoДокумент1 страницаART-3 T12 GabaritoRODRIGO SCHMIDT DOS REISОценок пока нет

- Tabsp 2022 Apartirde01jan202220220121Документ1 страницаTabsp 2022 Apartirde01jan202220220121Leandro De AlmeidaОценок пока нет

- Trane - Manual de Instalação TRAE e TRCEДокумент31 страницаTrane - Manual de Instalação TRAE e TRCEZeBocao0% (2)

- EMEi08 - Pratica 5 - 1a LeiДокумент11 страницEMEi08 - Pratica 5 - 1a LeiWyn LilОценок пока нет

- EPC4 RedesNeuraisДокумент5 страницEPC4 RedesNeuraishugo SilvaОценок пока нет

- 9 - Apêndice 1 - Tabelas Termodinâmicas PDFДокумент38 страниц9 - Apêndice 1 - Tabelas Termodinâmicas PDFChristian Strobel100% (1)

- GT0522 Ed A 04-2012 Treinamento Técnico UVTДокумент154 страницыGT0522 Ed A 04-2012 Treinamento Técnico UVTOrestes Silveira Correa91% (11)

- Calypso Basico 4 2 BRДокумент167 страницCalypso Basico 4 2 BRManoel Missias Francisco de Sousa100% (4)

- Atividade Discursiva. Engenharia e ProfissãoДокумент3 страницыAtividade Discursiva. Engenharia e Profissãodouglasvidal30100% (1)

- Proposta de Integração Da Engenharia de Software Nas Estratégias Empresariais PDFДокумент8 страницProposta de Integração Da Engenharia de Software Nas Estratégias Empresariais PDFAmarildo BessaОценок пока нет

- A Ergonomia ComoДокумент8 страницA Ergonomia ComoAnnalethycia PereiraОценок пока нет

- Microsoft Word - Plano de DisciplinaДокумент5 страницMicrosoft Word - Plano de DisciplinaGisele Vilela AlmeidaОценок пока нет

- Proposta Estagio Engenharia MecanicaДокумент4 страницыProposta Estagio Engenharia MecanicaPedro SilvestriniОценок пока нет

- Currículo Do Sistema de Currículos Lattes (Guilherme Ignácio de Oliveira)Документ3 страницыCurrículo Do Sistema de Currículos Lattes (Guilherme Ignácio de Oliveira)ginatiusОценок пока нет

- Cronograma e MetodologiaДокумент2 страницыCronograma e MetodologiaJessica Byron100% (1)

- Panegossi - Peças PDFДокумент76 страницPanegossi - Peças PDFChagas Oliveira100% (4)

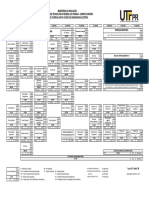

- Matriz Curricular UTFPR Eng. ElétricaДокумент2 страницыMatriz Curricular UTFPR Eng. ElétricaJonas Eduardo SilvaОценок пока нет

- Ciências Econômicas - N - EmentaДокумент9 страницCiências Econômicas - N - EmentaRafael AbranchesОценок пока нет

- 1-Business Intelligence X Ciencia de DadosДокумент8 страниц1-Business Intelligence X Ciencia de DadosRafael Assis AmancioОценок пока нет

- A Inovação e Tecnologia Nas Micro e Pequenas EmpresasДокумент14 страницA Inovação e Tecnologia Nas Micro e Pequenas EmpresasSimone MeloОценок пока нет

- Aula 1 Superestrutura de Estradas (Modo de Compatibilidade)Документ19 страницAula 1 Superestrutura de Estradas (Modo de Compatibilidade)vamelloОценок пока нет

- Curriculum Vitae - Luciano ReisДокумент1 страницаCurriculum Vitae - Luciano ReisLuciano ReisОценок пока нет

- Pinch e Bijker - AtualДокумент9 страницPinch e Bijker - AtualCarlos SchettiniОценок пока нет

- Modelo Resumo Sicti 2012Документ3 страницыModelo Resumo Sicti 2012Marcella MoraisОценок пока нет

- Equipamentos em Operacao Ate 26-06-2015Документ97 страницEquipamentos em Operacao Ate 26-06-2015mnbuch5160Оценок пока нет

- Escalonamento de Engenharia Eletrica 2018.1 0Документ26 страницEscalonamento de Engenharia Eletrica 2018.1 0Luís FernandoОценок пока нет

- CV Rui Nov 2015 Com FotoДокумент5 страницCV Rui Nov 2015 Com FotoRui AmaralОценок пока нет

- Edital021 005 2 PDFДокумент228 страницEdital021 005 2 PDFfabioo220% (1)

- Avaliação Inovação TecnológicaДокумент3 страницыAvaliação Inovação TecnológicaNatalia Oliveira100% (1)

- Design, Cultura e Sociedade - Material de ApoioДокумент171 страницаDesign, Cultura e Sociedade - Material de ApoioDaniela EstaregueОценок пока нет

- Catalogo de Produtos Perfinasa 2016Документ52 страницыCatalogo de Produtos Perfinasa 2016Messias Sousa Karoline MilhomemОценок пока нет

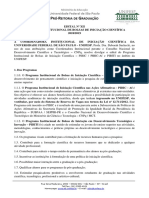

- Modelo Edital Iniciacao Cientifica 2018 2019 UNIFESPДокумент8 страницModelo Edital Iniciacao Cientifica 2018 2019 UNIFESPBruno M. FalcettiОценок пока нет

- Projeto de Controlador Por Avanço de Fase Utilizando o Software MATLAB.Документ16 страницProjeto de Controlador Por Avanço de Fase Utilizando o Software MATLAB.Ana QuadrosОценок пока нет

- 22 Revestimentos de Pisos - 25 e 26 Aulas Teóricas PDFДокумент126 страниц22 Revestimentos de Pisos - 25 e 26 Aulas Teóricas PDFLuiz Henrique CescoОценок пока нет

- Documentação Do SIMPLE TETRIS (Versão 1.8) - Franciele Ehrhardt HoffmannДокумент173 страницыDocumentação Do SIMPLE TETRIS (Versão 1.8) - Franciele Ehrhardt HoffmannfrancihoffОценок пока нет

- Técnicas de Agrimensura - Apostila 1Документ2 страницыTécnicas de Agrimensura - Apostila 1Mateus BragaОценок пока нет

- Catálogo Altseg - Cci - 5Документ10 страницCatálogo Altseg - Cci - 5Daniel MurphyОценок пока нет

- Artigo 2Документ10 страницArtigo 2Ricael SpirandeliОценок пока нет

- O fim da ansiedade: O segredo bíblico para livrar-se das preocupaçõesОт EverandO fim da ansiedade: O segredo bíblico para livrar-se das preocupaçõesРейтинг: 5 из 5 звезд5/5 (16)

- Elaboração de programas de ensino: material autoinstrutivoОт EverandElaboração de programas de ensino: material autoinstrutivoОценок пока нет

- Psicologia sombria: Poderosas técnicas de controle mental e persuasãoОт EverandPsicologia sombria: Poderosas técnicas de controle mental e persuasãoРейтинг: 4 из 5 звезд4/5 (92)

- O psicólogo clínico em hospitais: Contribuição para o aperfeiçoamento da arte no BrasilОт EverandO psicólogo clínico em hospitais: Contribuição para o aperfeiçoamento da arte no BrasilОценок пока нет

- Focar: Supere a procrastinação e aumente a força de vontade e a atençãoОт EverandFocar: Supere a procrastinação e aumente a força de vontade e a atençãoРейтинг: 4.5 из 5 звезд4.5/5 (53)

- Técnicas De Terapia Cognitivo-comportamental (tcc)От EverandTécnicas De Terapia Cognitivo-comportamental (tcc)Оценок пока нет

- E-TRAP: entrevista diagnóstica para transtornos de personalidadeОт EverandE-TRAP: entrevista diagnóstica para transtornos de personalidadeРейтинг: 5 из 5 звезд5/5 (3)

- Treinamento cerebral: Como funcionam a inteligência e o pensamento cognitivo (2 em 1)От EverandTreinamento cerebral: Como funcionam a inteligência e o pensamento cognitivo (2 em 1)Рейтинг: 4.5 из 5 звезд4.5/5 (29)

- Técnicas Proibidas de Manipulação Mental e PersuasãoОт EverandTécnicas Proibidas de Manipulação Mental e PersuasãoРейтинг: 5 из 5 звезд5/5 (3)

- Focar: Elimine distrações, perfeccionismo e faça maisОт EverandFocar: Elimine distrações, perfeccionismo e faça maisРейтинг: 5 из 5 звезд5/5 (21)

- Os Códigos do Mindset da Prosperidade: destrave os bloqueios em sua mente e cresça em todos os aspectos de sua vidaОт EverandOs Códigos do Mindset da Prosperidade: destrave os bloqueios em sua mente e cresça em todos os aspectos de sua vidaОценок пока нет

- Simplificando o Autismo: Para pais, familiares e profissionaisОт EverandSimplificando o Autismo: Para pais, familiares e profissionaisОценок пока нет

- Diálogo entre Terapia do Esquema e Terapia Focada na Compaixão: Contribuição à integração em Psicoterapias Cognitivo-ComportamentaisОт EverandDiálogo entre Terapia do Esquema e Terapia Focada na Compaixão: Contribuição à integração em Psicoterapias Cognitivo-ComportamentaisРейтинг: 5 из 5 звезд5/5 (1)

- Como aprender mais rápido: Métodos e dicas para se tornar mais inteligenteОт EverandComo aprender mais rápido: Métodos e dicas para se tornar mais inteligenteРейтинг: 3.5 из 5 звезд3.5/5 (8)

- Psicanálise de boteco: O inconsciente na vida cotidianaОт EverandPsicanálise de boteco: O inconsciente na vida cotidianaРейтинг: 3.5 из 5 звезд3.5/5 (3)

- Treino de Habilidades Sociais: processo, avaliação e resultadosОт EverandTreino de Habilidades Sociais: processo, avaliação e resultadosРейтинг: 5 из 5 звезд5/5 (2)