Академический Документы

Профессиональный Документы

Культура Документы

Week 09 Fall15

Загружено:

Amit SinghИсходное описание:

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Week 09 Fall15

Загружено:

Amit SinghАвторское право:

Доступные форматы

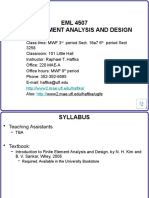

ISEE

561/661

–

Week

9

Prof. Silvestrini

Week 9 -‐ Fall 2015 1

Week 9 Plans

Topic Slides Reading

10/19/15 [M] WLS, GLS, Robust Reg. 1 – 27

10/21/15 [W]* Video Lab Lectures 28

10/23/15 [F] (Hw #4 Due) Principle Components 29 – 46

*I

will

be

aYending

the

Conference

on

Applied

Sta\s\cs

in

Defense

(last

conference

I

will

aYend

this

Fall),

so

our

lectures

on

Wednesday

will

be

replaced

by

the

Video

Lab

lectures.

You

will

answer

par\cipa\on

ques\ons

regarding

these

lab

components

and

they

will

help

you

complete

your

homework

that

is

due

at

the

end

of

the

week.

Week 9 -‐ Fall 2015 2

Week 9 Objec\ves and Outcomes

• Objec\ves: This week prepares you to address viola\on of the model

assump\ons. You will learn to modify the linear model, use an alterna\ve

to least squares regression, and use principle components in order to fix

viola\ons.

• Outcomes

– Iden\fy and describe the model assump\ons for the linear regression model

– Describe how weighted least squares works and when it would be used

– Describe robust regression and what it is used for

– Transform the response variables and evaluate the fit of the model with the

transformed response

– Transform regression variables and discuss how the model matrix is changed

– Add more complex terms to the regression model and discuss how the

addi\on of those terms change the model matrix

– Describe principle components and what it is used for

– Use principle components to make transforma\ons in your variables and then

use those variables in the fiYed model

Week 9 -‐ Fall 2015 3

Regression Model Building Process

Week 9 -‐ Fall 2015 4

Major Assump\ons

1. The error term ε has mean = zero

2. The error term ε has constant variance (σ2)

3. The errors are normally distributed

4. The errors are uncorrelated

5. The rela\onship between the response y and

the regression variables is correct

6. The regression variables are independent

Week 9 -‐ Fall 2015 5

Dealing With Viola\ons of the Major

Assump\ons (Assump\on#. Solu\on)

1. Fix y = Xβ

2. Transform y or use WLS

3. Robust regression

4. GLS or WLS

5. Add/remove X, add more complex X,

transform X

6. Variable selec\on, change variables, PCA

Week 9 -‐ Fall 2015 6

Week 8 – Changes to the Model

• Transforma\ons to y

– Goal: Stabilize the variance

– What transform: Use table or Box – Cox

• Changes to x

– Linear changes don’t change the fundamental

analysis

– Adding interac\on

• Help explain the response

• Interpreta\on if interac\on is significant

Week 9 -‐ Fall 2015 7

Week 9 Handout Ques\on 1

• 2 Factor interac\ons are included in the

model by mul\plying two x variables together

• If interac\on is present, we say that the

rela\onship between the response variable y

and xi is changed in the presence of xj

• 3 cases – Interac\on between:

– Con\nuous and con\nuous

– Con\nuous and categorical

– Categorical and categorical

Week 9 -‐ Fall 2015 8

Con\nuous x Con\nuous

Week 9 -‐ Fall 2015 9

Con\nuous x Categorical

Week 9 -‐ Fall 2015 10

Categorical x Categorical

Week 9 -‐ Fall 2015 11

Dealing With Viola\ons

• The solu\ons essen\ally fall into one of three

main categories:

– Fix the rela\onship y = Xβ (Week 8)

– Use something other than OLS (Week 9)

– Variable selec\on techniques (Week 10)

Week 9 -‐ Fall 2015 12

Alterna\ves to OLS

• Generalized least squares (GLS)

• Weighted least squares (WLS)

• Robust Regression

Week 9 -‐ Fall 2015 13

Two Alternate Least Squares

Approaches

• When the residuals are not independent, don’t

have constant variance, or both, we can apply an

alterna\ve fipng mechanism that takes these

correla\ons and/or changing variance structures

into account

• The math:

var ε =σ 2

Σ

• The two approaches are

– Generalized least squares

– Weighted least squares (Σ is diagonal)

Week 9 -‐ Fall 2015 14

Weighted Regression

Week 9 -‐ Fall 2015 15

WLS in R

• Add an argument into the lm func\on

• The argument is: weight = ?

• You must determine what the weight should

be based on the data

Week 9 -‐ Fall 2015 16

Determining the Weights

Week 9 -‐ Fall 2015 17

GLS

• We can es\mate the regression and weigh\ng

parameters using a likelihood-‐based method

that allows us to model the variance prior to

es\ma\on

• This can be implemented in R using the gls()

func\on

Week 9 -‐ Fall 2015 18

Robust Regression

• When the errors are normal, least squares

regression is best, but when errors are non-‐

normal, other methods may be considered

• Remember: least squares is rela\vely robust

with respect to small departures from

normality

• Most concerning: long tailed distribu\ons

• Fix: Using robust regression

Week 9 -‐ Fall 2015 19

Robust Regression Con\nued

• Maximum likelihood es\ma\on

• Class of robust es\mators that minimize a

func\on p of the residuals:

n

min ∑ ρ(e )

i =1

i

• Huber’s method is a compromise between

least squares and least absolute devia\on,

where ⎧⎪ x /2 2

if | x |≤ c

ρ(x) = ⎨

⎪⎩ c | x | −c / 2

2

otherwise

Week 9 -‐ Fall 2015 20

Robust Regression in R

• Install and load the MASS package

• Use the func\on rlm() with the same

arguments you would use in the lm() func\on

• For the summary output, you will not get R2 or

F sta\s\cs, nor will you get p-‐values for the

regression coefficients

• The general significance of the variables

remains the same and the conclusions are not

altered much

Week 9 -‐ Fall 2015 21

Pairs Plot of Delivery Data

10 20 30 40 50 60 70 80 5 10 15 20 25 30 0 200 600 1000 1400

80

80

70

70

60

60

50

50

40 y

40

30

30

20

20

10

10

30

25

20

x1

15

10

5

1400

1000

x2

600

200

0

0 200 600 1000 1400

Week 9 -‐ Fall 2015 22

Week 9 Handout

• You will answer ques\on 3 using slides 24 and

26

• You will answer ques\on 4 using slides 25 and

27

Week 9 -‐ Fall 2015 23

LS Regression on Delivery Data

Week 9 -‐ Fall 2015 24

Residual Plots for Delivery.lm

Residuals vs Fitted Normal Q-Q

9 9

3

5

Standardized residuals

2

Residuals

1

0

0

-1

-5

1

20 1

20

-2

10 20 30 40 50 60 70 -2 -1 0 1 2

Fitted values Theoretical Quantiles

Week 9 -‐ Fall 2015 25

Robust Reg on the Delivery Data

Week 9 -‐ Fall 2015 26

Residual Plots for Delivery.Robust

Residuals vs Fitted Normal Q-Q

8

9 9

10

6

Standardized residuals

5

4

Residuals

2

0

0

-2

24

-5

1

24

1

10 20 30 40 50 60 70 -2 -1 0 1 2

Fitted values Theoretical Quantiles

Week 9 -‐ Fall 2015 27

Wednesdays Class

• Watch the 3 week 9 videos and answer

ques\ons 5 – 7 on the Week 9 handout.

• Note: I recorded these last fall and they are

called ‘Lab 4’ but I refer to them in our

lectures, handouts, and mycourses as ‘Week 9

Labs’

Week 9 -‐ Fall 2015 28

Major Assump\ons

1. The error term ε has mean = zero

2. The error term ε has constant variance (σ2)

3. The errors are normally distributed Predictor

4. The errors are uncorrelated Assump\ons

5. The rela\onship between the response y and

the regression variables is correct

6. The regression variables are independent

Week 9 -‐ Fall 2015 29

Mul\collinearity

• The presence of mul\collinearity (near-‐linear

dependence among the regression variables)

has several effects on the ordinary least-‐

squares regression procedure

– A singular X’X matrix, meaning that the ability to

es\mate regression coefficients will be impacted,

thus the predic\on equa\ons will be poor

– Large variance and covariances for the least-‐

squares es\mators of the regression coefficients

Week 9 -‐ Fall 2015 30

What to Do about Mul\collinearity

• Do nothing

• Collect more data (and in the right places)

• Based on your knowledge of regressors,

remove regressors or combine regressors

• Use principle components to let the data help

you decide which linear combina\ons of

regressors to use

• Use variable selec\on strategies perform

variable selec\on

Week 9 -‐ Fall 2015 31

Collect More Data

• It is important to realize this is a great op\on

for unconfusing regression variables

• We are owen limited on the amount of data

we can collect and some\mes this isn’t an

op\on

• Keep in mind that even if you do collect more

data, you might s\ll have problems with

collinearity

Week 9 -‐ Fall 2015 32

Remove or Combine Regressors

Defense Language Ins\tute study concerning program graduate

effec\veness

x1, x2, …,x6 are a sequence of quarterly exam scores

Replace the 6 exam scores with

z1 = average of the 6 exam scores

z2 =

Week 9 -‐ Fall 2015 33

Week 9 -‐ Fall 2015 34

Week 9 -‐ Fall 2015 35

Week 9 -‐ Fall 2015 36

Week 9 -‐ Fall 2015 37

Week 9 -‐ Fall 2015 38

Week 9 -‐ Fall 2015 39

Week 9 -‐ Fall 2015 40

Property Valua\on Data

Week 9 -‐ Fall 2015 41

Property Value PC’s

Week 9 -‐ Fall 2015 42

Using the PC Scores

• We can use the results of the principle

components analysis to combine regression

variables in the model

Week 9 -‐ Fall 2015 43

Week 9 Handout Ques\on 9

Week 9 -‐ Fall 2015 44

Notes on PC

• PC is a good tool to explore the dimensionality of a space separate from

regression.

• Performing PC on the centered and scaled variables is equivalent to finding

the eigen values and vectors of the correla\on matrix of the x’s.

• Replacing m regressors with m’ < m linear combina\ons of the m regressors

will reduce the number of regressors. The trade-‐offs are:

– Unless you are lucky or very crea\ve, the principle components aren’t as easily interpreted

as the original variables

– You will introduce some bias.

• There

are

other

rota\ons

which

are

close

to

orthogonal,

but

try

to

force

loadings

to

0,

to

make

PC’s

more

interpretable.

You

might

use

the

PC

as

a

guide

to

how

you

want

to

combine

regressors.

• And,

just

because

you

went

to

the

trouble

to

find

PC’s

doesn’t

mean

that

they

will

be

important

in

the

regression.

Week 9 -‐ Fall 2015 45

R Code

> Property<-‐ read.csv(file.choose())

> Property

> pairs(Property)

> Property.lm <-‐ lm(y~., data = Property)

> summary(Property.lm)

> anova(Property.lm)

> drop1(Property.lm, test = "F")

> cor(model.matrix(Property.lm)[,-‐1])

> summary(Property.lm, correla\on = T)

> Property.pc <-‐ prcomp(Property[,c(2:10)])

> Property.pc

Week 9 -‐ Fall 2015 46

Вам также может понравиться

- Atlantis Is Discovered - Atlantis in Middle Danubian Depression (Pannonian Basin) A New Location of Atlantis IslandДокумент31 страницаAtlantis Is Discovered - Atlantis in Middle Danubian Depression (Pannonian Basin) A New Location of Atlantis Islandpaulct2004721260% (10)

- Lion's Path - Charles MuseeДокумент57 страницLion's Path - Charles MuseeBob Sagat75% (4)

- Six Sigma Black Belt - Cheat SheetДокумент11 страницSix Sigma Black Belt - Cheat Sheetrgrao85100% (5)

- Explaining Zambian Poverty: A History of Economic Policy Since IndependenceДокумент37 страницExplaining Zambian Poverty: A History of Economic Policy Since IndependenceChola Mukanga100% (3)

- 520l0553 PDFДокумент52 страницы520l0553 PDFVasil TsvetanovОценок пока нет

- Machine Learning Interview Questions.Документ43 страницыMachine Learning Interview Questions.hari krishna reddy100% (1)

- AD&D - Forgotten Realms - Menzoberranzan - EXTRAS - House Do'Urden RestrospectiveДокумент16 страницAD&D - Forgotten Realms - Menzoberranzan - EXTRAS - House Do'Urden RestrospectiveThiago RaulinoОценок пока нет

- Dsur I Chapter 08 Logistic RegressionДокумент41 страницаDsur I Chapter 08 Logistic RegressionDannyОценок пока нет

- Supervised Learning 1 PDFДокумент162 страницыSupervised Learning 1 PDFAlexanderОценок пока нет

- Week 2 Quiz - Coursera PDFДокумент1 страницаWeek 2 Quiz - Coursera PDFAmit Singh100% (2)

- Week 2 Quiz - Coursera PDFДокумент1 страницаWeek 2 Quiz - Coursera PDFAmit Singh100% (2)

- LH514 - OkokДокумент6 страницLH514 - OkokVictor Yañez Sepulveda100% (1)

- Soal Pat Bahasa Inggris Kelas 5Документ5 страницSoal Pat Bahasa Inggris Kelas 5Tini Bastuti Joyolaksono100% (1)

- Data Science Interview PreparationДокумент113 страницData Science Interview PreparationReva V100% (1)

- Introduction to Dynamic Programming: International Series in Modern Applied Mathematics and Computer Science, Volume 1От EverandIntroduction to Dynamic Programming: International Series in Modern Applied Mathematics and Computer Science, Volume 1Оценок пока нет

- Eco 6Документ96 страницEco 6Nebiyu WoldesenbetОценок пока нет

- Regression CookbookДокумент11 страницRegression CookbookPollen1234Оценок пока нет

- Chap3 - Multiple RegressionДокумент56 страницChap3 - Multiple RegressionNguyễn Lê Minh AnhОценок пока нет

- Regression Analysis Engineering StatisticsДокумент72 страницыRegression Analysis Engineering StatisticsLeonardo Miguel LantoОценок пока нет

- Solutions Manual To Accompany Business Forecasting With Business Forecastx 6th Edition 9780073373645Документ6 страницSolutions Manual To Accompany Business Forecasting With Business Forecastx 6th Edition 9780073373645RhondaCookqjdyg100% (70)

- Chapter 14Документ15 страницChapter 14UsamaОценок пока нет

- JKДокумент20 страницJKLA SyamsulОценок пока нет

- Chapter 1Документ16 страницChapter 1Abel TayeОценок пока нет

- Unit VДокумент27 страницUnit V05Bala SaatvikОценок пока нет

- XI Lecture 2020Документ47 страницXI Lecture 2020Ahmed HosneyОценок пока нет

- Lecture 5: Overview of Numerical Methods (Cont'd)Документ17 страницLecture 5: Overview of Numerical Methods (Cont'd)Anonymous ueh2VMT5GОценок пока нет

- Unit 7 - Forecasting and Time Series - Advanced TopicsДокумент54 страницыUnit 7 - Forecasting and Time Series - Advanced TopicsRajdeep SinghОценок пока нет

- Forecasting: 1. Qualitative 2. Time SeriesДокумент19 страницForecasting: 1. Qualitative 2. Time Seriesbittu00009Оценок пока нет

- Chapter 10: Multicollinearity Chapter 10: Multicollinearity: Iris WangДокумент56 страницChapter 10: Multicollinearity Chapter 10: Multicollinearity: Iris WangОлена БогданюкОценок пока нет

- Dummy Variables ManiДокумент25 страницDummy Variables ManiAnu AyyappanОценок пока нет

- OR Notes For MBAДокумент7 страницOR Notes For MBAalakaОценок пока нет

- 09.0 Integer Programming PDFДокумент77 страниц09.0 Integer Programming PDFAshoka VanjareОценок пока нет

- Regression PacketДокумент27 страницRegression PacketgedleОценок пока нет

- Logistic RegressionДокумент42 страницыLogistic RegressionmaniОценок пока нет

- 2015 03 12+lecture 9 The Property ModelДокумент64 страницы2015 03 12+lecture 9 The Property ModelochonogornaphtaliОценок пока нет

- Neural Networks For Machine Learning: Lecture 6a Overview of Mini - Batch Gradient DescentДокумент31 страницаNeural Networks For Machine Learning: Lecture 6a Overview of Mini - Batch Gradient DescentMario PeñaОценок пока нет

- CS550 RegressionДокумент62 страницыCS550 RegressiondipsresearchОценок пока нет

- Methods of Knowledge Engineering Classification - Algorithms, Logistic Regression - Lecture 4Документ37 страницMethods of Knowledge Engineering Classification - Algorithms, Logistic Regression - Lecture 4Pavel ZinevkaОценок пока нет

- CH 4 - ProblemsДокумент72 страницыCH 4 - Problemstemesgen yohannesОценок пока нет

- Lecture 1Документ67 страницLecture 1Ruba AqelОценок пока нет

- Regularization 1704650055Документ32 страницыRegularization 1704650055Vani agarwalОценок пока нет

- Maths Project LPPДокумент23 страницыMaths Project LPPchaudhary.vansh2307Оценок пока нет

- BA Module 5 SummaryДокумент3 страницыBA Module 5 Summaryshubham waghОценок пока нет

- Fluid Mechanics-I (ME321) : Dr. Ali Turab JafryДокумент22 страницыFluid Mechanics-I (ME321) : Dr. Ali Turab Jafryqaps lrkОценок пока нет

- U213Interpretation of The Slope and Y-Intercept of The Regression LineДокумент30 страницU213Interpretation of The Slope and Y-Intercept of The Regression LineAlitagtag College UniFAST TESОценок пока нет

- Session 12: Regression, Forecasting Techniques: January 2015 - April 2015Документ9 страницSession 12: Regression, Forecasting Techniques: January 2015 - April 2015selva2k25Оценок пока нет

- 9.3 - Checking Model ConditionsДокумент14 страниц9.3 - Checking Model ConditionsMichael WelkerОценок пока нет

- Sympy: Definite Integration Via Integration in The Complex Plane ProposalДокумент6 страницSympy: Definite Integration Via Integration in The Complex Plane ProposalrizgarmellaОценок пока нет

- CS550 Regression Aug12Документ63 страницыCS550 Regression Aug12dipsresearch100% (1)

- 15 Unsupervised LearningДокумент8 страниц15 Unsupervised LearningJiahong HeОценок пока нет

- FA20 Lab 2 Procedure Discussion Uncertainty PDFДокумент30 страницFA20 Lab 2 Procedure Discussion Uncertainty PDFAkaash SharmaОценок пока нет

- Raggousis Maria CIVE701 FINAL Fall2017 PDFДокумент32 страницыRaggousis Maria CIVE701 FINAL Fall2017 PDFRia RaggousisОценок пока нет

- Lesson 9 Transcendental FunctionsДокумент30 страницLesson 9 Transcendental FunctionsStevenzel Eala EstellaОценок пока нет

- Constraint Satisfaction Problems: Prof. Abbas AL-BakriДокумент41 страницаConstraint Satisfaction Problems: Prof. Abbas AL-BakriIhab AmerОценок пока нет

- Econometrics II CH 1Документ48 страницEconometrics II CH 1nigusu deguОценок пока нет

- Introduction To Modular Arithmetic: Dr. Arunachalam V Associate Professor, SENSEДокумент11 страницIntroduction To Modular Arithmetic: Dr. Arunachalam V Associate Professor, SENSEAnil Kumar GorantalaОценок пока нет

- ADM2304 Multiple Regression Dr. Suren PhansalkerДокумент12 страницADM2304 Multiple Regression Dr. Suren PhansalkerAndrew WatsonОценок пока нет

- CIVL2611 Handout 09Документ5 страницCIVL2611 Handout 09Da0% (1)

- EML 4507 Finite Element Analysis and Design: RD THДокумент18 страницEML 4507 Finite Element Analysis and Design: RD THchhetribharat08Оценок пока нет

- 1 s2.0 S0898122115001753 MainДокумент14 страниц1 s2.0 S0898122115001753 Mainjoginder singhОценок пока нет

- FEA Knowledge 1.5Документ20 страницFEA Knowledge 1.5APURV THE Black Horse DRVОценок пока нет

- Lecture 4Документ37 страницLecture 4bettieboomОценок пока нет

- Instructional Module For STEM Track 3: Basic Calculus LCCB Vision-MissionДокумент14 страницInstructional Module For STEM Track 3: Basic Calculus LCCB Vision-MissionJmОценок пока нет

- 2022 Gr10 Maths WRKBK ENGДокумент18 страниц2022 Gr10 Maths WRKBK ENGKarabo MahloОценок пока нет

- DoesACorrelationExist TeacherДокумент11 страницDoesACorrelationExist Teacherdiya joshiОценок пока нет

- BA Module 5 SummaryДокумент3 страницыBA Module 5 Summarymohita.gupta4Оценок пока нет

- Chapter 7 Polynomial Regression Models: Ray-Bing Chen Institute of Statistics National University of KaohsiungДокумент69 страницChapter 7 Polynomial Regression Models: Ray-Bing Chen Institute of Statistics National University of KaohsiungGeorge CamachoОценок пока нет

- Lecture 8Документ25 страницLecture 8Noman ShahzadОценок пока нет

- 2nd Sem Week 9Документ35 страниц2nd Sem Week 9Clover BlythОценок пока нет

- Flows, Wiley & Sons. Mathematical Programming, Thomson BooksДокумент3 страницыFlows, Wiley & Sons. Mathematical Programming, Thomson BooksAmit SinghОценок пока нет

- Lossless Online Bayesian Bagging: Herbert K. H. LeeДокумент9 страницLossless Online Bayesian Bagging: Herbert K. H. LeeAmit SinghОценок пока нет

- Lec SML Basic Theory 2Документ49 страницLec SML Basic Theory 2Amit SinghОценок пока нет

- Boosting BuehlmannДокумент52 страницыBoosting BuehlmannAmit SinghОценок пока нет

- Deming Regression: By:-Amit SinghДокумент29 страницDeming Regression: By:-Amit SinghAmit SinghОценок пока нет

- Toolbox Talks Working at Elevations English 1Документ1 страницаToolbox Talks Working at Elevations English 1AshpakОценок пока нет

- Attacks On Cryptosystems PDFДокумент18 страницAttacks On Cryptosystems PDFUjjayanta BhaumikОценок пока нет

- 0.6m (2ft) Low Profile Antennas Microwave Antenna SpecificationsДокумент15 страниц0.6m (2ft) Low Profile Antennas Microwave Antenna SpecificationsDarwin Lopez AcevedoОценок пока нет

- Eureka Forbes ReportДокумент75 страницEureka Forbes ReportUjjval Jain0% (1)

- Ohms LawДокумент16 страницOhms Lawmpravin kumarОценок пока нет

- Question Paper - GIAN - 19 - ModifiedДокумент4 страницыQuestion Paper - GIAN - 19 - Modifiedsayan mukherjeeОценок пока нет

- Smart Dust Technology Seminar ReportДокумент32 страницыSmart Dust Technology Seminar ReportSushan Upadhyay67% (3)

- Ficha-Tecnica-Tuberia MechДокумент2 страницыFicha-Tecnica-Tuberia MechCarlos salazarОценок пока нет

- The 50 Most Inspiring Travel Quotes of All TimeДокумент4 страницыThe 50 Most Inspiring Travel Quotes of All Timeungku1Оценок пока нет

- Miltel - Case Study, Steven Age, UKДокумент2 страницыMiltel - Case Study, Steven Age, UKAnit SahuОценок пока нет

- Saberon StratMan2Документ3 страницыSaberon StratMan2paredesladyheart18Оценок пока нет

- NHouse SelfBuilder Brochure v2 Jan19 LowresДокумент56 страницNHouse SelfBuilder Brochure v2 Jan19 LowresAndrew Richard ThompsonОценок пока нет

- Contactor - SchniderДокумент28 страницContactor - SchniderPramod DixitОценок пока нет

- Surface & Subsurface Geotechnical InvestigationДокумент5 страницSurface & Subsurface Geotechnical InvestigationAshok Kumar SahaОценок пока нет

- Responsible Living: Mantri DevelopersДокумент15 страницResponsible Living: Mantri Developersnadaf8Оценок пока нет

- De Thi Vao 10 Chuyen Hoa Nguyen Trai Hai Duong 20212022Документ2 страницыDe Thi Vao 10 Chuyen Hoa Nguyen Trai Hai Duong 20212022Trần Ngọc BíchОценок пока нет

- HandbikeДокумент10 страницHandbikeLely JuniariОценок пока нет

- Learning Guide: Central Texas College Department of NursingДокумент26 страницLearning Guide: Central Texas College Department of Nursingapi-3697326Оценок пока нет

- A Duality Principle For The Entanglement Entropy of Free Fermion SystemsДокумент12 страницA Duality Principle For The Entanglement Entropy of Free Fermion SystemsCroco AliОценок пока нет

- Power SupplyДокумент79 страницPower SupplySharad KumbharanaОценок пока нет

- Elements or Appurtenances of The Stilling BasinsДокумент21 страницаElements or Appurtenances of The Stilling BasinsAhmad PshtiwanОценок пока нет

- Sensors & Transducers: (Code: EI 401)Документ4 страницыSensors & Transducers: (Code: EI 401)Mayukh BiswasОценок пока нет

- Agricultural Machinery in PakistanДокумент19 страницAgricultural Machinery in PakistanBadar NiaziОценок пока нет