Академический Документы

Профессиональный Документы

Культура Документы

Biologia e Informatica

Загружено:

Guadalupe RodríguezОригинальное название

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Biologia e Informatica

Загружено:

Guadalupe RodríguezАвторское право:

Доступные форматы

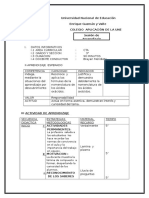

Bioinformática. Apuntes de clase.

Pág. 1

INFORMATICA Y BIOLOGIA

Si bien el término Bioinformática es aun reciente en su uso, no lo es tanto en su

contenido. En efecto, una gran parte de los esfuerzos de la informática se ha dirigido a emular

los procesos de control de la información en los seres vivos, esto es, a tratar de reproducir

artificialmente fenómenos biológicos o -al menos- sus efectos.

La incorporación a la informática, de términos y expresiones tan variados como

algoritmo genético, programación genética, autómata celular, androide, biónica, cerebro

electrónico, cibernética, darwinismo neural, inteligencia artificial, redes neuronales, robótica,

vida artificial, genómica -sin pretender ser exhaustivos- ilustra, en alguna medida, la

culminación de estos esfuerzos.

Pero, una breve incursión en su génesis histórica y desarrollo, nos permitirá -sin

duda- traer más luz sobre sus objetivos, contenido y métodos, que una simple descripción

estática, temporal y por tanto, dependiente.

El término informática es reciente, pues no fué creado hasta la primavera de 1962, por

el francés Philippe Dreyfus, como contracción de dos términos: información y automática.

Para su creador, este nuevo dominio era una rama de la automática: la automática de la

información.

La Informática actual puede ser considerada como la confluencia tecnológica de tres

corrientes históricas de búsqueda de soluciones por parte de la humanidad:

-Por una parte confluirían la automática y la robótica como intento de emulación de

los procesos motores y funcionales de los seres vivos.

-De otra, se encontraría la búsqueda constante de una automatización veloz y eficiente

de los procesos de cálculo.

-Por último, y en nuestra opinión, más trascendente, se sitúa el intento de emular

los procesos inteligentes del ser humano, de crear cerebros electrónicos.

LA AUTOMATICA.

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 2

La creación de figuras animadas -autómatas-, imitando seres vivos, y más o menos

complejas de acuerdo con el desarrollo científico y técnico de cada época, parece ser una

constante de la condición humana.

Sus raíces se pierden en la mitología, pero su apogeo llega en el siglo XVIII,

cuando los recursos mecánicos necesarios se encuentran suficientemente extendidos.

En efecto, ya en la época griega, Architas de Tarente, construyó una paloma que

batía las alas, y Demetrio de Farleria un caracol que se arrastraba. Incluso la Iliada, por

ejemplo, menciona la existencia de criadas de oro que ayudaban a Hefesto, el dios cojo, a

caminar.

Pero, fue Herón de Alejandría, quien, entre otros automatismos, construyó unos

actores "artificiales" que representaban una obra sobre la guerra de Troya.

Incluso, es en la mitología griega donde aparece la primera referencia a un ser humano

automático -androide-, Talos, gigantesco robot, obra de Dédalo, quien defendía a Creta de sus

enemigos.

Ya en la Edad Media, el teólogo alemán S. Alberto Magno construyó un autómata

articulado de bronce que hacía las veces de portero en su casa: cuando un visitante golpeaba

la puerta (movía el llamador) de la habitación del santo, se levantaba para abrirla y saludarle

con una reverencia.

Descartes construyó un autómata con forma humana, que llamaba mi hija Francine.

En la segunda mitad del siglo XVIII, los Droz -padre e hijo- construyeron tres

androides de tamaño natural, dos niños y una joven. Accionados por complejísimos

mecanismos de relojería, uno de los niños escribía mensajes de hasta cuarenta caracteres de

longitud.

Sin embargo, la construcción de autómatas y androides alcanzó su máximo

esplendor con las maravillosas creaciones de Vaucanson entre las que podemos citar el

flautista, que expuso en París en 1783. Superior a la media de los intérpretes humanos

mediterráneos, -según D'Alambert- era un androide sedente de 1.50m de altura. El aire que

accionaba el instrumento salía de su boca, siendo modulado por los labios, y los dedos

obturando o liberando los agujeros de la flauta, reproducían los sonidos de hasta doce

melodías distintas. También realizó el famoso pato, capaz de realizar innumerables

movimientos e incluso comer y hacer una digestión -mecánica- de los alimentos ingeridos.

A principios del siglo XIX se presentó el jugador de ajedrez del Barón de Kempelen,

con notable éxito; pero posteriormente se descubrió que el cajón de los mecanismos ocultaba

a un enano, gran experto en ese juego. En España, Torres Quevedo, construyó un ingenioso

autómata verdadero que jugaba un ajedrez limitado.

Ya en el siglo XX, aparece el término robot, al tiempo que esta figura se instala en la

conciencia popular. La obra de teatro Ros sum's Universal Robots, de Karel Capek,

representada en los años veinte, plantea el problema de las relaciones entre el hombre y una

raza de androides que ha creado: los robots, que terminan por aniquilar a éste. A este

respecto es bien conocida la obra del gran divulgador y escritor de ciencia ficción Isaac

Asimov, especialmente la saga que podemos denominar Robots, Fundación e Imperio,

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 3

que consta de -al menos- catorce obras.

EL CALCULO ARTIFICIAL.

La búsqueda de una mayor eficiencia y eficacia en los procesos de cálculo, es también

muy antigua, y tiene -a nuestro entender- dos etapas claramente diferenciadas:

La primera, que va de la prehistoria a los años treinta, comprende el desarrollo de

instrumentos como el ábaco y las máquinas de cálculo capaces de automatizar las cuatro

operaciones aritméticas básicas.

La segunda, se refiere al desarrollo, en los años cuarenta, de las calculadoras

gigantescas que desembocan en la creación de los primeros cerebros electrónicos.

El ábaco, que ya se conocía en Egipto nada menos que en el año 500 A.C., fue muy

utilizado por los romanos que denominaron calculi -cálculos- a las pequeñas piedras que se

disponían en las columnas.

Diversos artilugios -en alguna forma parecidos-, como el marcador de bolas de

oriente o los quipos de los incas, fueron desarrollados por otras culturas.

En 1614, el escocés John Napier -para simplificar y acelerar los cálculos- inventó

los logaritmos y publicó la primera tabla de éstos. Pronto, en 1620, Edmund Gunther

inventó un método más simple: éste situó los logaritmos en una línea recta. La multiplicación

y la división se realizaban añadiendo y sustrayendo segmentos por medio de un par de

divisores. El siguiente adelanto fue llevado a cabo por William Oughtred, que usó dos

escalas móviles de logaritmos como regla de cálculo.

El hombre siguió tratando de inventar mejores calculadores mecánicos. William

Schickardt, aleman, descubrió por primera vez, en 1623, una máquina calculadora que podía

sumar, restar, multiplicar y dividir.

Sin embargo, el primer calculador lo bastante seguro para ser lanzado comercialmente

fue inventado por un joven francés de diecinueve años en 1642. El joven Blas Pascal era

hijo de un recaudador de impuestos que buscaba la forma de reducir el trabajo de sumar.

El principio básico del mecanismo de ruedas de engranaje que inventó Pascal para su

calculador se aplicó a la mayor parte de los calculadores mecánicos durante un período de

unos trescientos años.

El inglés Samuel Morland construyó otras máquinas de calcular. En 1663

construyó una para cálculos trigonométricos. El siguiente gran paso en el perfeccionamiento

de las calculadoras lo dio el alemán Gottfried Wilhelm Leibnitz en 1671. Leibnitz

construyó su máquina con la idea de mejorar la obra de Pascal y de Morland. Consiguió crear

una calculadora que podía sumar, restar, multiplicar y dividir. También estudió el sistema

binario, que constituye la base de los ordenadores modernos y que había sido inventado

por el filósofo inglés Francis Bacon. Sin embargo, su interés era religioso y no científico,

pues intentaba construir una prueba matemática de la existencia de Dios.

La utilización de fichas perforadas fue también una aplicación temprana y

afortunada de los números binarios en la programación, donde 0 es el equivalente a ningún

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 4

agujero, y 1 significa que existe un agujero. De este modo, el sistema de perforación fue

un lenguaje temprano para comunicar instrucciones a los telares mecánicos.

En 1820, el francés Charles Xavier Thomas desarrolló el primer calculador

comercializado con éxito, que se llamó Aritmómetro.

El matemático inglés Charles Babbage fue quien inventó los

fundamentos teóricos del ordenador moderno. Babbage deseaba

imprimir automáticamente tablas de funciones matemáticas para su

uso en la ciencia y en la navegación. En 1822 presentó el primer

modelo de su Máquina de Diferencias. No satisfecho con esto,

Babbage imaginó una máquina mucho más poderosa y de utilidad

más general. Firmó un contrato con el gobierno inglés para la

construcción de un aparato que bautizó con el nombre de Máquina

Analítica, y planeó dotarla de un programa a seguir por medio de

fichas perforadas.

Babbage recibió, también, la ayuda en sus planes de programación de Lady Ada

Augusta, Condesa de Lovelace, hija del famoso poeta Lord Byron. Ella fue la primera

programadora. En 1979 se dio el nombre de ADA -en su memoria- a un lenguaje de

ordenador.

Además de Babbage, otro matemático inglés aportó una importante contribución al

desarrollo de los ordenadores. Georges Boole publicó en 1854 un libro titulado Una

Investigación de las Leyes del Pensamiento, sobre las cuales se fundamentan las

matemáticas de la Lógica y las probabilidades. Boole utilizó los números 1 y 0 para

representar la verdad o falsedad de los enunciados lógicos y sus conclusiones.

William S. Burroughs fabricó otro calculador, patentado en 1888. En el año siguiente

vendió cincuenta calculadoras. Desgraciadamente resultaron muy difíciles de manejar para

cualquiera que no fuera Burroughs. La única excepción fue un revendedor capaz de usar la

calculadora, pero que rehusó venderla porque ganaba más dinero llevándola, en una

carretilla, a las tabernas y haciendo apuestas sobre su exactitud.

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 5

En 1889 el gobierno de los Estados Unidos convocó un concurso para otorgar el

contrato del censo. El ganador indiscutible fue el Sistema Eléctrico de Tabulación, que

había sido concebido por primera vez en 1887 por Herman Hollerith. El método de

tabulación electromecánica y de clasificación de fichas perforadas para obtener información

fue la base de la industria del proceso de datos anterior a los ordenadores. La firma que fundó

Hollerith, la Tabulating Machine Company, promocionó extensamente este tipo de

máquina y finalmente se fusionó con varias otras compañías para formar, en 1924, la empresa

International Business Machines (IBM)), bajo la presidencia de Thomas Watson, padre.

En la primera mitad del siglo XX se desarrollaron también calculadores analógicos muy

complicados. Uno de ellos fue el sistema construido por E.G. Fischer y R.A. Harris en 1914.

Su Gran Cerebro de Latón podía predecir las mareas. En 1930, Vannevar Bush creó otro

calculador analógico. Su Analizador Diferencial podía resolver complicados problemas de

matemáticas.

En 1937 George Stibitz de los Laboratorios Bell, comenzó a diseñar un calculador de

relés. Fue puesto en operación en 1940 y recibió el nombre de Calculador de Complejos

porque podía realizar operaciones aritméticas con números complejos.

Ya en 1942, John V. Atasanoff y Clefford Berry construyeron un prototipo de calculador

electrónico.

Sin embargo, la máquina que fue objeto de la más intensa publicidad fue el Calculador e

Integrador Numérico Electrónico (ENIAC). Lo construyeron un físico, John Mauchly, y un

ingeniero electricista, J. Presper Eckert. Ocubaba unos 180 metros cuadrados, pesaba 30

toneladas, contenía 18.000 tubos de vacio, 70.000 resistencias, 10.000 condensadores, 6.000

interruptores, consumía 150.000 vatios, y costaba 400.000 dólares.

Un calculador universal, que utilizaba relés y partes mecánicas, fué construido en la

Universidad de Harvard en 1944. Recibió el nombre de Calculador Automático de Secuencias

Controlado o Mark 1. Media más de 15 metros de longitud y contenía 760.000 partes

conectadas por unos 800 kilómetros de cables. El Mark 1 podía realizar todas las operaciones

básicas aritméticas y tenía secuencias especiales para calcular funciones matemáticas tales

como logaritmos y senos. A esta máquina siguieron otras de la misma serie (Mark 2, Mark 3),

con características mejoradas.

LOS "CEREBROS" ARTIFICIALES.

A partir de finales de la década de los cuarenta aparecen los primeros cerebros

electrónicos, posteriormente llamados ordenadores. Philippe Breton considera que son

máquinas enteramente automáticas, que disponen de una extensa memoria y de una

unidad de mando interna y que efectúan operaciones lógicas de cálculo y de tratamiento de la

información gracias a algoritmos grabados.

La base teórica de la noción de algoritmo se debe a Turing, aunque ya en el siglo XIII

fue traducido al latín un texto escrito cinco siglos antes por el matemático árabe

Mohammed Ibn Musa Abu Djefar Al-Khwarizmi, que comenzaba con la frase: Algoritmi

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 6

dixit ... y era el primer tratado completo de álgebra.

Podemos definir un algoritmo como el conjunto completo de reglas que permiten la

resolución de un problema dado. Turing describió una máquina hipotética (la máquina de

Turing) capaz de resolver todos los problemas susceptibles de ser planteados en términos de

algoritmos. Turing, como Von Neumann, tenía en mente construir un cerebro. Los estados

de pensamiento eran para él equivalentes a las instrucciones de su máquina.

Von Neumann, que formaba parte de un grupo de investigadores empeñados en

construir un modelo reducido de cerebro humano, escribe en 1945, un corto texto: First

Draft of a Report on the EDVAC, en el que quedan

definidos los rasgos característicos de los ordenadores

actuales. Su principal diferencia respecto a la última gran

calculadora (el ENIAC) radicaba en que la nueva máquina

ya no calculaba; trataba información binaria, lo que le

permitía -indirectamente- efectuar cálculos.

Sus ideas definen lo que ahora se denomina una

Máquina von Neumann. La arquitectura fundamental del

ordenador en las máquinas modernas está basada en las

ideas de von Neumann, aunque los procesos de

integración de componentes estén consiguiendo unas prestaciones no soñadas entonces.

Tanto los trabajos de Von Neumann como los de Turing iban en la misma dirección:

construir potentes instrumentos de cálculo adaptados al tratamiento de una amplia

variedad de problemas y que fueran al mismo tiempo modelos lo más próximos posibles al

cerebro humano.

Las primeras realizaciones prácticas para imitar un cerebro humano habían sido

desarrolladas por el lógico Pitts y el biólogo McCulloch, cuyos trabajos iniciales, publicados

en 1943, inspiraron explícitamente a Von Neumann en su visión de la organización lógica de

la nueva máquina. Su atracción por la lógica binaria estaba directamente unida a la idea de

que el cerebro humano funcionaba globalmente de forma binaria.

Desde 1940, Norbert Wiener estaba trabajando en el desarrollo de ordenadores

especializados en la solución de problemas determinados y formó un grupo de trabajo

interdisciplinar en el M.I.T., Este grupo, básicamente formado por matemáticos y fisiólogos,

sentó las bases de lo que a partir de 1947 se ha conocido como Cibernética.

En 1943 se publicaron tres artículos teóricos. En el primero, Wiener, Rosenblueth y

Bigelow en el MIT, sugirieron distintas formas de conferir fines y propósitos a las máquinas;

es decir, de hacerlas teleológicas. En el segundo, McCulloch, del Colegio de Medicina de

la Universidad de Illinois y Pitts, matemático del MIT, pusieron de manifiesto de qué modo

las máquinas podían emplear los conceptos de lógica y abstracción, y demostraron cómo

cualquier ley de entrada-salida podía modelizarse mediante una red de neuronas. Finalmente,

Craik de la Universidad de Cambridge, propuso que las máquinas empleasen modelos y

analogías en la resolución de problemas.

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 7

Norbert Wiener publica en 1948 su obra Cybernetics, or control and communication

in the animal and the machine, donde se establece el concepto de retroalimentación

(feedback) en ingeniería y en biología.

En 1951, se convoca en París una conferencia para tratar de las nuevas máquinas y las

consecuencias de su empleo. Acuden cerca de trescientos investigadores de todo el

mundo, entre ellos futuros premios Nobel como Louis de Bloglie, que anuncia que el

coloquio se dividirá en tres secciones, una de ellas denominada Las grandes máquinas, la

lógica y la fisiología del sistema nervioso. A partir de entonces ha sido una constante

de este tipo de reuniones, la dedicación de una sección a estos temas, de raíz biológica, que

en los últimos años se han venido denominando bioinformática.

Newell, Shaw y, el que años más tarde sería premio nobel, Simon, iniciaron la

construcción de un programa para la demostración automática de teoremas, el denominado,

General Problem Solving, sistema capaz de organizar una serie de subprogramas

orientados a un fin.

Meses más tarde, en el verano de 1956, un grupo de investigadores se reunió en el

Darmouth College para discutir la posibilidad de construir máquinas inteligentes. Formaban

parte del grupo de Darmouth, entre otros: Samuel que ya había escrito un programa para jugar

a las damas capaz de aprender de su propia experiencia; McCarthy que se dedicaba a la

realización de sistemas que llevaran a cabo razonamientos de sentido común; Minsky que

trabajaba sobre un problema de geometría plana con la esperanza de conseguir que el

ordenador emplease razonamiento analógico sobre figuras; Selfridge, que centraba su

atención en el reconocimiento de formas por computador. Estos, con los ya citados Newell,

Shaw y Simon, y algún otro, pueden ser considerados los padres de la Inteligencia

Artificial, y el verano de 1956 en Darmouth, la fecha y el lugar de nacimiento de ese

dominio de conocimiento, hoy académica y científicamente reconocido.

John von Neumann, buscando soluciones por analogías biológicas para el avance de la

informática, publica en 1958 su obra The Computer and the Brain. En ese mismo año,

Frank Rosenblatt publica un trabajo titulado The perceptron: a probabilistic model for

information storage and organization in the brain, que tendría un gran impacto en las

investigaciones realizadas durante la década de los sesenta.

En 1960, seiscientas personas, entre biólogos, ingenieros, matemáticos, físicos

y psicólogos, fueron invitados por la USAF (Fuerza Aérea de los Estados Unidos) a un

congreso en Dayton (Ohio) donde se presentó una nueva ciencia: La Biónica. Esta quedó

definida como la ciencia de los sistemas que tienen un funcionamiento copiado del de los

sistemas naturales o que presentan características específicas análogas a las de los mismos.

En esta época comienzan a desarrollarse algunos sistemas de proceso de lenguaje

natural sobre ordenadores. A este respecto podemos citar -por el gran impacto que tuvo en su

momento- el programa Eliza, que emulaba a un psicoanalista en un diálogo interactivo con el

usuario, y que fue escrito por Joseph Weizanbaun, en el MIT, en 1966.

Durante los años siguientes se incide en tratar de dotar a los ordenadores de

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 8

capacidad de aprendizaje, con no pocas decepciones en la comunidad científica. Sin embargo,

en los últimos años de la década de 1970 y especialmente en los años ochenta, se ha asistido

a una explosión de trabajos en este campo, entre los que merecen citarse los referentes a los

modelos conexionistas (emulando el cerebro), con aprendizajes muy elaborados y con

una gran incidencia en el reconocimiento de patrones y en la robótica. En este último

campo la aplicación de algoritmos de aprendizaje dependientes de ambiente posibilitan

la superación de los tradicionales conceptos (y limitaciones) de la Automática, dando lugar

a robots que son capaces de adaptar sus funcionamientos a los requerimientos dinámicos del

ambiente de trabajo. Solo por citar algunos ejemplos, existen en la actualidad proyectos que

abarcan desde la exploración, por parte de este tipo de robots, de ambientes tales como Marte

o el fondo marino, hasta la conducción automática de vehículos.

En los últimos años 80 y especialmente en los que han transcurrido de la década de

los 90 ha emergido con fuerza una idea nueva: es posible encontrar en la biología (en

campos tales como la genética, la bioquímica, la etología y, por supuesto, la

neurobiología) modelos cuya aplicación informática a la robótica pueden suponer una

verdadera revolución, en las fronteras que lo posible marca actualmente en la misma. Y esta

moneda tiene, como todas, su reverso: es posible encontrar en la modelización informática

de las conductas biológicas que es una de las partes de lo que denominamos bioinformática,

explicaciones a ciertos datos de la realidad de los seres vivos que ayuden a comprender, por

ejemplo, los medios por los que determinadas colonias de insectos sin grandes capacidades

cerebrales (como por ejemplo las hormigas) son capaces de poner en pie obras de una

envergadura practicamente inabordable para otros animales "superiores". Entre los

postulantes de este doble enfoque se encuentran nada menos que los dos premios nobeles

Gerald Edelman y Francis Crick. El primero de ellos ha desarrollado una serie de autómatas

(denominada Darwin) de la que ya está en funcionamiento el cuarto prototipo (DARWIN IV),

en el que se encuentran plasmadas gran parte de las aportaciones que sobre el

desarrollo del cerebro le hicieron merecedor de tal galardón. Un renovado interés en el

desarrollo de modelos que permitan explicar determinadas facetas de la base de la

inteligencia en los seres humanos (sin duda su caracter mas distinguible como especie) ha sido

expuesto por biólogos del relieve histórico de los, ya citados, premios nobeles Gerald Edelman

y Francis Crick.

Igualmente, sus implementaciones físicas con procesamiento distribuido, en paralelo,

han constituido la base de lo que se ha venido en denominar quinta generación de

ordenadores.

Paralelamente, a partir del trabajo de Holland, en 1975, Adaptation in Natural and

Artificial Systems, se trata de implementar en los ordenadores una nueva táctica de

aprendizaje, inspirada en la selección natural. Estos sistemas reciben el nombre de

Algoritmos Genéticos (AG) y se han desarrollado enormemente desde entonces; primero

fundamentalmente como mecanismos de optimización y clasificación, y actualmente como

sistemas que pueden evolucionar a versiones mejores de si mismos. Ello está extendiendo

rápida y dramáticamente la capacidad de los AG en vías que somos incapaces de predecir.

Paralelamente, se han desarrollado otras técnicas inspiradas en procesos evolutivos, como las

Estrategias Evolutivas, la Programación Genética, la Programación Evolutiva y los Sistemas

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 9

Clasificadores.

Por último hay que incidir en el tremendo desarrollo de los Sistemas Basados en el

Conocimiento, que acumulan la mayor cantidad de recursos invertidos en el campo de la

Inteligencia Artificial. En estos sistemas se trata de emular la capacidad de decisión basada en

el conocimiento de expertos humanos en campos específicos, con éxito comprobado en casi

todos los campos de la ciencia y la industria.

El origen de estos sistemas hay que buscarlo en los primeros Sistemas Expertos,

definidos por Feigenbaum como programas inteligentes que utilizan conocimientos y

procedimientos de inferencia para resolver problemas que son lo suficientemente difíciles

como para requerir experiencia humana para su correcta solución. Si bien los primeros

sistemas creados, como DENDRAL (para deducir la estructura de un compuesto

desconocido) y MYCIN (diagnóstico y tratamiento de enfermedades infecciosas de la sangre)

se mostraron incapaces de aprender, hoy en día, con la incorporación de técnicas basadas en

redes neuronales, algoritmos genéticos y otras, se están consiguiendo Sistemas "Híbridos" de

gran potencia y con capacidad de autoevolución y aprendizaje.

En todo caso, podemos considerar la Bioinformática* como un cuerpo de

conocimientos emergente, frontera entre la Biología y la Informática, y del que es imposible

predecir su futuro, dado su crecimiento de tipo exponencial.

Por tanto, la Bioinformática se nutre especialmente de dos grandes áreas del conocimiento, las

ciencias biológicas y las ciencias de la computación. Esto implica la existencia de dos

conceptos y dos grandes líneas de trabajo:

La primera en la cual las ciencias de la computación utilizan modelos de la biología, ejemplo

de ello lo constituyen las redes neurales, los algoritmos genéticos, la vida artificial y los

sistemas basados en conocimiento, entre otras.

La segunda en la cuál las ciencias biológicas utilizan modelos y herramientas de las ciencias de

la computación, como la genómica.

¿Qué es la Genómica?

La Genómica es la rama de la biología que se encarga del estudio de los genomas.

A diferencia de la genética clásica que a partir de un fenotipo, busca el o los genes

responsables de dicho fenotipo, la genómica tiene como objetivo predecir la función de los

genes a partir de su secuencia.

Muchas veces, la genómica es usada como sinónimo de otras áreas de estudio relacionadas

como son la proteómica y la transcriptómica por ejemplo. Las ciencias genómicas han tenido

un importante auge en los últimos años, sobre todo gracias a las avanzadas técnicas de

secuenciación, a los avances en informática, y a las técnicas cada vez más sofisticadas para

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Bioinformática. Apuntes de clase.

Pág. 10

realizar análisis de genomas completos. En varios países como EUA, la Unión Europea y

Japón se han realizado enormes proyectos para secuenciar el genoma de diversos organismos

modelo. El más conocido es el Proyecto Genoma Humano. En la actualidad se cuenta además

con importantes servidores de acceso público, como el del NCBI (National Center for

Biotechnology Information), que permiten que cualquier usuario con conexión a Internet

acceda a la secuencia completa del genoma de decenas de organismos y a las secuencias de

cientos de miles de genes de distintos organismos.

A diferencia de la genética clásica que a partir de un fenotipo, generalmente mutante, busca el

o los genes responsables de dicho fenotipo, la genómica tiene como objetivo predecir la

función de los genes a partir de su secuencia.

La Proteómica puede definirse como la genómica funcional a nivel de proteínas. Es la ciencia

que correlaciona las proteínas con sus genes, estudia el conjunto completo de proteínas que se

pueden obtener de un genoma. La proteómica intenta resolver preguntas como: ¿Qué función

tienen las proteínas?, ¿Qué tipo de modificaciones postransduccionales sufren las proteínas y

cuál es su función?, ¿Cómo varían las proteínas de una célula enfrentada a distintas

condiciones ambientales?.

Conocer el proteoma de un organismo es tener una imagen dinámica de todas las proteínas

expresadas por ese organismo, en un momento dado y bajo determinadas condiciones

concretas de tiempo y ambiente. Las células expresan varios miles de proteínas diferentes y

cada una de ellas puede experimentar numerosas modificaciones en respuesta a

microambientes diferentes.

También es posible entender la proteómica como el conjunto de técnicas que permiten analizar

el conjunto de proteínas presentes en la célula en determinado momento, o sea, el proteoma.

Estas técnicas incluyen el 2D-PAGE (electroforesis de poliacrilamida de dos dimensiones) y la

MS (espectrometría de masas). La manera más fácil de hacer un estudio proteómico es

comparar los proteomas de dos condiciones y observar sus diferencias.

Según esta escuela, la Bioinformática es la aplicación de los ordenadores y los métodos

informáticos en el análisis de datos experimentales y simulación de los sistemas biológicos.

Una de las principales aplicaciones de la bioinformática sería la simulación, la minería de datos

(data mining) y el análisis de los datos obtenidos en el estudio de moléculas relevantes para la

vida, por ej. el ADN/ARN/genoma (Proyecto Genoma Humano) o las proteínas, así como el

diseño y desarrollo de herramientas tales como: bases de datos, directorios web, etc.

Depto. de Matemática Aplicada (Biomatemática) - Julio Alonso.

Вам также может понравиться

- Anexo IДокумент13 страницAnexo IGuadalupe RodríguezОценок пока нет

- Tinción GramДокумент2 страницыTinción GramGuadalupe RodríguezОценок пока нет

- Claves Dicotomicas de Arboles de El RodeoДокумент32 страницыClaves Dicotomicas de Arboles de El RodeoGuadalupe RodríguezОценок пока нет

- Tendemos A Pensar Que Los Grandes Problemas de Nuestra Época Se Resuelven Con Grandes IntervencionesДокумент3 страницыTendemos A Pensar Que Los Grandes Problemas de Nuestra Época Se Resuelven Con Grandes IntervencionesGuadalupe RodríguezОценок пока нет

- Relación Con El Medio Ambiente Dominio de TecnologíaДокумент3 страницыRelación Con El Medio Ambiente Dominio de TecnologíaGuadalupe RodríguezОценок пока нет

- Relación Con El Medio Ambiente Dominio de TecnologíaДокумент3 страницыRelación Con El Medio Ambiente Dominio de TecnologíaGuadalupe RodríguezОценок пока нет

- Tarea MarcelaДокумент1 страницаTarea MarcelaGuadalupe RodríguezОценок пока нет

- La Guia Secreta de Harry Potter - Pablo C ReynaДокумент157 страницLa Guia Secreta de Harry Potter - Pablo C ReynaDiomer Avendaño100% (5)

- CasoДокумент3 страницыCasoGuadalupe RodríguezОценок пока нет

- Tendemos A Pensar Que Los Grandes Problemas de Nuestra Época Se Resuelven Con Grandes IntervencionesДокумент3 страницыTendemos A Pensar Que Los Grandes Problemas de Nuestra Época Se Resuelven Con Grandes IntervencionesGuadalupe RodríguezОценок пока нет

- Ley 645 MypymeДокумент14 страницLey 645 MypymeEl_nicaОценок пока нет

- Más Detalle o Menos DetalleДокумент4 страницыMás Detalle o Menos DetalleGuadalupe RodríguezОценок пока нет

- Teorías ClásicasДокумент3 страницыTeorías ClásicasGuadalupe RodríguezОценок пока нет

- Tendemos A Pensar Que Los Grandes Problemas de Nuestra Época Se Resuelven Con Grandes IntervencionesДокумент3 страницыTendemos A Pensar Que Los Grandes Problemas de Nuestra Época Se Resuelven Con Grandes IntervencionesGuadalupe RodríguezОценок пока нет

- Más Detalle o Menos DetalleДокумент4 страницыMás Detalle o Menos DetalleGuadalupe RodríguezОценок пока нет

- EnsayoДокумент2 страницыEnsayoGuadalupe RodríguezОценок пока нет

- Inflación TargetingДокумент1 страницаInflación TargetingGuadalupe RodríguezОценок пока нет

- Citas BibliograficasДокумент3 страницыCitas BibliograficasMarlingRosalesPrado100% (1)

- Concepto de Valor AgregadoДокумент2 страницыConcepto de Valor AgregadoGuadalupe RodríguezОценок пока нет

- Relación de La Micro y La MacroeconomíaДокумент2 страницыRelación de La Micro y La MacroeconomíaAmanda Alicia Aldana Cortés67% (3)

- Caso Gestion de RecursosДокумент2 страницыCaso Gestion de RecursosGuadalupe RodríguezОценок пока нет

- EjemploДокумент12 страницEjemploGuadalupe RodríguezОценок пока нет

- EjemploДокумент12 страницEjemploGuadalupe RodríguezОценок пока нет

- Teoría clásica vs teoría marginal de la distribuciónДокумент16 страницTeoría clásica vs teoría marginal de la distribuciónGuadalupe RodríguezОценок пока нет

- Expocision BiologiaДокумент2 страницыExpocision BiologiaGuadalupe RodríguezОценок пока нет

- EjemploДокумент2 страницыEjemploGuadalupe RodríguezОценок пока нет

- Concepto de Valor AgregadoДокумент2 страницыConcepto de Valor AgregadoGuadalupe RodríguezОценок пока нет

- CocoДокумент2 страницыCocoGuadalupe RodríguezОценок пока нет

- EjemploДокумент2 страницыEjemploGuadalupe RodríguezОценок пока нет

- Las Ventajas de Ser Un Marginado - Stephen ChboskyДокумент10 страницLas Ventajas de Ser Un Marginado - Stephen ChboskyIliannsj NuñezОценок пока нет

- Medir magnitudes con el Sistema InternacionalДокумент3 страницыMedir magnitudes con el Sistema InternacionalJulian PopovОценок пока нет

- DislexiaДокумент15 страницDislexiaGISSEL ALAMAОценок пока нет

- Galeano, Eduardo - El Miedo MandaДокумент2 страницыGaleano, Eduardo - El Miedo MandaFernando MendozaОценок пока нет

- Process JSPДокумент2 страницыProcess JSPYosverPenaОценок пока нет

- SSOMA-PETS-07 Relleno y CompactaciónДокумент7 страницSSOMA-PETS-07 Relleno y CompactaciónLuis Mendoza ChugnasОценок пока нет

- TEST AFINACION DanielДокумент10 страницTEST AFINACION DanielJOTA CrazyОценок пока нет

- (HNF) High School DXD Volume 04Документ208 страниц(HNF) High School DXD Volume 04Williams Ojeda BachmannОценок пока нет

- Los Angeles Con Nosotros PDFДокумент336 страницLos Angeles Con Nosotros PDFDalila Saric100% (6)

- Ejercicio Urbanismo Que No Me GustaДокумент18 страницEjercicio Urbanismo Que No Me GustaJonathan HernándezОценок пока нет

- Referencias Del Torno CopiadorДокумент9 страницReferencias Del Torno CopiadorrousbelОценок пока нет

- Taller Superficies CuadraticasДокумент13 страницTaller Superficies CuadraticasSCANDALS SCANDALSОценок пока нет

- Programacion Academica 11 03 2019 09 - 50 - 42Документ7 страницProgramacion Academica 11 03 2019 09 - 50 - 42Camila Ximena Anaya AlarcónОценок пока нет

- OXACIDOSДокумент6 страницOXACIDOSBryan Mendieta QuiñonesОценок пока нет

- Sistematizacion de Experiencias Educativas 1Документ13 страницSistematizacion de Experiencias Educativas 1Efrain Quispe QuispeОценок пока нет

- OctopodaДокумент40 страницOctopodaALEXANDER RMОценок пока нет

- Actividad 2 La Importancia de Las MatemáticasДокумент7 страницActividad 2 La Importancia de Las MatemáticasJessica RojasОценок пока нет

- Aceite Dielectrico para TransformadoresДокумент24 страницыAceite Dielectrico para TransformadoresEduardo Villanueva PríncipeОценок пока нет

- Aceleración de La Enseñanza para Alumnos Superdotados Argumentos Favorables y ContrariosДокумент26 страницAceleración de La Enseñanza para Alumnos Superdotados Argumentos Favorables y Contrariosdanielbox210% (1)

- Supercep2008 PDFДокумент150 страницSupercep2008 PDFJosé Carlos ArruéОценок пока нет

- Laboratorio 3 TermodinamicaДокумент5 страницLaboratorio 3 TermodinamicaLucho HCОценок пока нет

- Tema 2Документ17 страницTema 2evaseva1996Оценок пока нет

- Semana N°9 Grupo 8Документ63 страницыSemana N°9 Grupo 8Jenifer NausinОценок пока нет

- Mapa Conceptual - Tecnicas y Recoleccion de DatosДокумент3 страницыMapa Conceptual - Tecnicas y Recoleccion de Datospriscila ramirez zamoraОценок пока нет

- Evaluación final de mercadotecniaДокумент12 страницEvaluación final de mercadotecniaCampeonatos MobileОценок пока нет

- EstructuraBDДокумент6 страницEstructuraBDJuan PaezОценок пока нет

- Actividades empresariales y áreas de gestiónДокумент9 страницActividades empresariales y áreas de gestiónelizabeth suarezОценок пока нет

- Presupuesto Etapa 2 Encinas QuilinДокумент410 страницPresupuesto Etapa 2 Encinas QuilinCristian LarrainОценок пока нет

- Estudio de costos de transmisión y subestaciones de la línea de 220 kV Paragsha-Vizcarra-Conococha-Cajamarca-CarhuaqueroДокумент45 страницEstudio de costos de transmisión y subestaciones de la línea de 220 kV Paragsha-Vizcarra-Conococha-Cajamarca-CarhuaqueroLioAldair Madden MirandaОценок пока нет