Академический Документы

Профессиональный Документы

Культура Документы

Redes Neurais Artificiais - Lista de Exercícios

Загружено:

Romeu BerthoОригинальное название

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Redes Neurais Artificiais - Lista de Exercícios

Загружено:

Romeu BerthoАвторское право:

Доступные форматы

ICMC-USP

Lista de Exercı́cios - Parte 1

SCC-0570 - Redes Neurais

1o. Semestre de 2019 - Prof. João Luı́s - PAE: Fernando Aguiar

1. Um neurônio tem uma função de ativação ϕ(v) definida pela função logı́stica da Eq. (1),

onde v é o campo local induzido, e o parâmetro de inclinação a está disponı́vel para

ajuste. Seja x1 , x2 , ..., xm os sinais de entrada aplicados aos nós fonte do neurônio, e b o

bias. Para conveniência de apresentação, deseja-se absorver o parâmetro de inclinação a

no campo local induzido v escrevendo a Eq. (2).

1

ϕ(v) = (1)

(1 + exp(−av))

1

ϕ(v) = (2)

(1 + exp(−v))

Como você modificaria as entradas x1 , x2 , ..., xm para a Eq. (2) produzir a mesma saı́da

obtida pela Eq. (1)? Justifique sua resposta.

2. Um neurônio j recebe entradas de outros 4 neurônios cujos nı́veis de atividades são: 10,

-20, 4 e -2. Os pesos sinápticos respectivos são: 0.8, 0.2, -1.0 e -0.9. Calcule a saı́da do

neurônio j para as seguintes situações:

(a) o neurônio é linear, isto é, sua função de transferência ou ativação é linear.

(b) o neurônio é representado por um modelo de McCulloch-Pitts. Assuma que o bias

aplicado ao neurônio inicialmente é zero e depois é igual a 0.5.

(c) o neurônio é baseado na função logı́stica da equação 2.

3. Uma rede feedforward totalmente conectada tem 10 nós fonte, 2 camadas escondidas, uma

com 4 neurônios e a outra com 3 neurônios, e um único neurônio de saı́da. Construa um

grafo arquitetural desta rede.

4. Considere uma rede feedforward multicamadas, com todos os neurônios operando em suas

regiões lineares (segmento linear de suas funções de ativação não-lineares, e.g. sigmóides).

Justifique a afirmação de que tal rede é equivalente a uma rede feedforward de única

camada.

5. Desenhe o grafo arquitetural de uma rede recorrente totalmente conectada com 5 neurônios,

mas nenhuma auto-retro-alimentação.

6. Uma rede recorrente tem 3 nós fonte, 2 neurônios escondidos e 4 neurônios de saı́da.

Construa um grafo arquitetural que descreva tal rede.

Página 1 de 4 Continua na próxima página. . .

ICMC-USP

Lista de Exercı́cios - Parte 1

SCC-0570 (continuação)

7. Como se dá o aprendizado nas redes neurais artificiais?

8. Explique, em palavras, o que representa a regra delta.

9. O aprendizado Hebbiano é considerado aprendizado não supervisionado, apesar do trei-

namento ser feito com pares entrada-saı́da. Comente esta afirmação [1].

10. Quais são os principais paradigmas de aprendizado? Descreva caracterı́sticas de cada

um deles e indique a quais tipos de problemas cada um se aplica [1].

11. Diferencie aprendizado não supervisionado de aprendizado supervisionado [1].

12. Explique a diferença entre a hipótese de Hebb

∆wkj (n) = ηyk (n)xj (n) (3)

e a hipótese da covariância

∆wkj = η(xj − x̄)(yk − ȳ) (4)

13. Como você classificaria o aprendizado competitivo? Supervisionado? Não supervisio-

nado? Outro?

14. O aprendizado por reforço pode ser visto como um tipo de aprendizado supervisionado

ao se utilizar o sinal de reforço como sendo alguma medida da distância entre a saı́da

atual do sistema e a saı́da desejada. Discuta a relação entre aprendizado por reforço e

aprendizado supervisionado [1].

15. O perceptron é um classificador de padrões linear. Justifque esta afirmação.

16. O perceptron pode ser usado para executar numerosas funções lógicas. Demonstrar a

implementação das funções lógicas binárias AND, OR e NOT. Entretanto, uma limitação

básica do perceptron é que ele não pode implementar o OU-EXCLUSIVO. Explique a

razão para esta limitação.

17. Considere um conjunto de pontos referentes a uma classe C1 está distribuı́do próximo

ao ponto (8,5) no plano XY . Os pontos não pertencentes à classe C1 são externos à

região em que os pontos de C1 são amostrados e correspondem à classe C2 . Mostre a

solução de uma rede perceptron para fazer a separação das duas classes C1 e C2 , sem

utilizar algoritmos de treinamento convencionais. Obtenha a solução fazendo apenas a

interpretação geométrica do problema. Discuta também como a variância da distribuição

dos elementos da classe C1 afeta o problema da classificação.

18. Verifique que as equações 5, 6, 7 e 8 abaixo

(

+1, se v > 0

sgn(v) = (5)

−1, se v < 0

Página 2 de 4 Continua na próxima página. . .

ICMC-USP

Lista de Exercı́cios - Parte 1

SCC-0570 (continuação)

y(n) = sgn[wT (n)x(n)] (6)

+1, se x(n) pertence a classe C1

(

d(n) = (7)

−1, se x(n) pertence a classe C2

w(n + 1) = w(n) + η[d(n) − y(n)]x(n) (8)

que resumem o algoritmo de convergência do perceptron, são consistentes com:

1. “Se o n-ésimo termo do conjunto de treinamento x(n) é corretamente classificado

por w(n) computado na n-ésima iteração do algoritmo, nenhuma correção é feita

ao vetor de pesos de acordo com a regra

(a) w(n + 1) = w(n), se wT x(n) > 0 e x(n) pertence à classe C1 .

(b) w(n + 1) = w(n), se wT x(n) ≤ 0 e x(n) pertence à classe C2 .

2. Caso contrário, o vetor de pesos é atualizado de acordo com a regra

(a) w(n + 1) = w(n) − η(n)x(n), se wT (n)x(n) > 0 e x(n) pertence à classe C2 .

(b) w(n + 1) = w(n) + η(n)x(n), se wT (n)x(n) ≤ 0 e x(n) pertence à classe C1 .

onde η(n) controla o ajuste aplicado ao vetor de pesos na iteração n.”

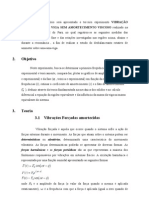

19. A figura 1 abaixo mostra uma rede neural com um único neurônio escondido. Mostre

que essa rede resolve o problema do XOR construindo (a) regiões de decisão e (b) uma

tabela-verdade para a rede.

Figura 1: Rede Neural com único neurônio escondido.

20. Por que o back-propagation é chamada de regra delta generalizada?

21. O que é overfitting?

Página 3 de 4 Continua na próxima página. . .

ICMC-USP

Lista de Exercı́cios - Parte 1

SCC-0570 (continuação)

22. [experimento computacional] Investigue o emprego do aprendizado back-propagation

usando uma não-linearidade sigmoidal para realizar mapeamentos um-a-um, como des-

critos abaixo:

(1) f (x) = x1 1 ≤ x ≤ 100

(2) f (x) = log10 x 1 ≤ x ≤ 10

(3) f (x) = exp(−x) 1 ≤ x ≤ 10

(4) f (x) = sen x 0 ≤ x ≤ π2

Para cada mapeamento, faça o seguinte:

a) Estabeleça dois conjuntos de dados, um para o treinamento da rede e outro para

teste.

b) Use o conjunto de dados de treinamento para computar os pesos sinápticos da rede,

assumindo haver uma única camada escondida.

c) Avalie a acurácia computacional da rede usando os dados de teste.

Use apenas uma camada escondida mas com número variável de neurônios escondidos.

Investigue como a performance da rede é afetada variando-se o tamanho da camada

escondida.

Referências

[1] A. P. Braga, A. P. L. F. Carvalho, T. B. Ludermir, Redes Neurais Artificiais - Teoria e

Aplicações, 2a. edição. LTC, 2007.

[2] S. Haykin, Neural networks - a comprehensive foundation, 2nd. ed. Prentice Hall, 1999.

[3] R. A. F. Romero, “SCC 5809 - Redes Neurais,” Slides, 2o. semestre de 2010.

Página 4 de 4 Final da Lista.

Вам также может понравиться

- Lista de Cálculo NuméricoДокумент4 страницыLista de Cálculo NuméricoAnonymous 1QsclBОценок пока нет

- Lista de Exercícios de AlgoritmosДокумент19 страницLista de Exercícios de AlgoritmosLuiz CarlosОценок пока нет

- Controle de NívelДокумент12 страницControle de NívelLucas Fuzeto VizonìОценок пока нет

- Introdução Classes Métodos PythonДокумент44 страницыIntrodução Classes Métodos Pythonwilson.junior870Оценок пока нет

- Algoritmo 01 - IntroduçãoДокумент42 страницыAlgoritmo 01 - IntroduçãoSilvano OliveiraОценок пока нет

- DOE experimentos otimizar processoДокумент24 страницыDOE experimentos otimizar processoVinicius IankeОценок пока нет

- Apostila - DME ExercíciosДокумент28 страницApostila - DME ExercíciosMarcelo MontibellerОценок пока нет

- Redes Neurais: Aprendizado, Camadas e BackpropagationДокумент25 страницRedes Neurais: Aprendizado, Camadas e BackpropagationsmarrrtОценок пока нет

- Python Tuplas e StringsДокумент22 страницыPython Tuplas e StringsEdson Gaudereto TeixeiraОценок пока нет

- Var Aleatórias: Dist, Prob, Combin Lin & Média AmostralДокумент19 страницVar Aleatórias: Dist, Prob, Combin Lin & Média AmostralJuliana SoaresОценок пока нет

- Termodinâmica Fundamental Aula 8Документ18 страницTermodinâmica Fundamental Aula 8Thales DuarteОценок пока нет

- KNN em classificação de vidrosДокумент6 страницKNN em classificação de vidrosPâmela BeatrizОценок пока нет

- Cálculo do Fator Corretivo para Troca de CalorДокумент3 страницыCálculo do Fator Corretivo para Troca de Calormarlonmrs13Оценок пока нет

- Análise Numérica - Aula 1 - Introdução À Linguagem PythonДокумент17 страницAnálise Numérica - Aula 1 - Introdução À Linguagem PythonJorge EustaquioОценок пока нет

- Aula 79 PDFДокумент10 страницAula 79 PDFezequielОценок пока нет

- Prova Np1 Unip 2013Документ13 страницProva Np1 Unip 2013vidaldanetОценок пока нет

- Aula 51 Algoritmos em PseudocodigoДокумент51 страницаAula 51 Algoritmos em PseudocodigoPatricia JacintoОценок пока нет

- Introdução à sintaxe PORTUGOLДокумент32 страницыIntrodução à sintaxe PORTUGOLxbarretox100% (1)

- 10 - Lista CinemáticaДокумент20 страниц10 - Lista CinemáticaPaulinha TorresОценок пока нет

- Curso Técnico Programação Sistemas InformáticosДокумент70 страницCurso Técnico Programação Sistemas InformáticosTiago SousaОценок пока нет

- Introdução aos algoritmosДокумент55 страницIntrodução aos algoritmosArgemiro AlbuquerqueОценок пока нет

- Ensaios laboratoriais de granulometria e densidade realДокумент8 страницEnsaios laboratoriais de granulometria e densidade realRenato FeitozaОценок пока нет

- Análise comparativa de sistemas de refrigeração e aquecimentoДокумент4 страницыAnálise comparativa de sistemas de refrigeração e aquecimentoGiovana LocksОценок пока нет

- Lógica de ProgramaçãoДокумент32 страницыLógica de ProgramaçãoMarciano Gonçalves100% (1)

- Controle PID para irrigação com ArduinoДокумент23 страницыControle PID para irrigação com ArduinoJhonathanCamposResendeОценок пока нет

- Cálculo Estequiométrico (Com Gabarito - Prof. Rafa - Internet - 2013Документ9 страницCálculo Estequiométrico (Com Gabarito - Prof. Rafa - Internet - 2013Josimar Lima FerreiraОценок пока нет

- Revisão de Cálculo EstequiométricoДокумент6 страницRevisão de Cálculo EstequiométricoTalita MarcíliaОценок пока нет

- Avaliação 360 Graus Modelo RedesДокумент15 страницAvaliação 360 Graus Modelo RedesLilian AlmeidaОценок пока нет

- NR35Документ18 страницNR35Lucas WarleyОценок пока нет

- Aula Parafusos 1Документ33 страницыAula Parafusos 1Silvio FreitasОценок пока нет

- Peças de RevoluçãoДокумент17 страницPeças de Revoluçãoapi-3727963Оценок пока нет

- Algoritmos Genéticos ScilabДокумент12 страницAlgoritmos Genéticos Scilabrodrigues1988Оценок пока нет

- Lista de Aprendizado de QuimicaДокумент8 страницLista de Aprendizado de QuimicamarieОценок пока нет

- ESTEQUIOMETRIA - EXERCÍCIOS RESOLVIDOSДокумент8 страницESTEQUIOMETRIA - EXERCÍCIOS RESOLVIDOSNicolly SantosОценок пока нет

- PID SintoniaДокумент36 страницPID Sintoniar282269zcОценок пока нет

- Lista Eixo ChavetaДокумент4 страницыLista Eixo ChavetaLuis Gustavo ReisОценок пока нет

- Controladores Lógicos ProgramáveisДокумент5 страницControladores Lógicos ProgramáveisIrvson SilveiraОценок пока нет

- Avaliação da leituraДокумент6 страницAvaliação da leituraEdu ThsОценок пока нет

- Lista 3 - Gráficos de Cinemática - EsPCExДокумент12 страницLista 3 - Gráficos de Cinemática - EsPCExRafael PinheiroОценок пока нет

- Exercícios de cálculos estequiométricosДокумент6 страницExercícios de cálculos estequiométricosElson CavalcanteОценок пока нет

- Introdução ao Scilab para cálculo numéricoДокумент24 страницыIntrodução ao Scilab para cálculo numéricoLeonardo AquinoОценок пока нет

- Scilab - Transformada de Fourier e Series Fourier (atéДокумент17 страницScilab - Transformada de Fourier e Series Fourier (atéJonh PauloОценок пока нет

- Questões de Cinemática - (CURSINHO PRÉ-EnEM) - Professor HenriqueДокумент6 страницQuestões de Cinemática - (CURSINHO PRÉ-EnEM) - Professor HenriqueThaina RiosОценок пока нет

- Compensador de Atraso e Avanço de FaseДокумент11 страницCompensador de Atraso e Avanço de FaseAlisson MartinsОценок пока нет

- Módulo 01 Cinematica Dos Solidos UnipДокумент6 страницMódulo 01 Cinematica Dos Solidos UnipadsfasfadsfОценок пока нет

- Exercícios (2023 Cinem I Est.)Документ12 страницExercícios (2023 Cinem I Est.)Beya Miguel Beya MiguelОценок пока нет

- Construção de Algoritmos - Introdução aos conceitos básicosДокумент15 страницConstrução de Algoritmos - Introdução aos conceitos básicosBruno Santana da SilvaОценок пока нет

- 37770-Aula 2 - Controladores Lógicos Programáveis - CLPДокумент92 страницы37770-Aula 2 - Controladores Lógicos Programáveis - CLPLucas BauerОценок пока нет

- Livro Logica de ProgramacaoДокумент35 страницLivro Logica de ProgramacaoGabriel BatistaОценок пока нет

- Relatorio Isolamento Termico PUC MGДокумент24 страницыRelatorio Isolamento Termico PUC MGuber babacaОценок пока нет

- Exercícios FísicaДокумент6 страницExercícios FísicaLucas PereiraОценок пока нет

- Teste de HipotesesДокумент10 страницTeste de Hipotesesrolando pedroОценок пока нет

- VIBRAÇÕESДокумент9 страницVIBRAÇÕEStoshugoОценок пока нет

- Redes neurais artificiais exercíciosДокумент6 страницRedes neurais artificiais exercíciosBruno GomesОценок пока нет

- redesneurais_MathematicaДокумент22 страницыredesneurais_MathematicaRonaldo Ramos da SilvaОценок пока нет

- Familiarização com a convolução digital no MATLABДокумент4 страницыFamiliarização com a convolução digital no MATLABMaycon PereiraОценок пока нет

- Exercicios 1Документ8 страницExercicios 1Yves GarnardОценок пока нет

- Lista Sinais DiscretosДокумент3 страницыLista Sinais DiscretosBeatriz SouzaОценок пока нет

- Resolucao P2Документ7 страницResolucao P2LukenОценок пока нет

- CMMI vs MPS.BR: Um estudo comparativoДокумент16 страницCMMI vs MPS.BR: Um estudo comparativoLucas DibexОценок пока нет

- Tensorflow Na Pratica ConvnetДокумент25 страницTensorflow Na Pratica ConvnetRoger de TarsoОценок пока нет

- Aula12-Ajax e JasonДокумент8 страницAula12-Ajax e JasonRomeu BerthoОценок пока нет

- 2013 - 06 - Caminhos MínimosДокумент13 страниц2013 - 06 - Caminhos MínimosRomeu BerthoОценок пока нет

- 2013 - 03 - TravessiasДокумент51 страница2013 - 03 - TravessiasRomeu BerthoОценок пока нет

- Apostila Prolog PDFДокумент59 страницApostila Prolog PDFRomeu BerthoОценок пока нет

- Notas Minquad IcmcДокумент24 страницыNotas Minquad IcmcRomeu BerthoОценок пока нет

- Aula08 HCI Scc560 RevisaoДокумент46 страницAula08 HCI Scc560 RevisaoRomeu BerthoОценок пока нет

- Redes Complexas PDFДокумент73 страницыRedes Complexas PDFRomeu BerthoОценок пока нет

- Aula8 RelacionalДокумент48 страницAula8 RelacionalRomeu BerthoОценок пока нет

- SCC0200 - Aula 6 PDFДокумент1 страницаSCC0200 - Aula 6 PDFRomeu BerthoОценок пока нет

- 04+-+Ordenação+Topológica+e+Componentes+Fortemente+Conectados+ Salvo+automaticamenteДокумент32 страницы04+-+Ordenação+Topológica+e+Componentes+Fortemente+Conectados+ Salvo+automaticamenteRomeu BerthoОценок пока нет

- Registradores v2Документ11 страницRegistradores v2Romeu BerthoОценок пока нет

- Discreta I AnotaçõesДокумент54 страницыDiscreta I AnotaçõesRomeu BerthoОценок пока нет

- Lab04 MSTДокумент43 страницыLab04 MSTRomeu BerthoОценок пока нет

- Calculo 2 CurvasДокумент19 страницCalculo 2 CurvasRomeu BerthoОценок пока нет

- PG - TeoriaДокумент33 страницыPG - TeoriaTelma Castro SilvaОценок пока нет

- Lista de Exercícios 1 A 2019Документ8 страницLista de Exercícios 1 A 2019DiogoArgentinaОценок пока нет

- Matemática A: Preparar os Testes do 10o. AnoДокумент34 страницыMatemática A: Preparar os Testes do 10o. AnoCarla Castro100% (3)

- Semana 2 Matemática UnivespДокумент3 страницыSemana 2 Matemática Univespmeiri.umc8568Оценок пока нет

- Projeto Educativo 2021/2022 5o AnoДокумент9 страницProjeto Educativo 2021/2022 5o AnoGislaine MirandaОценок пока нет

- Avaliação da confiabilidade humana em tarefas de inspeçãoДокумент17 страницAvaliação da confiabilidade humana em tarefas de inspeçãoAdelmo FilhoОценок пока нет

- Produto MistoДокумент8 страницProduto Mistofellipecesar2012100% (1)

- Matemática 7o ano: Números racionais e equações de 1o grauДокумент3 страницыMatemática 7o ano: Números racionais e equações de 1o grauSamara Cristina O. LimaОценок пока нет

- Aula 1 - Progressão Aritmética IДокумент6 страницAula 1 - Progressão Aritmética IPaulo BatistaОценок пока нет

- DownloadДокумент13 страницDownloadJoão PortelaОценок пока нет

- Encontre os números cruzadosДокумент1 страницаEncontre os números cruzadosexp-matОценок пока нет

- Resumos Gráficos - Matemática PDFДокумент50 страницResumos Gráficos - Matemática PDFkook colorsОценок пока нет

- Teoria de Correlação e Regressão - JELANE AFONSOДокумент5 страницTeoria de Correlação e Regressão - JELANE AFONSOCarlos Paulo Sassiqu AndrassoneОценок пока нет

- Avaliação bimestral de matemática para 8o ano com 10 questões e gabaritoДокумент1 страницаAvaliação bimestral de matemática para 8o ano com 10 questões e gabaritoRegis Silva SilvaОценок пока нет

- 03 - Deflexao em VigasДокумент28 страниц03 - Deflexao em VigasMatheus DuarteОценок пока нет

- Algebra e equaçõesДокумент64 страницыAlgebra e equaçõesJohn AmoedoОценок пока нет

- Expressões NuméricasДокумент2 страницыExpressões Numéricasandersonmendellev100% (1)

- Uma introdução concisa à geometria descritivaДокумент51 страницаUma introdução concisa à geometria descritivaXristiane Oliveira50% (2)

- Relatorio Destilaçao FinalДокумент17 страницRelatorio Destilaçao FinalAlexander Muñoz MuñozОценок пока нет

- Testes de Convergencia PDFДокумент30 страницTestes de Convergencia PDFpkmonteiroОценок пока нет

- Matemática A – Limites, Continuidade, Teorema de Bolzano-Cauchy, AssintotasДокумент8 страницMatemática A – Limites, Continuidade, Teorema de Bolzano-Cauchy, AssintotasAna PinheiroОценок пока нет

- 1° FORMULÁRIO AVALIATIVO DO 6° ANO - 4° BIMESTRE - Formulários GoogleДокумент78 страниц1° FORMULÁRIO AVALIATIVO DO 6° ANO - 4° BIMESTRE - Formulários GoogleThiago MartinsОценок пока нет

- Funções quadráticas e suas aplicaçõesДокумент64 страницыFunções quadráticas e suas aplicaçõesWellingtonОценок пока нет

- Declive e inclinação de uma retaДокумент109 страницDeclive e inclinação de uma retasonia silvaОценок пока нет

- Campo Elétrico PDFДокумент7 страницCampo Elétrico PDFmbenencaseОценок пока нет

- Equações Complexas e Unidade ImagináriaДокумент6 страницEquações Complexas e Unidade ImagináriaCaio FreitasОценок пока нет

- Teste Matemática Funções MóduloДокумент2 страницыTeste Matemática Funções MóduloAnonymous 9FiCpUkTCОценок пока нет

- Teorema Fundamental Da AritméticaДокумент31 страницаTeorema Fundamental Da AritméticaPaulo AndréОценок пока нет

- Espm5 Jan2023 TesteДокумент3 страницыEspm5 Jan2023 TesteFatima SilvaОценок пока нет

- QuádricasДокумент2 страницыQuádricasAna MartinezОценок пока нет