Академический Документы

Профессиональный Документы

Культура Документы

ML en Es

Загружено:

Andy GonzálezИсходное описание:

Оригинальное название

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

ML en Es

Загружено:

Andy GonzálezАвторское право:

Доступные форматы

aprendizaje automático interpretable: de fi niciones,

métodos y aplicaciones

W. James Murdoch a, 1, Chandan Singh b, 1, Karl Kumbier a, 2, Reza Abbasi-Asl b, c, 2, y Bin Yu a, b

una UC Berkeley Departamento de Estadísticas .; si UC Berkeley Ingeniería Eléctrica e Informática Departamento .; C Instituto Allen para la Ciencia del Cerebro

modelos de aprendizaje automático han demostrado gran éxito en el aprendizaje de patrones complejos que les permiten hacer

predicciones acerca de los datos observados. Además de utilizar los modelos para la predicción, la capacidad de interpretar lo que ha

aprendido un modelo está recibiendo una cantidad cada vez mayor de la atención. Sin embargo, este mayor enfoque ha dado lugar a una

gran confusión acerca de la noción de interpretabilidad. En particular, no está claro cómo la amplia gama de métodos de interpretación

propuestos están relacionados, y qué conceptos comunes se puede utilizar para evaluarlos.

Nuestro objetivo es hacer frente a estas preocupaciones por de fi nir interpretabilidad en el contexto de aprendizaje de la máquina e

introducir el marco predictivo descriptiva, Relevantes (PDR) para la discusión de las interpretaciones. El marco PDR proporciona tres

desiderata general para la evaluación: la exactitud de predicción, la precisión descriptiva y relevancia, con relevancia juzgado con

relación a una audiencia humano. Además, para ayudar a manejar la avalancha de los métodos de interpretación, introducimos una

categorización de las técnicas existentes en categorías basadas en modelo y post-hoc, con sub-grupos, incluyendo sparsity, modularidad

arXiv: 1901.04592v1 [stat.ML] 14 Ene 2019

y simulatability. Para demostrar cómo los profesionales pueden usar el marco PDR para evaluar y comprender las interpretaciones,

proporcionamos numerosos ejemplos del mundo real. Estos ejemplos ponen de relieve el papel a menudo poco apreciada por el público

desempeñado humanos en las discusiones de la interpretabilidad. Por último, sobre la base de nuestro marco, se discuten las

limitaciones de los métodos existentes y orientaciones para el trabajo futuro. Esperamos que este trabajo proporcionará un vocabulario

común que hará que sea más fácil para los profesionales e investigadores para discutir y elegir entre una amplia gama de métodos de

interpretación.

1. Introducción exactitud, y la relevancia, donde relevancia es juzgado por un público humano. El uso de

estos términos, categorizamos una amplia gama de métodos existentes, todo fundamentado

METRO

atención por su capacidad de predecir con precisión una amplia variedad de

achine aprendizaje (ML) recientemente ha recibido una considerable

en ejemplos del mundo real † . Al hacerlo, proporcionamos un vocabulario común para los

investigadores y profesionales a utilizar en la evaluación y selección de los métodos de

fenómenos complejos. Sin embargo, hay una creciente conciencia de que, además de

interpretación. A continuación, muestran cómo nuestro trabajo permite una discusión más

las predicciones, modelos ML son capaces de producir conocimiento acerca de las

clara de los problemas abiertos para la investigación futura.

relaciones de dominio contenidos en los datos, a menudo referido como

interpretaciones. Estas interpretaciones han encontrado usos tanto en su propio

derecho, por ejemplo, la medicina ( 1 ), La política de decisiones ( 2 ), y la ciencia ( 3 , 4 ), A. De fi nición de aprendizaje automático interpretables. Por su parte, pretability inter es

Así como en la auditoría de las mismas predicciones en respuesta a cuestiones tales un mal de fi concepto amplio, Ned. Tomado en toda su generalidad, para interpretar los

como la presión de regulación ( 5 ) Y equidad ( 6 ). En ausencia de una bien formada datos medios para extraer información (de alguna forma) de la misma. El conjunto de

definición de interpretabilidad, una amplia gama de métodos con una métodos que caen bajo este paraguas se extiende por todo, desde el diseño de un

correspondientemente amplia gama de salidas (por ejemplo, visualizaciones, en experimento inicial para la visualización de resultados final. En esta forma demasiado

lenguaje natural, ecuaciones matemáticas) han sido etiquetado como interpretación. general, pretability inter no es sustancialmente di ff Erent de los conceptos establecidos de

Esto ha dado lugar a una gran confusión acerca de la noción de interpretabilidad. En la ciencia de datos y estadística aplicada.

particular, no está claro lo que significa interpretar cosa algu-, lo que existen puntos en

común entre los métodos dispares, y cómo seleccionar un método de interpretación En lugar de interpretabilidad en general, nos centramos en el uso de interpretaciones en

para un problema particular / audiencia. el contexto de ML como parte del ciclo de vida de la ciencia Data- más grande. Definimos el

aprendizaje de máquina puede interpretar como el uso de modelos de aprendizaje automático

para la extracción de

pertinente el conocimiento acerca de las relaciones de dominio contenidos en los datos.

En este trabajo, se intenta abordar estas preocupaciones. Para hacerlo, primero Aquí, vemos el conocimiento como pertinente si se ofrece

definen interpretabilidad en el contexto de aprendizaje automático y colocarlo dentro de

† Los ejemplos fueron seleccionados a través de una búsqueda no exhaustiva de los trabajos relacionados.

un ciclo de vida de la ciencia de datos genéricos. Esto nos permite distinguir entre dos

clases principales de métodos de interpretación: basado en el modelo * y post hoc. a

continuación, se introduce el marco predictivo descriptiva, Relevantes (PDR), que WM, CS, KK, RA, y BY ayudaron a identificar los conceptos importantes y expresaron una opinión sobre el papel. WM y CS escribió el

documento con las aportaciones de KK, RA, y por los autores declaran que no existe conflicto de intereses. 1W.M. y CS contribuido

consta de tres desiderata para la evaluación y la construcción de interpretaciones: la

igualmente a esta labor.

exactitud de predicción, descriptivo

2K.K. y RA contribuido igualmente a esta labor.

* Para mayor claridad, a lo largo del trabajo se utiliza el término para referirse a ambos modelos y algoritmos de aprendizaje automático.

3 Para quien debe dirigirse la correspondencia: binyu@berkeley.edu

preimpresión | Murdoch et al. 2018 | 1- 11

una visión para una audiencia en particular en un problema de dominio elegido. Estas ideas en la evaluación de los métodos de interpretación y es un requisito previo para

son a menudo utilizados para guiar la comunicación, acciones, y el descubrimiento. interpretaciones dignas de confianza. Es decir, no se debe interpretar partes de un

métodos de interpretación utilizan modelos de LD, pro- duce conocimiento relevante acerca modelo que no son estables a bations pertur- apropiadas al modelo y los datos. Esto

de las relaciones de dominio contenidos en los datos. Este conocimiento puede ser se demuestra a través de ejemplos en el texto ( 20 , 23 , 24 ).

producido en formatos tales como visualizaciones, lenguaje natural o ecuaciones

matemáticas, dependiendo del contexto y la audiencia. Por ejemplo, un médico que se

debe diagnosticar un solo paciente querrá información Erent di ff cualitativa que un 2. Interpretación de datos en el ciclo de vida de la ciencia

ingeniero de determinar si una imagen fi cador de clasificación es la discriminación por

raza. Antes de discutir los métodos de interpretación, nos colocamos primero el proceso de

interpretables ML dentro del ciclo de vida en la ciencia de datos más amplia. Higo 1 presenta

una descripción deliberadamente general de este proceso, la intención de capturar la mayoría

B. Antecedentes. Interpretabilidad es un rápido crecimiento en el campo de aprendizaje de los problemas en la ciencia de datos. Lo que generalmente se conoce como la interpretación

de máquina, y ha habido varios trabajos ejem- Ining diversos aspectos de se produce principalmente en el modelado y fases de análisis post hoc, con el problema, los

interpretaciones (a veces bajo el epígrafe AI explicables). Una línea de trabajo se centra datos y el público que proporciona el contexto necesario para elegir los métodos apropiados.

en proporcionar una visión general de los métodos de interpretación di ff Erent con un

fuerte énfasis en las interpretaciones post hoc de los modelos de aprendizaje profundas ( 7

, 8 ), A veces señalando similitudes entre diversos métodos ( 9 , 10 ). Otros trabajos se han

centrado en el problema más estrecha de cómo se deben evaluar las interpretaciones ( 11 , La exactitud exactitud

12 ) Y qué propiedades deben satisfacer ( 13 ). Estos trabajos previos se tocan en Problema, Datos, y la predictiva descriptiva Análisis

Modelo

subconjuntos di ff Erent de interpretabilidad, pero no abordan el aprendizaje de máquina audiencia post hoc

puede interpretar como un todo, y dar una orientación limitada sobre cómo

interpretabilidad en realidad se puede utilizar en los ciclos de vida en la ciencia de datos.

Nuestro objetivo es hacerlo, proporcionando un marco y un vocabulario para captar al Iterar

máximo el aprendizaje interpretable por la máquina, sus beneficios, y sus aplicaciones a

Figura 1. Descripción general de las diferentes etapas (texto negro) en un ciclo de vida en la ciencia de datos donde

problemas de datos concretos.

interpretabilidad es importante. etapas principales se discuten en la Sección 2 y exactitud (texto azul) se describe en Sec 3 .

Interpretabilidad también juega un papel en otras áreas de investigación. Por ejemplo, Problema, los datos, y la audiencia Al comienzo del ciclo, un practicante en la ciencia de

interpretabilidad es un tema importante cuando se considera el sesgo y la equidad en los datos define un problema de dominio que les gustaría entender el uso de los datos. Este

modelos ML ( 14 , 15 ), Con ejemplos dados a lo largo del papel ( dieciséis ). En psicología, problema puede tomar muchas formas. En un entorno científico, el médico puede estar

las nociones generales de interpretabilidad y explicaciones se han estudiado en un nivel interesado en las relaciones contenidas en los datos, tales como la forma en las células del

más abstracto ( 17 , 18 ), Proporcionando perspectivas conceptuales pertinentes. cerebro en una zona particular del sistema visual se refieren a los estímulos visuales ( 25 ).

Igualmente, se comenta en dos áreas relacionadas que son distintos pero estrechamente En los establecimientos industriales, el problema a menudo se refiere a la predicción de

relacionado con la interpretabilidad: inferencia causal y la estabilidad. rendimiento u otras cualidades de un modelo, como la forma de asignar las puntuaciones

de crédito con alta precisión ( 26 ), O hacerlo de manera justa con respecto al género y la

raza ( dieciséis ). La naturaleza del problema juega un papel en la interpretabilidad, según el

contexto y la audiencia relevante son esenciales para determinar qué métodos a utilizar.

La inferencia causal La inferencia causal ( 19 ) Es un tema de estadísti- cas que está

relacionada, pero distinta, de aprendizaje automático interpretables. métodos de inferencia

causal se centran exclusivamente en la extracción de las relaciones causales de los datos,

es decir, declaraciones que la alteración de una variable provocará un cambio en otra. Por

Después de elegir un problema de dominio, el médico recoge datos para

el contrario, in- terpretable ML, y la mayoría de otras técnicas estadísticas, se utilizan

estudiarlo. Los aspectos del proceso de recolección de datos puede un ff ect la tubería

generalmente para describir las relaciones no causales, o relaciones en estudios de

interpretación. Notablemente, los sesgos en los datos (es decir, los desajustes entre

observación.

los datos recogidos y la población de interés) se manifestarán en el modelo, lo que

restringe la capacidad para realizar interpretaciones sobre el problema de interés.

En algunos casos, los investigadores utilizan tanto interpretable aprendizaje má-

quina y la inferencia causal en un solo análisis ( 20 ). Una forma de que aquí es donde

se utilizan las relaciones no causales ex tracted por interpretables ML sugerir posibles

relaciones causales. Estas relaciones pueden ser analizados adicionalmente usando Modelo Basado en el problema elegido y los datos recogidos, el practicante construye

métodos de inferencia causales, y totalmente validados mediante estudios entonces un modelo predictivo. En esta etapa, los procesos practicante, limpia, y

experimentales. visualiza los datos, extrae características, selecciona un modelo (o varios modelos) y fi

ts ella. Consideraciones terpretability in- menudo entran en juego en este paso

relacionado con la posibilidad de elegir entre más simple, más fácil de interpretar y

Estabilidad Estabilidad, como una generalización de robustez en estadísti- cas, es un

modelos más complejos, modelos negro-box, que puede encajar mejor los datos. la

concepto que se aplica a lo largo de todo el ciclo de vida de la ciencia Data-, incluyendo

capacidad del modelo para encajar los datos se mide a través de la exactitud de

interpretables ML). El principio de estabilidad requiere que cada paso en el ciclo de vida

predicción.

es estable con respecto a las perturbaciones apropiados, tales como pequeños cambios

en el modelo o datos. Recientemente, la estabilidad ha demostrado ser importante en los

problemas estadísticos aplicados, por ejemplo cuando se trata de sacar conclusiones Análisis post hoc Tener fi cio un modelo (o modelos), el titioner prác- continuación,

acerca de un problema científico ( 21 ) Y en los entornos más generales ( 22 ). La analiza en busca de respuestas a la pregunta original. El proceso de analizar el modelo

estabilidad puede ser útil a menudo implica el uso de métodos terpretability in- para extraer diversas formas

(estables) de

preimpresión | Murdoch et al. 2018 | 2

información del modelo. La información extraída puede entonces ser analizada y a través de medidas tales como la exactitud de la prueba de conjunto. En el contexto de la

muestra utilizando métodos de análisis de datos estándar, tales como gráficos de interpretación, se describe este error como la exactitud de predicción.

dispersión y los histogramas. La capacidad de las interpretaciones para describir Cabe destacar que en los problemas relacionados con la interpretabilidad, a

adecuadamente lo que el modelo ha aprendido se denota por la precisión descriptiva. menudo se requiere una noción de la exactitud de predicción que va más allá de la

precisión en la media. La distribución de asuntos predicciones. Por ejemplo, podría ser

problemático si el error de predicción es mucho mayor para una clase particular.

Iterar Si su fi cientes respuestas son descubiertos después de la etapa de

Además, la exactitud de predicción debe ser estable con respecto a las perturbaciones

análisis post hoc, los acabados practicante fi. De lo contrario, UP- fecha algo en la

de datos y modelo razonable. Por ejemplo, no se debe confiar en la interpretación de un

cadena (problema, datos, y / o modelo) e iterar, potencialmente múltiples veces ( 27 ).

modelo que cambia drásticamente cuando entrenados en un subconjunto ligeramente

Tenga en cuenta que puedan terminar el bucle en cualquier etapa, en función del

más pequeño de los datos.

contexto del problema.

A.2. exactitud descriptiva. La segunda fuente de error se produce Duran- la etapa de análisis

métodos de interpretación A. en el marco PDR. En el marco descrito anteriormente, post hoc, cuando se utilizan métodos de interpretación para analizar un modelo de fi TTED. A

la mayoría de los métodos de interpretación caen o bien en el modelado o etapas de menudo, los métodos de interpretación proporcionan una representación imperfecta de las

análisis post hoc. Llamamos a pretability inter en la etapa de modelado interpretabilidad naves PARENTESCO aprendidas por un modelo. Esto es especialmente difícil para los

basado en modelos modelos de recuadro negro complejas tales como las redes neuronales profundos, que

(Segundo 4 ). Esta parte de la interpretabilidad se centra en constrain- ing forma de almacenan las relaciones no lineales entre las variables en formas no evidentes.

modelos ML para que fácilmente proporcionan información útil acerca de las relaciones

descubiertas. Como resultado de estas limitaciones, el espacio de los posibles modelos

es menor, lo que puede dar lugar a la exactitud de predicción inferior. En consecuencia, . De fi nición Definimos la precisión descriptiva, en el con- texto de interpretación,

la interpretabilidad basado en modelos se utiliza mejor cuando la relación subyacente es ya que el grado en que un método de interpretación captura objetivamente las

relativamente simple. relaciones aprendidas por los modelos de aprendizaje má- quina.

Llamamos a la interpretabilidad en la etapa de análisis post hoc publicar

A.3. Un común con fl icto: predictivo vs exactitud descriptiva. En lecting SE- cuál es el modelo a

interpretabilidad hoc ( Segundo 5 ). Estos métodos de interpretación toman un modelo

utilizar, los profesionales se enfrentan a menudo con un comercio o FF entre la exactitud

entrenado como entrada, y extraer información acerca de lo que el modelo de relaciones

predictiva y descriptiva. Por un lado, la simplicidad de los métodos de interpretación basado

ha aprendido. Ellos son más útiles cuando la relación subyacente es especialmente

en modelo produce consistentemente alta precisión descriptiva, pero a veces puede resultar

compleja, y los profesionales necesitan para entrenar un modelo intrincado de recuadro

en una menor exactitud de predicción sobre conjuntos de datos complejos. Por otro lado, en

negro con el fin de lograr una exactitud de predicción razonable.

la configuración de complejos, tales como análisis de imágenes, modelos complicados

generalmente proporcionan una alta precisión de predicción, pero son más difíciles de

Después de discutir los desiderata de los métodos de interpretación, investigamos

analizar, lo que resulta en una menor precisión descriptiva.

estas dos formas de interpretaciones en detalle y discutir los métodos asociados.

3. Los objetivos propuestos para el PDR interpretaciones B. Relevancia. Al seleccionar un método de interpretación, no es suficiente para que el

método tiene una alta precisión - la información tracted ex también debe ser relevante.

En general, no está claro cómo seleccionar y evaluar los métodos de inter- pretación

Por ejemplo, en el contexto de la genómica, un paciente, médico, biólogo y cian

de un problema y público en particular. Para ayudar a guiar este proceso, se introduce

estadísticamente puede querer cada ff on diferente (pero consistente) interpretaciones

el marco PDR, que consta de tres desiderata que se deben utilizar para seleccionar los

de un mismo modelo. El contexto proporcionado por las etapas de problemas y datos

métodos de interpretación para un problema particular: la exactitud de predicción,

de la figura 1 guía a qué tipo de relaciones es un profesional interesado en conocer, y

precisión descriptiva y de relevancia.

por extensión los métodos que se deben utilizar.

A. Precisión. La información producida por un método de interpretación debe ser fiel al

proceso subyacente de la Tioner prác- está tratando de entender. En el contexto de . De fi nición Definimos una interpretación que debe pertinente

ML, hay dos áreas en las que pueden surgir errores: al aproximar las relaciones de los si se da una idea para una audiencia en particular en un problema de dominio elegido.

datos subyacentes a un modelo (exactitud predictiva) y cuando se aproxima a lo que el

modelo ha aprendido el uso de un método de interpretación (precisión descriptiva). Relevancia a menudo desempeña un papel clave en la determinación de la el comercio o

Para una inter- pretación que sea digno de confianza, uno debe tratar de maximizar FF entre la exactitud predictiva y descriptiva. Dependiendo del contexto del problema que nos

tanto de las precisiones. En los casos en que la precisión no es muy alta, las ocupa, un médico puede optar por centrarse en uno sobre el otro. Por ejemplo, cuando

interpretaciones resultantes pueden todavía ser útiles. Sin embargo, es especialmente interpretabilidad se utiliza para auditar las predicciones de un modelo, como para hacer cumplir

importante para comprobar su confiabilidad a través de validación externa, tal como la la imparcialidad, la exactitud descriptiva puede ser más importante. En contraste, la

ejecución de un experimento adicional. interpretabilidad también se puede usar exclusivamente como una herramienta para aumentar

la exactitud de predicción de un modelo, por ejemplo, mediante la mejora de la ingeniería

característica.

A.1. La exactitud predictiva. La fuente primera de error se produce durante la etapa de Habiendo descrito los desiderata principal de los métodos de interpretación, que

modelo, cuando se construye un modelo ML. Si el modelo aprende una pobre ahora discutimos cómo se vinculan con la interpretación en el modelado y post hoc

aproximación de las naves PARENTESCO subyacentes en los datos, toda la información etapas de análisis del ciclo de vida en la ciencia de datos. Higo 2 traza paralelos entre

extraída del modelo es poco probable que sea preciso. La evaluación de la calidad de un nuestra desiderata de técnicas de interpretación introducidas en la Sec 3 y nuestra

modelo de fi cio ha sido bien estudiado en los marcos ML supervisadas estándar, rización cate- de métodos en Sec 4 y Sec 5 . En particular, tanto

preimpresión | Murdoch et al. 2018 | 3

esos parámetros como se semanticamente a la OUT- entran en cuestión, y también se

pueden interpretar la magnitud y dirección de los parámetros. Sin embargo, antes de

poder interpretar un conjunto de parámetros escasa, se debe comprobar la estabilidad

interpretabilidad interpretabilidad

de los paráme- tros. Por ejemplo, si el conjunto de parámetros dispersos cambia

basado en modelos post hoc

debido a las pequeñas perturbaciones en el conjunto de datos, los coe fi cientes no

En general sin deben interpretarse ( 30 ).

cambios o

La exactitud

predictiva

disminución Sin efecto

Cuando el practicante es capaz de incorporar correctamente sidad de forma

(dependiente de los datos)

moderada, en su modelo, puede mejorar todos los desiderata de tres interpretación. Al

reducir el número de parámetros a analizar, modelos escasas pueden ser más fáciles de

entender, dando mayor precisión descriptiva. Por otra parte, la incorporación de informa-

ción previa en forma sparsity en un problema escasa puede ayudar a un modelo de lograr

descriptiva

La exactitud

Incrementar Incrementar

una mayor exactitud de predicción y rendir penetraciones Vant más vantes. Tenga en

cuenta que la incorporación de escasez a menudo puede ser bastante dif'ıcil, ya que

requiere la comprensión de la estructura de datos fi ca-ca de la escasez y la forma en que

se puede modelar.

Figura 2. Impacto de los métodos de interpretabilidad precisiones descriptivos y predictivos. basado en un modelo

interpretabilidad (Sec 4 ) Implica el uso de un modelo más simple para encajar los datos que pueden afectar negativamente a la

Los métodos para obtener sparsity a menudo utilizan una penalización en una función de

exactitud de predicción, pero los rendimientos mayor precisión descriptiva. Mensaje interpretabilidad hoc (Sec 5 ) Implica el uso de pérdida, como LASSO ( 31 ) Y escaso codificación ( 32 ), o en una selección modelo de criterios

métodos para extraer información de un modelo entrenado (sin efecto sobre la exactitud de predicción). Estos corresponden a las tales como AIC o BIC ( 33 , 34 ). Muchos métodos basados en la búsqueda han sido

etapas hoc modelo y de correos en la figura 1 .

desarrollados para encontrar soluciones dispersas. Buscar estos métodos a través del espacio

de coeficientes no cero coe fi utilizando métodos de selección de subconjunto clásicos (por

ejemplo matching pursuit ortogonal ( 35 )). escasez modelo es a menudo útil para problemas de

post hoc y los métodos basados en modelos tienen como objetivo aumentar la precisión alta dimensión, donde el objetivo es identificar las características clave para su posterior

descriptiva, pero sólo basado en modelos a ff refleja la exactitud de predicción. No se análisis. Como resultado, las sanciones ralitud se han incorporado en los modelos complejos,

muestra es de relevancia, que determina qué tipo de salida es útil para un problema y público como los bosques aleatorios para identificar un subconjunto de características importantes

en particular. escasa ( 36 ).

4. interpretabilidad basado en modelos

En el siguiente ejemplo de la genómica, sparsity se utiliza para aumentar la

Ahora se discute cómo vienen consideraciones interpretabilidad en juego en la etapa de relevancia de las interpretaciones producidas mediante la reducción de la cantidad de

modelado del ciclo de vida de la ciencia de datos (véase la figura 1 ). En esta etapa, el interacciones potenciales a un nivel manejable.

practicante construye un modelo ML partir de los datos recogidos. Definimos interpretabilidad

basado en modelos como la construcción de modelos que proporcionan fácilmente una idea . Ex. La identificación de las interacciones entre los factores reguladores o

de las relaciones que han aprendido. Di ff métodos interpretabilidad basadas en modelos biomoléculas es una cuestión importante en la genómica. Typ- conjuntos de datos

Erent proporcionan formas di ff Erent de aumentar la precisión descriptiva mediante la genómicos icos incluyen miles o incluso millones de características, muchas de las cuales

construcción de modelos que son más fáciles de entender, a veces resulta en la exactitud de están activos en especí fi cos celulares o desa- contextos opmental. La escala masiva de

predicción inferior. El principal reto de la interpretabilidad basado en modelos es para llegar a este tipo de datos hacen que la interpretación de un reto considerable. sanciones Sparsity se

modelos que son lo suficientemente simple para ser entendido fácilmente por el público, pero utilizan con frecuencia para que los datos sean manejables para montadores

lo suficientemente sofisticados como para encajar adecuadamente t los datos subyacentes. estadísticamente biólogos y sus colaboradores para discutir e identificar candidatos

prometedores para experimentos adicionales.

Por ejemplo, un estudio reciente ( 23 ) Utiliza un AP- biclustering

En la selección de un modelo para resolver un problema de dominio, el Tioner prác- proach basado en escasa análisis de correlación canónica (SCCA) para identificar

debe tener en cuenta la totalidad del marco PDR. El primer desiderátum fi a considerar es interacciones entre expresión genómica cuenta en

la exactitud de predicción. Si el modelo con- structed no representa con precisión el Drosophila melanogaster ( moscas de la fruta) y Gans Caenorhabditis ele- ( gusanos

problema de fondo, cualquier análisis posterior será sospechoso ( 28 , 29 ). Segundo, el redondos). sanciones Sparsity permiten interacciones clave entre características que se

propósito principal de los métodos de interpretación basado en modelo es para aumentar resumen en mapas de calor que contienen pocas variables suficientes para un ser

la precisión descriptiva. Por último, la relevancia de la producción de un modelo debe ser humano para analizar. Por otra parte, este estudio realiza el análisis de estabilidad en su

considerado, y está determinada por el contexto del problema, los datos, y la audiencia. modelo, hallazgo que sea robusto para inicializaciones Erent di FF y perturbaciones a

Ahora tenemos dis- CuSS algunos tipos ampliamente útiles de los métodos basados en hiperparámetros.

modelos interpretabilidad.

B. Simulatability. Un modelo se dice que es simulatable si un humano (al que se

destina la interpretación) es capaz de simular internamente y razonar sobre la totalidad

A. Sparsity. Cuando el practicante cree que la relación subyacente en cuestión se de su proceso de toma de decisiones (es decir, cómo un modelo entrenado produce

basa en un conjunto disperso de las señales, que pueden imponer escasez en su una salida para una entrada arbitraria). Esta es una restricción muy fuerte para colocar

modelo, al limitar el número de parámetros que no son cero. En esta sección, nos en un modelo, y en general, sólo puede hacerse cuando el número de características

centramos en los modelos lineales, pero escasez puede ser útil en términos más es baja, y la relación subyacente es simple. Árboles de decisión ( 37 ) Se citan a

generales. Cuando el número de parámetros distintos de cero es su fi cientemente menudo como modelo simulatable, debido a su proceso de toma de decisiones

pequeño, un médico puede interpretar las variables correspondientes a jerárquica. Otro ejemplo es listas de

preimpresión | Murdoch et al. 2018 | 4

reglas ( 38 , 39 ), Que puede ser fácilmente simulado. Debido a su simplicidad, los modelos pacientes, con 46 funciones que incluyen desde la demografía (por ejemplo, edad y sexo),

simulatable tienen muy alta precisión descriptiva. Cuando también pueden proporcionar medidas físicas (por ejemplo, ritmo cardíaco, presión arterial) simple y pruebas de

una precisión de predicción razonable, que puede ser muy e caz y ss. En el siguiente laboratorio (por ejemplo, recuento de glóbulos blancos, de nitrógeno ureico en sangre). Para

ejemplo, un modelo simulatable novela es capaz de producir una alta precisión de predecir el riesgo de mortalidad, que utilizan un modelo aditivo generalizado con las

predicción, mientras se mantienen los altos niveles de precisión descriptiva y relevancia interacciones de pares, se muestran a continuación. Los términos uni y por parejas ( F j ( X j)

normalmente alcanzados por los modelos basados en reglas.

y F ij ( X yo, X j)) puede interpretarse de forma individual en forma de curvas y mapas de

. Ex. En la práctica médica, cuando un paciente ha sido diagnosticado con calor, respectivamente.

fibrilación auricular, los cuidadores a menudo quieren predecir el riesgo de que el

paciente en particular tendrá un derrame cerebral en el próximo año. Por otra parte, sol( MI[ y]) = β 0 + Σ F j ( X j) + Σ F ij ( X yo, X j) [1]

teniendo en cuenta las posibles ramificaciones de las decisiones ical MED, es importante j yo 6 = j

que estas predicciones no sólo son exactos, pero interpretable tanto a los cuidadores y

pacientes. Mediante la inspección de los módulos individuales, los investigadores encontraron

una serie de propiedades contrarias a la intuición de su modelo. Por ejemplo, el

Para hacer la predicción, ( 39 ) Utiliza datos de 12.586 pacientes modelo fi tted aprendió que tener asma es ciados ciación con un menor riesgo de morir

detallando su edad, género, historia de las drogas y las condiciones anteriores a su por neumonía. En realidad, lo contrario es cierto - los pacientes con asma se sabe que

diagnóstico, y si tenían un accidente cerebrovascular dentro de un año de diagnóstico. tienen un mayor riesgo de muerte por neumonía. Debido a esto, los datos recogidos en

Con el fin de construir un modelo que tiene una alta predictivo y precisión descriptiva, ( 39 ) todos los pacientes con asma recibieron atención agresiva, que era por suerte e ff caz

Introducir un método para listas de reglas si-entonces que son predictivos de riesgo de a reducir su riesgo de mortalidad en relación con la población general.

accidente cerebrovascular un solo año aprendiendo. El er clasi fi resultante, que se

muestra en la figura 3 , Requiere sólo siete if-then para lograr la precisión competitivo, y es

fácil, incluso para los profesionales no técnicos a entender rápidamente. En este caso, si se utilizara el modelo sin haber sido interpretado, los pacientes

con asma neumonía habrían han sido des-priorizado para la hospitalización. En

consecuencia, el uso de ML aumentaría la probabilidad de morir. Afortunadamente, el

uso de un modelo interpretable permitió a los investigadores para identificar y corregir

errores como éste, garantizar mejor que el modelo podría ser de confianza en el

Si hemiplejía y edad> 60 entonces el riesgo de apoplejía 58,9% (53,8% -63,8%)

else if trastornos cerebrovasculares entonces el riesgo de apoplejía 47,8% (44,8% -50,7%)

mundo real.

else if ataque isquémico transitorio entonces el riesgo de apoplejía 23,8% (19,5% -28,4%)

else if oclusión y estenosis de la arteria carótida sin infarto entonces el riesgo de apoplejía 15,8% (12,2%

-19,6%) D. Dominio-basado ingeniería característica. Mientras que el tipo de modelo es

else if estado alterado de conciencia y edad> 60 entonces el riesgo de apoplejía 16,0% (12,2% -20,2%)

importante en la producción de una interpretación útil, por lo que son las características

que se utilizan como entradas para el modelo. Tener características más informativos hace

else if años ≤ 70 entonces el riesgo de apoplejía 4,6% (3,9% -5,4%)

más el riesgo de apoplejía 8,7% (7,9% -9,6%) que la relación que debe ser aprendido por el modelo más sencillo, que permite una para

utilizar otros métodos basados en modelos interpretabilidad. Por otra parte, cuando las

Fig. 3. lista de reglas para la clasificación de riesgo de accidente cerebrovascular a partir de los datos del paciente (replicados Fig 5 a partir características tienen más sentido a un público en particular, se vuelven más fáciles de

de ( 39 )). Uno puede simular y comprender las relaciones entre las diferentes variables como la edad en la facilidad el riesgo de apoplejía. Reproducido

interpretar.

con permiso de los autores.

En muchos dominios individuales, el conocimiento experto puede ser útil en la

C. modularidad. Definimos un modelo ML para ser modular si una parte significativa (s) de construcción de conjuntos de características que son útiles para la construcción de

su proceso de predicción de decisiones se puede interpretar de forma independiente. modelos predictivos. Los algoritmos particulares usados para extraer características son

Mientras que los modelos modulares no son tan fáciles de entender como modelos generalmente de dominio-específico, basándose tanto en la experiencia de dominio

dispersos o simulatable, que todavía puede ser útil para aumentar la exactitud descriptiva existente del practicante y percepciones extraídas de los datos a través de análisis de

para proporcionar información sobre las relaciones que el modelo ha aprendido. datos exploratorio. Por ejemplo, en el procesamiento del lenguaje natural, los documentos

están incorporados en vectores usando tf-idf ( 45 ) Y en la visión por ordenador

Una amplia gama de modelos de satisfacer modularidad a di ff grees Erent de-. modelos transformaciones ical mathemat- se han desarrollado para producir representaciones útiles

aditivos generalizados ( 40 ) Forzar la relación entre las variables en el modelo para ser de imágenes ( 46 ). En el siguiente ejemplo, el conocimiento acerca de la cobertura principal

aditivos. En el aprendizaje profundo, métodos especí fi cos (como la atención 41 ) Y do- nube es explotada para diseñar tres características simples que aumentan la exactitud

arquitecturas de red modulares ( 42 ) Proporcionar visión limitada de funcionamiento in- ner de predictiva de un modelo mientras se mantiene la alta precisión descriptiva de un modelo

una red. modelos probabilísticos pueden hacer cumplir la modularidad mediante la predictivo simple.

especificación de una estructura de independencia condicional que hace que sea más fácil de

razonar acerca de di ff partes Erent de un modelo independiente ( 43 ).

. Ex. Al modelar los patrones climáticos globales, una cantidad impor- tante es la

cantidad y la ubicación de la cobertura de nubes ártico. Debido a la compleja

En el siguiente ejemplo se utiliza la modularidad para producir interpretaciones relevantes para su uso naturaleza, capas de los modelos climáticos, es beneficioso tener cobertura de nubes,

en el diagnóstico de los sesgos en los datos de entrenamiento. modelos simples, fácilmente auditables para su uso por los científicos del clima

. Ex. Al establecer prioridades para la atención de los pacientes con neumonía en corriente abajo.

un hospital, un método posible es predecir la probabilidad de muerte dentro de los 60 en ( 47 ), Los autores utilizan un conjunto de datos sin etiqueta del ártico

días, y se centran en los pacientes con un mayor riesgo de mortalidad. Teniendo en imágenes de satélite para construir un modelo para predecir si cada píxel de una

cuenta los potenciales de vida o muerte consecuencias, siendo capaz de explicar las imagen contiene nubes o no. Dada la similitud cualitativa entre el hielo y las nubes,

razones de la hospitalización de un paciente o no es muy importante. este es un problema de predicción desafiante. Mediante la realización de exploración

análi- sis de datos y la utilización de los conocimientos de dominio a través de

Un estudio reciente ( 44 ) Utiliza un conjunto de datos de 14.199 neumonía interacciones con

preimpresión | Murdoch et al. 2018 | 5

los científicos del clima, los autores identifican tres características simples que son su Cuando la realización de análisis post hoc, el modelo ya se ha entrenado, por lo

cientes fi a agruparse si las imágenes contienen nubes. El uso de estas tres que su exactitud predictiva es fijo. Por lo tanto, en el marco del PDR, un investigador

características como entrada para análisis criminant dis- cuadrática, logran tanto de alta debe considerar sólo la precisión descriptiva y relevancia (en relación a un público en

precisión de predicción y transparencia cuando se compara con las etiquetas de particular). La mejora en cada uno de estos criterios son áreas de investigación activa.

expertos (que no fueron utilizados en el desarrollo de las características y el método ing

cluster- QDA). Más ampliamente útiles métodos de interpretación post hoc se dividen en dos

categorías principales: a nivel de predicción y las interpretaciones de nivel de conjunto de

datos, que se denominan a veces como interpretaciones locales y globales,

E. Modelo basado en la ingeniería característica. Hay una variedad de métodos respectivamente. métodos de inter- pretación de nivel de predicción se centran en la

automáticos para la construcción de características interpretables. Dos ejemplos son el explicación de las predicciones individuales hechas por modelos, tales como qué

aprendizaje sin supervisión y la reducción de dimensionalidad. métodos no supervisados, características y / o interacciones condujeron a la predicción particular. enfoques a nivel de

tales como la agrupación, factorización trix ma-, y el aprendizaje diccionario, el objetivo de conjunto de datos se centran en las relaciones globales del modelo ha aprendido, como lo

procesar los datos no etiquetados y salida de una descripción de su estructura. Estas patrones visuales se asocian con una respuesta prevista. Estas dos categorías tienen mucho

estructuras se pueden desprender penetración en las relaciones contenidas dentro de los en común (de hecho, los enfoques a nivel de conjunto de datos a menudo proporcionan

datos y pueden ser útiles en la construcción de modelos predictivos. reducción de información a nivel de predicción), pero que discutan por separado, como los métodos a

dimensionalidad se centra en hallazgo una representación de los datos que es nivel Erent di ff ff son significativamente di Erent.

inferior-dimensional de los datos originales. Métodos tales como análisis de componentes

principales ( 48 ), Inde- análisis de componentes colgantes ( 49 ), Y análisis de correlación

canónica ( 50 ) A menudo puede identificar algunas dimensiones interpretables, que luego

pueden ser usados como entrada a un modelo o para proporcionar información en su propio A. Conjunto de datos a nivel de interpretación. Cuando un profesional se Ested inter en las

derecho. El uso de menos insumos no sólo puede mejorar la precisión descriptiva, pero relaciones más generales aprendidas por un modelo, por ejemplo, relaciones que son relevantes

puede aumentar la precisión de la predicción mediante la reducción del número de para una clase particular de respuestas o subpoblación, utilizan interpretaciones a nivel de

parámetros a fi cio. En el siguiente ejemplo, el aprendizaje sin supervisión (matriz de conjunto de datos.

factorización no negativa) se utiliza para representar imágenes en una de bajas dimensiones,

genéticamente significativa, el espacio. A.1. Interacción y características importancias. las puntuaciones de importancia de

características, a nivel de conjunto de datos, tratan de capturar cuánto características

indivi- indi- contribuyen, a través de un conjunto de datos, a una predicción. Estos

resultados pueden ayudar a comprender qué características tiene el modelo de identi fi

. Ex. La heterogeneidad es una consideración importante en problemas genómicas y cado tan importante para los que los resultados, y su importancia relativa. Se han

datos asociados. En muchos casos, los factores miento de reglamentación mentos o desarrollado métodos para anotar características individuales en muchos modelos,

biomoléculas pueden jugar un papel específico en un contexto, como por ejemplo un tipo de incluyendo redes neuronales ( 52 ), Bosques aleatorios, ( 53 , 54 ), Y ERS fi caciones

célula particular o etapa de desarrollo, y tienen un papel muy Erent di ff en otros contextos. genéricos ( 55 ). Además de ofrecer importancias, se han desarrollado métodos para extraer

Por lo tanto, es importante entender el comportamiento “local” de los factores reguladores o importantes interacciones entre características. Las interacciones son importantes como

biomoléculas. modelos ML son a menudo altamente no lineal y aprender complejas interacciones entre

características. Existen métodos para extraer las interacciones de una variedad de modelos

Un estudio reciente ( 51 ), Utiliza aprendizaje no supervisado para aprender ML incluyendo bosques aleatorios ( 20 , 56 ) Y redes neuronales ( 57 , 58 ). En el siguiente

patrones espaciales de la expresión génica en Drosophila ( fruta fl y) embriones. En ejemplo, la precisión descriptiva de bosques aleatorios se incrementa mediante la

particular, utilizan la estabilidad impulsado matriz de factorización no negativa para extracción de las interacciones booleanas (una forma relevante-problema de interpretación)

descomponer las imágenes de los patrones de expresión de genes TiAl SPA-complejos de un modelo entrenado.

en una biblioteca de 21 “patrones principales”, que se puede ver como regiones

pre-órganos Esta composición de-, que es interpretable para los biólogos , permite el

estudio de las interacciones gen-gen en regiones pre-de órganos del embrión en

desarrollo. . Ex. interacciones de orden superior entre los factores reguladores o los genes juegan un

papel importante en Ning-tipo de células c comportamiento específico de fi en los sistemas

biológicos. Como resultado, la extracción de tales interacciones a partir de datos genómica es un

problema importante en la biología.

5. post hoc interpretabilidad

Ahora se discute cómo entran en juego consideraciones interpretabilidad en la etapa de Una línea de trabajo anterior considera el problema de la búsqueda de interacciones

análisis post hoc del ciclo de vida en la ciencia de datos. En esta etapa, el profesional biológicas asociadas a los procesos biológicos importantes ( 20 , 56 ). Para identificar las

analiza un modelo entrenado con el fin de proporcionar conocimientos sobre las interacciones candidatos biológica, los autores entrenan una serie de FR de forma iterativa

relaciones aprendidas. Esto es particularmente difícil cuando los parámetros del re-ponderados y la búsqueda de combinaciones estables de características que con

modelo no muestran claramente lo que el modelo de relaciones ha aprendido. Para frecuencia co-ocurren a lo largo de las rutas de decisión predictivos de RF. Este enfoque da

ayudar en este proceso, una variedad de métodos interpretabilidad post hoc se han un paso más allá de la evaluación de la importancia de las características individuales de una

desarrollado para dar una idea de lo que es un modelo entrenado ha aprendido, sin RF, proporcionando una descripción más completa de cómo las características influyen en las

cambiar el modelo subyacente. Estos métodos son particularmente importantes para respuestas predijo. Al interpretar las interacciones utilizadas en RFs, los investigadores identi

entornos en los que los datos recogidos se de alta dimensional y complejo, tal como fi cadas interacciones de genes génicas con 80% de precisión en la Drosophila de embriones

con datos de imagen. Una vez que la información ha sido extraída del modelo TTED fi, e identificar dianas candidatas para las interacciones de orden superior.

puede ser analizado utilizando técnicas estándar de análisis de datos exploratorios,

A.2. importancias de funciones estadísticas. En algunos casos, en adi- ción al valor crudo,

podemos calcular las medidas estadísticas

preimpresión | Murdoch et al. 2018 | 6

de confianza como las puntuaciones de importancia de característica, una téc- nica . Ex. Un estudio reciente Visualiza la informacin aprendido de redes neuronales

normas enseñadas en las clases de introducción a la estadística. Al hacer suposiciones profundas para comprender las células cerebrales individuales ( 24 ). En este estudio, los

sobre el proceso de generación de datos subyacente, modelos como lineal y regresión monos macacos se muestran las imágenes, mientras que las respuestas de las células

logística pueden calcular estafadores fi- intervalos de confianza y pruebas de hipótesis cerebrales en su sistema visual (área V4) se registraron. Las redes neuronales fueron

para los valores y combinaciones lineales, de sus coe fi cientes. Estas estadísticas pueden entrenadas para predecir las respuestas de las células del cerebro a las imágenes. Estas

ser útiles para determinar el grado en que los coeficientes ffi- coe observado son redes neuronales producen fi cios precisos, pero ofrecen poca información sobre lo que

estadísticamente significativos. Es importante señalar que los supuestos del modelo PAT- charranes en las imágenes de aumentar la respuesta de las células cerebrales sin

probabilístico subyacente deben ser plenamente veri fi antes de usar esta forma de más análisis. Para remediar esto, los autores introducen Deep- Tune, un método que

interpretación. A continuación presentamos un ejemplo de advertencia donde las hipótesis proporciona una visualización, puede acceder a los neurólogos y otros, de los patrones que

Erent di ff llevan a conclusiones opuestas cuando se extrae de la misma base de datos. activan las células del cerebro. La intuición principal detrás del método es optimi- Mize la

entrada de una red para maximizar la respuesta de un modelo de red neuronal (que

representan una célula de cerebro).

. Ex. Aquí, tenemos en cuenta la demanda Estudiantes para el ingreso a la Feria,

Inc. v. Harvard en relación con el uso de la raza en las admisiones a dergraduate

ONU-Universidad de Harvard. Los informes iniciales de o fi cina de la Universidad de Los autores pasan a analizar el importante problema de la estabilidad in-. Cuando

Harvard de Investigación Institucional utilizan regre- sión logística para modelar la post hoc visualizaciones intento de responder a las preguntas científicas, las

probabilidad de admisión usando características di ff Erent de un solicitante de per fi l, visualizaciones deben ser estables a rea- perturbaciones razo- (por ejemplo, la

incluyendo su raza ( 59 ). Este análisis encontrado que el coe fi ciente asociado con ser elección del modelo); si hay cambios en la visualización debido a la elección de un

(ingresos y no bajo) Asiático tenía un coe fi ciente de -0,418 con una fi no puede p-valor modelo, no es probable significativa. Los autores abordan explícitamente por fi tting

signi (<0,001). Este coe fi ciente suge- negativo congestionadas que ser asiático tenía una modelos ff Erent dieciocho di a los datos y el uso de una optimización estable en todos

asociación negativa significativa con la probabilidad de admisión. los modelos para producir una visualización DeepTune final consenso.

El análisis posterior de ambas partes en el pleito AT- tentación de analizar el

modelado y supuestos para decidir sobre la significación de la raza en la decisión del A.4. El análisis de las tendencias y los valores extremos en las predicciones. Cuando Intérpretes

modelo. Los ff plainti 's informe de expertos ( 60 ) Sugirió que la raza estaba siendo en el desempeño de un modelo ML, puede ser útil examinar no sólo en la precisión media,

utilizado injustamente basándose en el informe original de la o fi cina de la Universidad sino también en la distribución de las predicciones y los errores. Por ejemplo, los gráficos de

de Harvard de Investigación Institucional. También incorpora el análisis de los factores residuos pueden identificar heterogeneidad en las predicciones, y sugerir puntos de datos

más subjetivos como “notas personales” que parecen hacer daño a la admisión de particulares a analizar, tales como valores atípicos en las predicciones, o ejemplos que tenían

estudiantes asiáticos. Por el contrario, el informe de los expertos de soporte Universidad las más grandes errores de predicción. Por otra parte, estas parcelas pueden utilizar para

de Harvard ( 61 ) NDS fi que al tener en cuenta ciertas otras variables, el e ff ect de la raza analizar las tendencias en las predicciones. Por ejemplo, en el siguiente ejemplo, influencia

en los estudiantes la aceptación de Asia ya no es significativa. Cances signi fi derivados funciones son capaces de e fi cientemente identificar puntos de datos mal etiquetados.

de las pruebas estadísticas en regresión o modelos de regresión logística en el mejor de

establecer la asociación, pero no causalidad. Por lo tanto los yses anal- de ambos lados

son fl awed. Este ejemplo demuestra las consecuencias prácticas y engañosas de . Ex. Este tipo de análisis también se puede utilizar para identificar datos de

importancias característica estadísticos utilizados de manera inapropiada. entrenamiento mal etiquetados. Un método recientemente introducido ( 69 ) Utiliza el concepto

estadístico clásico de las funciones de influencia para identificar los puntos en los datos de

entrenamiento que contribuyen a las predicciones hechas por los modelos ML. Mediante la

búsqueda de puntos de datos de entrenamiento que contribuyen a la mayor cantidad

predicciones individuales, que fueron capaces de puntos de datos fi nd mal etiquetados y sin

A.3. Visualizaciones. Cuando se trata de conjuntos de datos de alta dimensión, puede ser tener que mirar a demasiados datos. La corrección de estos puntos de entrenamiento mal

difícil de entender rápidamente las complejas relaciones que un modelo ha aprendido, etiquetadas posteriormente mejorado la exactitud de la prueba.

por lo que la presentación de los resultados de especial importancia. Para ayudar a lidiar

con esto, los investigadores han desarrollado una serie de visualizaciones Erent di ff que

ayudan a entender lo que ha aprendido un modelo. Para los modelos lineales con

regularización, parcelas de coe regresión caminos fi ciente muestran cómo variar un B. Interpretación Predicción nivel. enfoques a nivel de predicción son útiles cuando un

parámetro de regularización un ff ECTS las fi TTED coe fi cientes. Al visualizar las redes practicante está interesado en comprender cómo las predicciones individuales se realizan

neuronales convolucionales entrenados en los datos de imagen, se ha trabajado en la mediante un modelo. Tenga en cuenta que los enfoques a nivel de predicción a veces se

visualización de filtros ( 62 , 63 ), Máximo activar respuestas de las neuronas o clases pueden agregar para ayudar a comprender a nivel de conjunto de datos.

individuales ( 64 ), La variación intra-clase entendimiento ( sesenta y cinco ), y las

neuronas agrupación di ff Erent ( 66 ). Durante largos Corto Plazo redes de memoria

(LSTMs), los investigadores se han centrado en el análisis del vector de estado, la B.1. las puntuaciones de importancia de característica. El método más popular para la

identificación de las dimensiones individuales que corresponden a las características interpretación a nivel de predicción ha implicado la asignación de puntajes importancia a

significativas (por ejemplo, posición en la fila, entre comillas) ( 67 ), y la construcción de características individuales. Intuitivamente, una variable con una puntuación grande positivo

herramientas para realizar un seguimiento del proceso de toma el modelo a lo largo de (negativo) hizo una contribución muy positiva (negativa) a una predicción particular. En la

una secuencia ( 68 ). En el siguiente ejemplo, las interpretaciones relevantes se pro- literatura de aprendizaje profundo, se han propuesto una serie de enfoques Erent di ff para

ducido mediante el uso de imágenes máximos de activación para la identificación de hacer frente a este problema ( 70 - 79 ), Con algunos métodos para otros modelos, así ( 80 ). Estos

patrones que conducen a la respuesta de las células cerebrales. a menudo se muestran en forma de un mapa de calor destacando características importantes.

Tenga en cuenta que las puntuaciones de importancia de característica en el nivel de

predicción puede o ff er mucha más información que las puntuaciones de importancia de

característica en el

preimpresión | Murdoch et al. 2018 | 7

de tres secciones principales del papel: desiderata interpretación (Sec 3 ),

Interpretabilidad basado en modelos (Sec 4 ), Y post interpretabilidad hoc (Sec 5 ).

A. Medición de desiderata interpretación. Actualmente, no existe un claro consenso

en la comunidad en torno a la forma de evaluar los métodos de interpretación, aunque

algunos trabajos recientes han comenzado a ocuparse de ella ( 11 - 13 ). Como

resultado, el nivel de evaluación varía considerablemente entre los di ff trabajo Erent,

por lo que es desafiante ing tanto para los investigadores en el campo para medir el

progreso, y para los usuarios potenciales para seleccionar métodos adecuados. En el

marco PDR, para constituir una mejora, un nuevo método de interpretación debe

mejorar al menos un desideratum (precisión pre- predictiva, la precisión descriptiva, o

relevancia) sin dañar indebidamente a los otros. Aunque las mejoras en la exactitud de

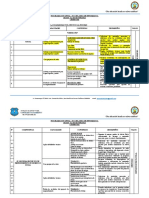

Fig. 4. Importancia de los diferentes factores predictivos en la predicción de la probabilidad de arresto por una persona en predicción son fáciles de medir, medir las mejoras en la precisión descriptiva y

particular. Reproducido con permiso de los autores.

relevancia sigue siendo un reto. áreas menos importantes para la mejora incluyen el

coste computacional y facilidad de implementación.

A nivel de conjunto de datos. Este es un resultado de la heterogeneidad en un modelo de oreja de no

linealidad: la importancia de una característica puede variar para ejemplos Erent di ff como resultado

de interacciones con otras características. En el siguiente ejemplo, las puntuaciones de importancia de

característica se utilizan para aumentar la precisión descriptiva de los modelos de recuadro negro con

A.1. Precisión de medida descriptiva. Una forma de medir una mejoría a un método de

el fin de validar su imparcialidad.

interpretación es demostrar que su salida capta mejor lo que el modelo ML ha

aprendido, es decir, su precisión descriptiva. Sin embargo, a diferencia de la exactitud

. Ex. Al utilizar modelos ML para predecir OUT- sensible trata, por ejemplo, si

de predicción, la precisión descriptiva es generalmente muy difícil de medir o

una persona debe recibir un préstamo o una sentencia penal, es importante verificar

cuantificar. Como de repliegue, los investigadores muestran a menudo individuales,

que el rithm algo- no discrimina a las personas basándose en atributos protegidas,

palmitas, interpretaciones que parecen “razonable”. Este tipo de evaluaciones son

tales como la raza o el sexo . Este problema se describe a menudo como asegurar los

limitados y unfalsi fi cable. En particular, estos resultados se limitan a los pocos

modelos ML son “justo”. en ( dieciséis ), Los Thors au- introducen una importancia

ejemplos que se muestran, y en general no aplicable a todo el conjunto de datos.

variable medida diseñada para aislar las contribuciones de las variables individuales,

como el género, entre un conjunto de variables correlacionadas.

Mientras que la comunidad no se ha asentado en un protocolo de evalua- ción

estándar, hay algunas direcciones prometedoras. En particu- lar, el uso de estudios de

Sobre la base de estas puntuaciones de importancia variable, los autores construyen

simulación presenta una solución parcial. En esta configuración, un investigador define un

informes de transparencia, tales como la que se muestra en la figura 4 . Esta figura muestra la

sencillo proceso generativo, genera una gran cantidad de datos de ese proceso, y entrena a

importancia de las funciones que se utilizan para predecir que "el señor Z" es probable que sea

su modelo ML en esos datos. Suponiendo una configuración adecuada de simulación, un su

detenido en el futuro (un resultado que se utiliza a menudo en el ámbito policial predictiva), con

fi cientemente potente modelo para recuperar el proceso generativo, y su fi cientemente

cada barra corresponde a una característica proporcionada a la ampli fi cación, y el eje y que

grande de datos de entrenamiento, el modelo entrenado debe conseguir una precisión casi

muestra la puntuación de importancia para esa función. En este caso, la función de la raza es el

perfecta generalización. Para com- PUTE una métrica de evaluación, podrán comprobar si

valor más grande, lo que indica que el ampli fi cación de hecho es la discriminación basada en la

sus interpretaciones se recuperan aspectos del pro- ceso generativo original. Por ejemplo, ( 57

raza. Por lo tanto, en este caso, las puntuaciones de importancia característica de nivel de

, 86 ) Entrenar las redes neuronales en un conjunto de modelos generativos con cierta

predicción son capaces de identificar que un modelo injustamente discrimina por motivos de

incorporado en las interacciones, y comprobar si su método de ellas se recupera

raza.

satisfactoriamente. En este caso, debido a la generalización exactitud casi perfecta del

modelo ML, sabemos que el modelo es probable que se han recuperado algunos aspectos

del proceso generativo, proporcionando así una verdad terreno frente a la cual evaluar

B.2. Alternativas a la función de importancias. Mientras que la característica impor- tancia

interpretaciones. En un enfoque relacionado, cuando un problema cientí fi ca subyacente ha

puntuaciones pueden proporcionar información útil, también tienen una serie de sido estudiado con anterioridad, los hallazgos experimentales anteriores pueden servir

limitaciones. Por ejemplo, no son capaces de cap- tura cuando algoritmos aprenden las como una verdad parcial en planta para validar de forma retrospectiva interpretaciones ( 20 ).

interacciones entre las variables. En la actualidad existe un organismo que evoluciona de

trabajo centrada en el descubrimiento y hacer frente a estas limitaciones. Estos métodos

se centran en capturar y mostrar explícitamente las interacciones aprendidas por una red

neuronal ( 81 , 82 ), Formas alternativas de interpretaciones como explicaciones textuales ( 83

), La identificación de puntos de datos influyentes ( 69 ), Y el análisis de vecinos más

A.2. Lo que demuestra la relevancia de los problemas del mundo real. Otra GLE an- para el

cercanos ( 84 , 85 ).

desarrollo de métodos mejorados de interpretación es a me- jorar la relevancia de las

interpretaciones de algunas audiencias o problema. Esto se hace normalmente mediante la

introducción de una nueva forma de salida, tales como mapas de calor de opción ( 71 ),

fundamentos ( 87 jerarquías), carac- terística ( 82 ) O la identificación de elementos importantes en

6. El trabajo futuro

el conjunto de entrenamiento ( 69 ). Un error común en la literatura actual es centrarse

Después de haber introducido el marco PDR para de fi nir y aprendizaje automático exclusivamente en la novela de salida, haciendo caso omiso de lo que los problemas del mundo

palabrotas interpretables dis-, ahora aprovechamos para enmarcar lo que sentimos son los real que realmente puede resolver. Dada la abundancia de interpretaciones posibles, es

retos más importantes del campo hacia adelante. A continuación, se presentan problemas particularmente fácil para los investigadores

abiertos vinculados a cada

preimpresión | Murdoch et al. 2018 | 8

proponer nuevos métodos que en realidad no soluciona ninguna problemas del mundo aprendizaje, que se utiliza a menudo como una herramienta para Fi automáticamente ND- ing

real. estructura relevante en los datos. Las mejoras en las técnicas sin supervisión, tales como la

Ha habido dos enfoques dominantes para demonstrat- relevancia mejorada ing. El agrupación y factorización matriz podrían conducir a características más útiles.

primero, y más fuerte, es utilizar directamente el método introducido en la solución de un

problema de dominio. Por ejemplo, en un ejemplo discutido anteriormente ( 20 ), Los

autores eva- uated un nuevo método de interpretación (bosques aleatorios iterativos), C. post hoc. En contraste con la interpretabilidad basado en modelos, tanto de post hoc

demostrando que podría ser utilizado para identificar las interacciones biológicas de Boole interpretabilidad es relativamente nuevo, con muchos conceptos fundacional todavía no

y de gran utilidad en los experimentos. En instancias en como éste, donde se utilizan las está claro. En particular, consideramos que dos de las cuestiones más importantes que

interpretaciones directamente a resolver un problema de dominio, su relevancia es deben ser respondidas son lo que una interpretación de un modelo ML debe ser similar, y

indiscutible. Un segundo, menos directa, el enfoque es el uso de los estudios en cómo podemos ser utilizados interpretaciones post hoc. Uno de los usos potenciales más

humanos, a menudo a través de servicios como Mechanical Turk de Amazon. A prometedores de interpretaciones post hoc es aumentar la precisión de la predicción de

continuación, se pide a los seres humanos para realizar ciertas tareas, como evaluat- ing un modelo. En un trabajo relacionado, se ha señalado que en altas apuestas decisiones

cuánto confían en las predicciones de un modelo ( 82 ). Mientras que un reto de construir y profesionales deben tener mucho cuidado al aplicar los métodos post hoc con exactitud

realizar de manera adecuada, estos estudios son vitales para demostrar que los nuevos descriptiva desconocido ( 88 ).

métodos de interpretación son, de hecho, relevante para cualquier practicante

potenciales. Sin embargo, un inconveniente de este enfoque es que sólo es posible

utilizar una audiencia general de los trabajadores crowdsourced AMT, en lugar de una

C.1. ¿Qué debe una interpretación de un recuadro negro parecerse. Dado un predictor de recuadro

audiencia fi co más relevante, dominio específico.

negro y problemas del mundo real, por lo general es poco claro qué formato, o una combinación

de formatos, es la mejor manera de captar por completo el comportamiento de un modelo. Los

investigadores han propuesto una variedad de formas de interpretación, incluyendo mapas de

calor de opción ( 71 ), las jerarquías de características (se 82 ) Y la identificación de importantes

ele- mentos en el conjunto de entrenamiento ( 69 ). Sin embargo, en todos los casos existe una

B. basado en modelos. Ahora que hemos hablado de la pro- blema general de la

brecha entre la información relativamente simple proporcionada por estas interpretaciones y lo

evaluación de las interpretaciones, se destacan importantes retos para los dos

que el modelo compleja realidad ha aprendido. Por otra parte, no está claro si alguna de las

principales campos sub-fi de aprendizaje automático interpretable: basados en modelos y

formas interpretación actual puede captar por completo la conducta de un modelo, o si todo se

la interpretación post hoc. Siempre que interpretabilidad basado en el modelo puede

necesita un nuevo formato. Cómo cerrar esa brecha, mientras que la producción de resultados

alcanzar la exactitud de predicción razonable y relevancia, en virtud de su alta precisión

correspondientes a un público / problema particular, es un problema abierto.

descriptiva es preferible a FI tting un modelo más complejo, y confiando en post hoc

interpretabilidad. Por lo tanto, el foco principal para interpretabilidad basado en el modelo

está aumentando su gama de casos de uso po- sible mediante el aumento de su

exactitud de predicción a través de modelos más precisos y la ingeniería característica

transparente. Vale la pena señalar que a veces una combinación de la base de modelos C.2. El uso de interpretaciones para mejorar la precisión de la predicción. En algunos casos,

y post hoc interpretaciones es ideal. las interpretaciones post hoc descubren que un modelo de relaciones ha aprendido un

practicante sabe que es incorrecta. Por ejemplo, el trabajo de interpretación previa ha

demostrado que una ronca binaria vs lobo clasi fi cador simplemente aprende a

identificar si hay nieve en la imagen, haciendo caso omiso de los propios animales ( 78 ).

B.1. La construcción de modelos precisos e interpretables. En muchas instancias en, los métodos

Una pregunta natural es si es posible que el Tioner prác- para corregir estas relaciones

basados en modelos interpretabilidad no logran alcanzar una exactitud de predicción

aprendidas por el modelo, y por lo tanto aumentar su exactitud predictiva. Teniendo en

razonable. En estos casos, los médicos se ven obligados a abandonar las interpretaciones

cuenta los desafíos que rodean simplemente generando interpretaciones post hoc, la

basadas en modelos en busca de modelos más precisos. Por lo tanto, una forma reflexiva e ff

investigación sobre sus usos se ha limitado ( 97 , 98 ). Sin embargo, como el campo de

de aumentar el potencial utiliza para interpretabilidad basado en modelo es de- tornillo de

las interpretaciones post hoc sigue madurando, esto podría ser una buena posibilidad

banco nuevos métodos de modelado que producen mayor exactitud de predicción y

para los investigadores para aumentar la exactitud predictiva de sus modelos

manteniendo su alta precisión descriptiva y relevancia. ejemplos prometedores de este trabajo

explotando el conocimiento previo, independientemente de cualquier otro beneficios de

incluyen los ejemplos discutidos anteriormente en la estimación de riesgo de neumonía de los

interpretaciones.

datos del paciente ( 44 ) Y los modelos bayesianos para la generación de normas lista para

estimar el riesgo de un paciente de accidente cerebrovascular ( 39 ). Las instrucciones

detalladas para este trabajo se sugieren en ( 88 ).

EXPRESIONES DE GRATITUD. Esta investigación fue financiada en parte por subvenciones

ARO W911NF1710005, ONR N00014-16-1-2664, NSF DMS-1613002, 1741340 y NSF IIS, un D

becas CRSNG PGS, y un premio de investigación de Adobe. Agradecemos al Centro de Ciencias

B.2. Herramientas para la ingeniería característica. Cuando tenemos más informa- tivo y las de la Información (CSoI), un Centro de Ciencia y Tecnología de los Estados Unidos NSF, en virtud

características significativas, podemos utilizar métodos de modelado más simples para lograr de acuerdo de subvención CCF-0939370. Reza Abbasi-Asl quisiera agradecer el fundador Allen

Institute, Paul G. Allen, por su visión, aliento y apoyo.

una exactitud de predicción comparables. Así, los métodos que pueden producir

características más útiles ampliar los usos potenciales de las interpretaciones basadas en

modelos. La primera categoría principal de trabajo radica en la mejora de herramientas para

1. Litjens G, et al. (2017) Una encuesta sobre el aprendizaje profundo de análisis de imágenes médicas. de imágenes médicas

el análisis exploratorio de datos. Por mejores investigadores que permiten interactuar y análisis 42: 60-88.

entender sus datos, estas herramientas (junto con el conocimiento de dominio) proporcionan 2. Brennan T, Oliver WL (2013) La aparición de técnicas de aprendizaje automático en criminología.

Criminología y Políticas Públicas 12 (3): 551-562.

un aumento de oportunidades para que puedan identificar características útiles. Los ejemplos

3. Angermueller C, Pärnamaa T, piezas de L, Stegle O (2016) El aprendizaje profundo para la biología computacional. sistemas de Biología

incluyen entornos interactivos ( 89 - 91 ), Herramientas de visualización ( 92 - 94 ), y herramientas Molecular 12 (7): 878.

de exploración de datos ( 95 , 96 ). La segunda categoría cae bajo supervisión 4. Vu MAT, et al. (2018) Una visión compartida para el aprendizaje de máquina en la neurociencia. Journal of Neu-

roscience pp. 0508-17.

5. Goodman B, Flaxman S (2016) la normativa europea sobre la toma de decisiones algorítmico y un "derecho a la explicación". arXiv

arXiv: 1606.08813.

preimpresión | Murdoch et al. 2018 | 9

6. Dwork C, Hardt M, Pitassi T, Reingold O, Zemel R (2012) equidad a través de la conciencia en (IEEE), vol. 1, pp. 886-893.

Actas de la 3ª Conferencia de las innovaciones en la informática teórica. ( ACM), pp. 214-226. 47. Shi T, Yu B, Clothiaux EE, Braverman AJ (2008) durante el día detección de nubes ártico basado en datos de satélite de múltiples

ángulos con estudios de casos. Revista de la Asociación Americana de Estadística

7. Chakraborty S, et al. (2017) interpretabilidad de los modelos de aprendizaje profundas: una encuesta de los resultados en 103 (482): 584-593.

Interpretabilidad de los modelos de aprendizaje profundas: una encuesta de los resultados. 48. Jolliffe I (1986) Análisis de componentes principales.

8. Guidotti R, Monreale A, Turini F, Pedreschi D, Giannotti F (2018) Un estudio de métodos para explicar los modelos de caja negra. arXiv 49. Campana AJ, Sejnowski TJ (1995) Un enfoque de maximización de la información para cegar la separación y deconvolución ciega. computación

arXiv: 1802.01933. neuronal 7 (6): 1129-1159.

9. Lundberg SM, Lee SI (2017) Un enfoque unificado para la interpretación de las predicciones del modelo en Avances 50. Hotelling H (1936) Las relaciones entre dos conjuntos de variables aleatorias. Biométrika 28 (3/4): 321-377.

en Neuronales Sistemas de Procesamiento. pp. 4768 a 4777. 51. Wu S, et al. (2016) Estabilidad-driven matriz de factorización no negativa de interpretar la expresión de genes espacial y construir

10. Ancona M, Ceolini E, Oztireli C, Gross M (2018) Hacia una mejor comprensión de los métodos de atribución gradientbased para redes redes de genes locales. procedimientos de la Academia Nacional de Ciencias

neuronales profundos en 6ª Conferencia Internacional sobre Representaciones de Aprendizaje (ICLR 2018). 113 (16): 4290-4295.

52. Olden JD, alegría MK, RG Muerte (2004) una comparación precisa de los métodos para cuantificar la importancia variable en arti fi

11. Doshi-Velez M, KIMB (2017) Una hoja de ruta para una ciencia rigurosa de interpretabilidad. arXiv ciales redes neuronales utilizando datos simulados. Ecological Modelling

arXiv: 1702.08608. 178 (3-4): 389-397.

12. Gilpin LH, et al. (2018) Explicando explicaciones: una aproximación a la evaluación de interpretabilidad de aprendizaje automático. arXiv 53. Breiman L (2001) Random bosques. Aprendizaje automático 45 (1): 5-32.

arXiv: 1806.00069. 54. Strobl C, Boulesteix AL, Kneib T, T Augustin, Zeileis A (2008) Condicional importancia variable para los bosques aleatorios. bioinformática

13. Lipton ZC (2016) El mythos de modelo interpretabilidad. arXiv arXiv: 1606.03490. BMC 9 (1): 307.

14. Hardt M, Precio E, Srebro N,, et al. (2016) La igualdad de oportunidades en el aprendizaje supervisado 55. Altmann A, Tolo Si L, O Sander, Lengauer T (2010) Permutación importancia: un corrige

Los avances en los sistemas de procesamiento de información neural. pp. 3.315 hasta 3.323. característica medida de importancia. bioinformática 26 (10): 1340-1347.

15. Boyd D, K Crawford (2012) Las preguntas críticas para grandes datos: Las provocaciones de un fenómeno cultural, tecnológica y 56. Kumbier K, S Basu, Brown JB, Celniker S, Yu B (2018) Re fi nir búsqueda interacción a través de los bosques al azar iterativos

académica. La información, la comunicación y la sociedad 15 (5): 662-679. firmados. arXiv arXiv: 1810.07287.

16. Datta A, Sen S, Zick Y (2016) la transparencia algorítmico través de la entrada cuantitativa influencia: Teoría y experimentos con 57. Tsang M, Cheng D, Liu Y (2017) la detección de interacciones estadísticos de pesos de la red neural.

sistemas de aprendizaje en Seguridad y Privacidad (SP), 2016 IEEE Simposio sobre. ( IEEE), pp. 598-617. arXiv arXiv: 1705.04977.

58. Abbasi-Asl R, Yu B (2017) de compresión estructural de redes neuronales convolucionales basado en codicioso poda de filtro. arXiv

17. Keil FC (2006) Explicación y comprensión. Annu. Rev. Psychol. 57: 227-254. arXiv: 1705.07356.

18. Lombrozo T (2006) La estructura y función de las explicaciones. Tendencias en las ciencias cognitivas 59. O fi cina de Investigación Institucional HU (2018) 157 Anexo: Demografía de har-

10 (10): 464-470. Vard aspirantes de la universidad. http://samv91khoyt2i553a2t1s05i-wpengine.netdna-ssl.com/wp-

19. Imbens GW, Rubin DB (2015) La inferencia causal en las estadísticas, social y ciencias biomédicas. content / uploads / 2018/06 / Doc-421-157-May-30-2013-Report.pdf pp. 8-9.

(Prensa de la Universidad de Cambridge). 60. Arcidiacono PS (2018) Anexo una: Experto reporte de peter s. arcidi-

20. Basu S, Kumbier K, Brown JB, Yu B (2018) bosques aleatorios iterativos para descubrir las interacciones de alto orden de predicción y acono. http://samv91khoyt2i553a2t1s05i-wpengine.netdna-ssl.com/wp-

estables. procedimientos de la Academia Nacional de Ciencias pags. content / uploads / 2018/06 / Doc-415-1-Arcidiacono-Expert-Report.pdf.

201711236. 61. Tarjeta D (2018) Anexo 33: Informe de la tarjeta de David. https://projects.iq.harvard.edu/ archivos / Diverso-

21. Yu B (2013) Estabilidad. Bernoulli 19 (4): 1484-1500. educación / archivos / legal _-_ ling.pdf card_report_revised_ fi.

22. Hampel FR, Ronchetti EM, Rousseeuw PJ, Stahel WA (2011) estadística robusta: el enfoque 62. Zeiler MD, Fergus R (2014) visualizar y la comprensión de las redes convolucionales en Euro-

basado en las funciones de influencia. ( John Wiley & Sons) Vol. 196. Pean conferencia sobre la visión por ordenador. ( Springer), pp. 818-833.

23. Pimentel H, Hu Z, Huang H (2018) Biclustering por análisis de correlación canónica escasa. 63. Olah C, Mordvintsev A, Schubert L visualización (2017) Característica. Destilar 2 (11): e7.

Biología cuantitativa 6 (1): 56-67. 64. Mordvintsev A, Olah C, Tyka M (2015) Deepdream-un ejemplo de código para la visualización de las redes neuronales. Investigación

24. Abbasi-Asl R, et al. (2018) El marco deeptune para el modelado y las neuronas que caracterizan en visual v4 área de la corteza. bioRxiv google 2: 5.

pags. 465.534. 65. Wei D, Zhou B, Torrabla A, W Freeman (2015) La comprensión de los conocimientos dentro de la clase dentro de la CNN. arXiv

25. Roe AW, et al. (2012) Hacia una teoría unificada de v4 área visual. Neurona 74 (1): 12-29. arXiv: 1507.02379.