Академический Документы

Профессиональный Документы

Культура Документы

ENTROPIA

Загружено:

Mercedes Mendoza0 оценок0% нашли этот документ полезным (0 голосов)

32 просмотров4 страницыLa definicion de entropia en el campo de la termodinamica es muy requerido por tanto su estudio es arduo y un complejo pero una vez que se haya dominado bien los conceptos no habra problema en su desarrollo

Авторское право

© © All Rights Reserved

Доступные форматы

DOCX, PDF, TXT или читайте онлайн в Scribd

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документLa definicion de entropia en el campo de la termodinamica es muy requerido por tanto su estudio es arduo y un complejo pero una vez que se haya dominado bien los conceptos no habra problema en su desarrollo

Авторское право:

© All Rights Reserved

Доступные форматы

Скачайте в формате DOCX, PDF, TXT или читайте онлайн в Scribd

0 оценок0% нашли этот документ полезным (0 голосов)

32 просмотров4 страницыENTROPIA

Загружено:

Mercedes MendozaLa definicion de entropia en el campo de la termodinamica es muy requerido por tanto su estudio es arduo y un complejo pero una vez que se haya dominado bien los conceptos no habra problema en su desarrollo

Авторское право:

© All Rights Reserved

Доступные форматы

Скачайте в формате DOCX, PDF, TXT или читайте онлайн в Scribd

Вы находитесь на странице: 1из 4

ENTROPÌA

http://entropia1020.blogspot.com/2009/02/ley-de-la-entropia_05.html

INTRODUCCIÒN

Este trabajo lo realizaremos con el propósito de dar a conocer algunos

aspectos relacionados con la ley de la entropía; aspectos tales como su

concepto, origen, características, ejemplos, algunas imágenes relacionadas

con el tema y un mapa conceptual donde podemos ver claramente aspectos

de esta ley.

CONCEPTO

La entropía es el segundo principio de la termodinámica que puede definirse

esquemáticamente como el "progreso para la destrucción" o "desorden

inherente a un sistema.

La entropía significa, expresado en términos vulgares, que todo va para peor

o, lo que es lo mismo, que todo empeora o se arruina irremisiblemente.

Los sistemas tienden a buscar su estado más probable (posible), es decir,

busca un nivel mas estable que tiende a ser lo más caótico.

Se llama estado de máxima entropía en el preciso instante cuando el

sistema este a punto de cambiar de un estado “e” a un estado “e+1”.

La entropía está relacionada con la tendencia natural de los objetos a caer

en un estado de desorden. Todos los sistemas no vivos tienden hacia el

desorden; si los deja aislados, perderán con el tiempo todo movimiento y

degenerarán, convirtiéndose en una masa inerte.

La entropía de un sistema es el desgaste que el sistema presenta por el

transcurso del tiempo o por el funcionamiento del mismo. Los sistemas

altamente en trópicos tienden a desaparecer por el desgaste generado por

su proceso sistémico. Los mismos deben tener rigurosos sistemas de control

y mecanismos de revisión, reelaboración y cambio permanente, para evitar

su desaparición a través del tiempo.

ORIGEN

Originalmente, "entropía" surgió como palabra acuñada del griego, de em

(en-en, sobre, cerca de...) y sqopg (tropêe-mudanza, giro, alternativa, cambio,

evolución...).

El término fue usado por primera vez en 1850 por el físico alemán Rudolf

Julius Emmanuel Clausius (1822-1888). Para calificar el grado de desorden

de un sistema. Por tanto la segunda ley de la termodinámica dice que los

sistemas aislados tienden al desorden. En la teoría de la comunicación o de

la información, la entropía es un número que mide la incertidumbre de un

mensaje. La entropía es nula cuando la certeza es absoluta.

Cuando añadimos información a un objeto físico lo que estamos haciendo es

ordenar de una forma determinada los elementos que componen el sistema

de ese objeto. Si estamos tallando una piedra de sílex para convertirla en

punta de flecha, estamos seleccionando (mediante la eliminación de las

lascas) las partes de la piedra que mantienen un cierto orden; lo que

caracteriza una punta de flecha, su simetría, triangularidad y borde afilado,

es precisamente el orden de sus componentes. Ese orden es, precisamente,

la información tecnológica. Cualquier cambio aleatorio que se produzca en la

forma de la flecha tendrá un efecto de aumento de su entropía, es decir, de

pérdida de orden y de la información que contiene.

CARACTERISTICAS

La entropía se define solamente para estados de equilibrio.

Solamente pueden calcularse variaciones de entropía. En muchos problemas

prácticos como el diseño de una maquina de vapor , consideramos

únicamente diferencias de entropía. Por conveniencia se considera nula la

entropía de una sustancia en algún estado de referencia conveniente. Así se

calculan las tablas de vapor, e donde se supone cero la entropía del agua

cuando se encuentra en fase liquida a 0'C y presión de 1 atm.

La entropía de un sistema en estado se equilibrio es únicamente función del

estado del sistema, y es independiente de su historia pasada. La entropía

puede calcularse como una función de las variables termodinámicas del

sistema, tales como la presión y la temperatura o la presión y el volumen.

La entropía en un sistema aislado aumenta cuando el sistema experimenta

un cambio irreversible.

Considérese un sistema aislado que contenga 2 secciones separadas con

gases a diferentes presiones. Al quitar la separación ocurre un cambio

altamente irreversible en el sistema al equilibrarse las dos presiones. Pero el

mediano ha sufrido cambio durante este proceso, así que su energía y su

estado permanecen constantes, y como el cambio es irreversible la entropía

del sistema a aumentado.

En un sistema cerrado la entropía siempre debe ser positiva. Sin embargo en

los sistemas abiertos biológicos o sociales, la entropía puede ser reducida o

mejor aun transformarse en entropía negativa, es decir, un proceso de

organización más completa y de capacidad para transformar los recursos.

Esto es posible porque en los sistemas abiertos los recursos utilizados para

reducir el proceso de entropía se toman del medio externo. Así mismo, los

sistemas vivientes se mantienen en un estado estable y pueden evitar el

incremento de la entropía y aun desarrollarse hacia estados de orden y de

organización creciente.

EJEMPLOS

1. Cuando añadimos información a un objeto físico lo que estamos haciendo

es ordenar de una forma determinada los elementos que componen el

sistema de ese objeto. Por ejemplo, consideremos un producto de nuestra

fábrica. Para este objeto recopilamos las características físicas del mismo

(material, forma, tamaño, color,…) y las características propias de su diseño

y fabricación (documentación, versionado, iteración, autor, workflow,…), es

decir, estamos ordenando el objeto a través de su información tecnológica.

Cualquier cambio aleatorio en las mismas provoca una pérdida de orden, un

aumento de la entropía. La misma idea se puede aplicar a las informaciones

de tipo conocimiento o de tipo logístico. Información sobre datos.

Una organización puede considerarse como un sistema en que la se genera

información a partir de datos. Cuando la empresa alcanza un nivel crítico los

niveles de datos e información del mismo han crecido de forma exponencial

y tienden a la desorganización (pérdida de datos, lenta localización de los

mismos, aumentos de los gastos en recursos, pérdida de capacidad de

reacción frente a los cambios del mercado).

Por lo tanto, nos encontramos en la situación anterior. Como todos los

sistemas, se presenta una tendencia al aumento de la entropía. Por lo tanto,

es necesario mecanismos para reducir la entropía. Es cuando entra en juego,

la gestión de la información a través de herramientas. Una forma de entender

las herramientas de gestión de la información es como agentes cuyo objetivo

es frenar o disminuir la entropía inherente a las organizaciones. Con lo que

se añade energía al sistema para corregir el desorden. Es una forma casi

poética de ver las cosas.

2. se han utilizado muchos ejemplos para explicar esta ley; uno de ellos

señala que si destapamos un frasco de perfume y todo su contenido se

evapora, para que se vuelva a introducir en el frasco tal como estaba es

imposible. Tan imposible como que, en el juego del truco, un 4 le gane al A

de espadas.

Вам также может понравиться

- Cuestionario de Transferencia de ClasesДокумент4 страницыCuestionario de Transferencia de ClasesMercedes MendozaОценок пока нет

- Difusión Interfacial de Masa Local Entre Dos FasesДокумент3 страницыDifusión Interfacial de Masa Local Entre Dos FasesMercedes MendozaОценок пока нет

- Iess y Sercop - Deber 2 - Tonato - Mendoza PDFДокумент8 страницIess y Sercop - Deber 2 - Tonato - Mendoza PDFMercedes MendozaОценок пока нет

- Deberes Quimi Orgánica Industrialtercera MatriculaДокумент3 страницыDeberes Quimi Orgánica Industrialtercera MatriculaMercedes MendozaОценок пока нет

- Contaminación atmosférica: causas y efectosДокумент182 страницыContaminación atmosférica: causas y efectosMercedes MendozaОценок пока нет

- Nematicidas Biologico y Naturales Una Forma de Reemplazar A Los TradicionalesДокумент7 страницNematicidas Biologico y Naturales Una Forma de Reemplazar A Los TradicionalesMercedes MendozaОценок пока нет

- 5 Empresas Con Los Balances Más Fuertes Del MundoДокумент2 страницы5 Empresas Con Los Balances Más Fuertes Del MundoMercedes MendozaОценок пока нет

- Contaminación de Materiales Nocivos PDFДокумент6 страницContaminación de Materiales Nocivos PDFMercedes MendozaОценок пока нет

- 5 Empresas Con Los Balances Más Fuertes Del MundoДокумент2 страницы5 Empresas Con Los Balances Más Fuertes Del MundoMercedes MendozaОценок пока нет

- Directrices para Optar Por El Consenso de Laborar El Feriado Del DíaДокумент4 страницыDirectrices para Optar Por El Consenso de Laborar El Feriado Del DíaEcuadorenvivoОценок пока нет

- Proyecto OrgánicaДокумент9 страницProyecto OrgánicaMercedes MendozaОценок пока нет

- Estructura Del Ministerio de TrabajoДокумент10 страницEstructura Del Ministerio de TrabajoMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Cinetica Quimica de La Desintegracion de Diferentes Estructuras VegetalesДокумент6 страницCinetica Quimica de La Desintegracion de Diferentes Estructuras VegetalesMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Reacciones Espontáneas EjemplosДокумент2 страницыReacciones Espontáneas EjemplosMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Entalpia - Entropia VideosДокумент1 страницаEntalpia - Entropia VideosMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- Diferencia químico físico escala comercialДокумент3 страницыDiferencia químico físico escala comercialMercedes MendozaОценок пока нет

- ELECTROQUÍMICAДокумент3 страницыELECTROQUÍMICAMercedes MendozaОценок пока нет

- Determinación de Dureza Del Agua PotableДокумент4 страницыDeterminación de Dureza Del Agua PotableMercedes MendozaОценок пока нет

- TERMODINAMICAДокумент4 страницыTERMODINAMICAMercedes MendozaОценок пока нет

- Mecanismos de Transferencia DecalorДокумент5 страницMecanismos de Transferencia DecalorMercedes MendozaОценок пока нет

- FDS Skuper v4 2019Документ12 страницFDS Skuper v4 2019Fernando Mirquez NuñezОценок пока нет

- Reporte 1 Quimica Del CarbonДокумент11 страницReporte 1 Quimica Del CarbonAlejandra Ramirez100% (1)

- Balance de Materia Energia VCMДокумент48 страницBalance de Materia Energia VCMHenryJhoelSaldañaBustamanteОценок пока нет

- Digestión proteínas pepsina PhysioEx Ej8A3Документ2 страницыDigestión proteínas pepsina PhysioEx Ej8A3Liliana Uriarte Cortez50% (2)

- Evaluacion Por Competencia 1° Periodo 10°Документ3 страницыEvaluacion Por Competencia 1° Periodo 10°EDILMAОценок пока нет

- T2 Mapa MecanismoДокумент3 страницыT2 Mapa MecanismoJavier MoralesОценок пока нет

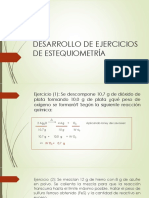

- Desarrollo de Ejercicios de EstequiometríaДокумент6 страницDesarrollo de Ejercicios de EstequiometríaAnaid LOОценок пока нет

- Guia 9 Impulso Momentum Conservacion Momentum de Un Sistema Aislado s1 2013 2Документ3 страницыGuia 9 Impulso Momentum Conservacion Momentum de Un Sistema Aislado s1 2013 2Bárbara Muñoz Madariaga0% (1)

- Seguridad y Protección Radiológica en Tomografía Computarizada (TC)Документ1 страницаSeguridad y Protección Radiológica en Tomografía Computarizada (TC)Oscar EspinosaОценок пока нет

- Problemas de Mecánica (Ing. Civil UCVДокумент6 страницProblemas de Mecánica (Ing. Civil UCVJose Leonel Ramos LОценок пока нет

- Informe 2da Ley de NewtonДокумент13 страницInforme 2da Ley de NewtonJonathan BatistaОценок пока нет

- Resolución de Problemas de DIFUSIÓNДокумент5 страницResolución de Problemas de DIFUSIÓNDennys Gabriel Marquez FloresОценок пока нет

- APENDICEДокумент1 страницаAPENDICEAkiles VaesaОценок пока нет

- Guía Práctica #03 Máquinas EléctricasДокумент7 страницGuía Práctica #03 Máquinas EléctricasJheremitОценок пока нет

- Practica 10 ModificadaДокумент26 страницPractica 10 ModificadaJavier Antonio (Solis Valles)Оценок пока нет

- Ejercicio Sobre El Informe S9Документ9 страницEjercicio Sobre El Informe S9pachy_rg100% (1)

- Formulas Física General - 2020Документ3 страницыFormulas Física General - 2020EstefaniaОценок пока нет

- Syllabus Fisica SecundariaДокумент4 страницыSyllabus Fisica SecundariaBray TRОценок пока нет

- Determinar La Presion Estatica de FondoДокумент43 страницыDeterminar La Presion Estatica de FondoJoel Pasache NeiraОценок пока нет

- Guia Teorica de VolcanesДокумент2 страницыGuia Teorica de VolcanesAndreea Blanco VeraОценок пока нет

- ENTROPIAДокумент2 страницыENTROPIADiego ValenzuelaОценок пока нет

- Reporte de La Actividad de SolubilidadДокумент6 страницReporte de La Actividad de SolubilidadwendyОценок пока нет

- Poligono FunicularДокумент15 страницPoligono FunicularAdriana HerreraОценок пока нет

- Cristalografia 1-2Документ10 страницCristalografia 1-2Ader Rada ValdizanОценок пока нет

- Informe Puente Levadizo 2.0Документ5 страницInforme Puente Levadizo 2.0Cristian ZevallosОценок пока нет

- Conceptos Preliminares Flujo Lámina LibreДокумент18 страницConceptos Preliminares Flujo Lámina LibreKatherine Carranza AlcaldeОценок пока нет

- Retro Ejercicios Calculos U2 Ad17Документ12 страницRetro Ejercicios Calculos U2 Ad17Jose EcОценок пока нет

- Ejemplos de Redes CristalinasДокумент13 страницEjemplos de Redes CristalinasEder RamirezОценок пока нет

- Tema 4 Soluciones 2014Документ135 страницTema 4 Soluciones 2014Pancho ArrouchОценок пока нет

- Los Eclipses Solares y LunaresДокумент5 страницLos Eclipses Solares y LunaresLatoya WilliamsОценок пока нет