Академический Документы

Профессиональный Документы

Культура Документы

Tema 62

Загружено:

kudasai_sugoiОригинальное название

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Tema 62

Загружено:

kudasai_sugoiАвторское право:

Доступные форматы

1/25

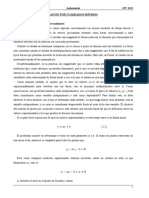

TEMAS DE MATEMTICAS

(Oposiciones de Secundaria)

TEMA 62

SERIES ESTADSTICAS BIDIMENSIONALES. COEFICIENTE DE VARIACIN.

VARIABLE NORMALIZADA. APLICACIN AL ANLISIS, INTERPRETACIN

Y COMPARACIN DE DATOS ESTADSTICOS.

1. Distribuciones Bidimensionales de Frecuencias.

1.1. Independencia y Relacin Funcional de dos Variables.

1.2. Tablas de Correlacin y de Contingencia.

1.3. Distribuciones Marginales.

1.4. Distribuciones Condicionadas.

1.5. Independencia Estadstica.

2. Representaciones Grficas.

3. Momentos de Distribuciones Bidimensionales.

3.1. Momentos Respecto al Origen.

3.2. Momentos Respecto a las Medias.

3.3. Clculo de los Momentos Centrales en funcin de los Momentos Respecto al

Origen.

3.4. Mtodo Reducido para el Clculo de Varianza y Covarianza.

3.5. Valor de la Covarianza en caso de Independencia Estadstica.

4. Ajuste.

4.1. Mtodo de los Mnimos Cuadrados.

4.1.1. Ajuste de una Recta.

4.1.2. Ajuste de una Parbola.

4.1.3. Ajuste Hiperblico.

4.1.4. Ajuste Potencial.

4.1.5. Ajuste Exponencial.

4.2. Mtodo de los Momentos.

5. Regresin.

5.1. Regresin Lineal.

5.1.1. Recta de Regresin de Y sobre X.

5.1.2. Recta de Regresin de X sobre Y.

5.2. Coeficientes de Regresin.

6. Correlacin.

6.1. Campo de Variacin de R y su Interpretacin.

6.2. Coeficiente de Correlacin Lineal.

6.3. Interpretacin Analtica de r.

6.4. Interpretacin Geomtrica de r.

7. Varianza debida a la Regresin y Coeficiente de Determinacin Lineal.

8. Aplicaciones de la Regresin y la Correlacin.

8.1. Uso y Abuso de la Regresin.

8.2. Prediccin.

Bibliografa Recomendada.

2/25

TEMA 62

SERIES ESTADSTICAS BIDIMENSIONALES. COEFICIENTE DE VARIACIN.

VARIABLE NORMALIZADA. APLICACIN AL ANLISIS, INTERPRETACIN

Y COMPARACIN DE DATOS ESTADSTICOS.

1. DISTRIBUCIONES BIDIMENSIONALES DE FRECUENCIAS.

Si estudiamos sobre la misma poblacin dos caracteres cuantitativos X e Y y los

medimos en las mismas unidades estadsticas, obtenemos dos series estadsticas de las

variables X e Y. Considerando simultneamente ambas series, el par de valores (x

i

,y

i

) le

corresponde una variable estadstica Bidimensional.

Es posible estudiar de forma separada la distribucin de la poblacin segn el

carcter X o Y, obteniendo

y x

S y S x , , , o cualquier otro parmetro. Pero puede ser

interesante considerar de forma simultnea los dos caracteres, con el objetivo de

determinar las posibles relaciones entre ellos y as poder responder a preguntas como

Existe algn tipo de relacin entre los caracteres X e Y?.

Vamos a ver instrumentos estadsticos que nos van a permitir obtener la existencia o

no de coincidencias entre los valores de dos variables y, a partir de esas coincidencias,

formular la hiptesis de una relacin causal entre los dos caracteres.

Si existen coincidencias estadsticas entre los valores de dos caracteres, o lo que es

lo mismo, si existe relacin entre las dos variables, las coincidencias pueden ser ms o

menos fuertes, y la intensidad de la relacin puede variar entre ausencia total de relacin

o ligazn perfecta.

1.1. Independencia y Relacin Funcional de dos Variables.

DEF Diremos que dos variables son independientes cuando no existe relacin entre

ambas. Inversamente, cuando la relacin entre dos variables es perfecta, diremos que

estn relacionadas funcionalmente, lo cual implica que su relacin puede expresarse

como y=f(x).

DEF Diremos que Y depende funcionalmente de X cuando podamos establecer una

aplicacin que nos transforme los elementos de X en elementos de Y.

Desde el punto de vista de la Estadstica, lo que realmente nos interesa es que

podemos determinar los elementos de Y conocidos los de X, o viceversa. Pero esa

circunstancia no ser muy habitual. Existen caractersticas como la estatura y el peso,

consumo y renta, etc. en los que aun existiendo interrelacin, es imposible definir una

aplicacin en el sentido estrictamente matemtico. Es decir, no dependen

funcionalmente una de otra.

Estadsticamente hablando, es claro que el peso depende en cierta forma de la

estatura, el consumo depende de la renta, etc. Este tipo de relacin no expresable a

travs de una determinada aplicacin es la conocida como Dependencia Estadstica. Y

3/25

este tipo de dependencia si admite grados, ya que puede haber dependencias ms o

menos fuertes.

Estos tipos de dependencia se pueden expresar grficamente mediante un segmento

de la recta real, donde en un extremo situamos la dependencia funcional y en el otro la

independencia. Los puntos intermedios del segmento se corresponden con los diferentes

grados de dependencia estadstica.

1.2. Tablas de Correlacin y de Contingencia.

Dada una poblacin, en la que estudiamos simultneamente dos caracteres X e Y,

podemos representar la distribucin mediante ternas de la forma (x

i

, y

j

, n

ij

), donde x

i

e y

j

son dos valores cualesquiera y n

ij

es la frecuencia absoluta conjunta del valor i-simo de

X y j-simo de Y.

Los resultados se pueden representar en una tabla de doble entrada conocida como

Tabla de Correlacin.

X \ Y y

1

y

2

y

n

n

i .

x

1

n

11

n

12

n

1n

n

1

x

2

n

21

n

22

n

2n

n

2

x

m

n

m1

n

m2

n

mn

n

m

n

.j

n

1

n

2

n

n

N

Si la distribucin bidimensional es de atributos, la tabla de doble entrada recibe el

nombre de Tabla de Contingencia.

1.3. Distribuciones Marginales.

A partir de una distribucin bidimensional podemos realizar el estudio de cada una

de las variables de forma aislada. Tendramos as dos distribuciones unidimensionales

las cuales seran las correspondientes a X e Y respectivamente.

Para poder obtenerlas, necesitamos determinar las frecuencias marginales. La

distribucin marginal de X se halla obteniendo cuantas veces se repite el valor x

i

,

independientemente de que aparezca conjuntamente o no con algn valor de Y. As,

tenemos que la distribucin marginal de X sera:

X n

i

x

1

n

j

j

n n

1

1 1

x

2

n

j

j

n n

1

2 2

x

m

n

j

mj m

n n

1

4/25

Anlogamente obtendramos la distribucin marginal de Y.

1.4. Distribuciones Condicionadas.

Se pueden formar otro tipo de distribuciones unidimensionales en las que

previamente hara falta definir una condicin. En general, las distribuciones de X

condicionadas a que Y tome un determinado valor (por ejemplo y

j

) son:

x

i

/y

j

n

i/j

x

1

n

1j

x

2

n

2j

x

m

n

mj

n

j

De forma anloga construiramos las distribuciones de Y condicionadas a que X

tome un determinado valor.

La frecuencia relativa de la distribucin condicionada a algn valor de y es:

j

ij

j i

n

n

f

/

Anlogamente, la frecuencia relativa de la distribucin condicionada a algn valor de x

es:

/

i

ij

i j

n

n

f

1.5. Independencia Estadstica.

DEF Diremos que dos variables X e Y son independientes estadsticamente cuando la

frecuencia relativa conjunta es igual al producto de las frecuencias relativas marginales.

Es decir:

j i

N

n

N

n

N

n

j

i

ij

,

En este caso, las frecuencias relativas condicionadas sern:

N

n

n

N

n

n

n

n

f

i

j

j

i

j

ij

j i

/

N

n

n

N

n

n

n

n

f

j

i

j

i

i

ij

i j

/

Como vemos, las frecuencias relativas condicionadas son iguales a sus

correspondientes frecuencias relativas marginales, lo que nos indica que el

condicionamiento no existe. Las variables son independientes, puesto que en las

5/25

distribuciones marginales se estudia el comportamiento de una variable con

independencia de los valores que pueda tomar la otra.

2. REPRESENTACIONES GRFICAS.

La representacin grfica ms utilizada consiste en representar cada pareja de

valores mediante un punto en un sistema de ejes coordenados. Por tanto, la distribucin

vendr dada por un conjunto de puntos que recibe el nombre de Nube de Puntos o

Diagrama de Dispersin. Cuando una pareja de valores est repetida, junto a la

representacin del punto correspondiente se indica el valor de su frecuencia.

La representacin grfica de la nube de puntos puede hacerse tanto con datos

agrupados (las marcas de clase son las que se representan) como con datos sin agrupar.

En el diagrama de tres dimensiones y utilizando los lmites de intervalos (no las marcas

de clase), el escalograma ms adecuado es el constituido por paraleleppedos cuyo

volumen sea la correspondiente frecuencia, y los lados de la base cada una de las

amplitudes de los respectivos intervalos de las variables, y donde n

ij

es el volumen del

paraleleppedo y h

ij

la altura del mismo.

ij j j i i ij

h L L L L n ) )( (

1 1

3. MOMENTOS DE DISTRIBUCIONES BIDIMENSIONALES.

Al igual que se definen los momentos en las distribuciones unidimensionales,

podemos hacerlo en las bidimensionales. Por tanto, podemos distinguir entre momentos

respecto al origen y momentos respecto a la media.

3.1. Momentos Respecto al Origen.

DEF Definimos el momento de orden r,s respecto al origen para la distribucin

(x

i

,y

j

,n

ij

) como

m

i

n

j

ij

s

j

r

i rs

N

n

y x

1 1

Podemos calcular los momentos de primer orden:

x

N

n

x

N

n

x

N

n

x

N

n

y x

m

i

i

i

m

i

n

j

ij

i

m

i

n

j

ij

i

m

i

n

j

ij

j i

1

1 1 1 1 1 1

0 1

10

y

N

n

y

N

n

y

N

n

y

N

n

y x

n

j

j

j

n

j

m

i

ij

j

m

i

n

j

ij

j

m

i

n

j

ij

j i

1

1 1 1 1 1 1

1 0

01

Tambin resulta sencillo calcular los momentos de segundo orden:

6/25

m

i

i

i

m

i

n

j

ij

i

m

i

n

j

ij

i

m

i

n

j

ij

j i

N

n

x

N

n

x

N

n

x

N

n

y x

1

2

1 1

2

1 1

2

1 1

0 2

20

n

j

j

j

n

j

m

i

ij

j

m

i

n

j

ij

j

m

i

n

j

ij

j i

N

n

y

N

n

y

N

n

y

N

n

y x

1

2

1 1

2

1 1

2

1 1

2 0

02

m

i

n

j

ij

j i

N

n

y x

1 1

01

3.2. Momentos Respecto a las Medias.

DEF Definimos el momento de orden r,s respecto a las medias para la distribucin

(x

i

,y

j

,n

ij

) como:

( ) ( )

m

i

n

j

ij s

j

r

i rs

N

n

y y x x

1 1

Los momentos de primer orden son

( ) ( ) ( ) ( ) ( ) 0

1

1 1 1 1 1 1

0 1

10

m

i

i

i

m

i

n

j

ij

i

m

i

n

j

ij

i

m

i

n

j

ij

j i

N

n

x x

N

n

x x

N

n

x x

N

n

y y x x

( ) ( ) ( ) ( ) ( ) 0

1

1 1 1 1 1 1

1 0

01

n

j

j

j

n

j

m

i

ij

j

m

i

n

j

ij

j

m

i

n

j

ij

j i

N

n

y y

N

n

y y

N

n

y y

N

n

y y x x

Los Momentos de segundo orden son:

( ) ( ) ( ) ( ) ( )

2

1

2

1 1

2

1 1

2

1 1

0 2

20 X

m

i

i

i

m

i

n

j

ij

i

m

i

n

j

ij

i

m

i

n

j

ij

j i

S

N

n

x x

N

n

x x

N

n

x x

N

n

y y x x

( ) ( ) ( ) ( ) ( )

2

1

2

1 1

2

1 1

2

1 1

2 0

02 Y

n

j

j

j

n

j

m

i

ij

j

m

i

n

j

ij

j

m

i

n

j

ij

j i

S

N

n

y y

N

n

y y

N

n

y y

N

n

y y x x

( ) ( )

XY

m

i

n

j

ij

j i

S

N

n

y y x x

1 1

1 1

11

DEF Llamamos Covarianza al momento

11

, que tambin se representa por S

XY

.

3.3. Clculo de los Momentos Centrales en Funcin de los Momentos respecto al

Origen.

Al igual que sucede en las distribuciones unidimensionales, los momentos centrales

de una distribucin bidimensional pueden expresarse en funcin de los momentos

respecto del origen.

7/25

Veamos:

( ) ( )

2

10 20

2

10

2

10 20

2

10 20

1

2

1

1

2

1

2

2

1

2

20

2 2

2 2

+ +

+ +

x x

N

n

x

N

n

x x

N

n

x

N

n

x x x x

N

n

x x

m

i

i

m

i

i

i

m

i

i

i

m

i

i

i i

m

i

i

i

Por tanto tenemos que

2

10 20 20

2

X

S

De forma anloga comprobaramos que

2

01 02 02

2

Y

S

Adems, de la covarianza podemos decir:

( ) ( ) ( ) +

m

i

n

j

ij

i j j i

m

i

n

j

ij

j i XY

N

n

x y x y y x y x

N

n

y y x x S

1 1 1 1

1 1

11

+

m

i

n

j

ij

m

i

n

j

ij

i

m

i

n

j

ij

j

m

i

n

j

ij

j i

N

n

y x

N

n

x y

N

n

y x

N

n

y x

1 1 1 1 1 1 1 1

01 10 11 01 10 10 01 01 10 11 10 01 11

+ + y x y x

Nos queda que la covarianza es

01 10 11 11

XY

S

3.4. Mtodo Reducido para el Clculo de Varianza y Covarianza.

En aquellos casos en los que nos pueda parecer conveniente, podemos realizar

determinados cambios de variable para as simplificar los clculos.

Los cambios de variable siempre sern los mismos:

1

1 '

c

O x

x

i

i

2

2

'

c

O y

y

j

j

siendo O

1

y O

2

orgenes de trabajo arbitrarios que se procuran sean puntos centrales de

la distribucin.

As, sabemos que:

'

2 1

2 ' 2

2

2

2 ' 2

1

2

2 2

1 1

) (

) (

'

'

XY XY

Y Y

X X

S c c S

S c S

S c S

O y c y

O x c x

+

+

8/25

3.5. Valor de la Covarianza en caso de Independencia Estadstica.

Segn hemos visto, la covarianza se poda expresar como

01 10 11 11

XY

S

La condicin de independencia estadstica era j i

N

n

N

n

N

n

j

i

ij

,

Calculemos, segn esta condicin, el valor de

11

01 10

1 1

1 1

1 1

1 1

11

m

i

n

j

j

j

i

i

m

i

n

j

j

i

j i

m

i

n

j

ij

j i

N

n

y

N

n

x

N

n

N

n

y x

N

n

y x

Luego, cuando las variables son independientes, la covarianza es nula.

En cambio el recproco no tiene por qu ser cierto.

4. AJUSTE.

Sea (x

i

,y

j

,n

ij

) una distribucin bidimensional en la que suponemos que existe

relacin entre las variables aleatorias X e Y. Si representamos en un sistema de ejes

coordenados los pares de valores de ambas variables, el problema del ajuste consiste en

obtener la ecuacin de una curva que pase cerca de los puntos y se adapte lo mejor

posible a los mismos, cumpliendo unas determinadas condiciones.

Cuando pretendemos realizar un ajuste nos encontramos con dos problemas:

1) Elegir el mejor tipo de curva que se adapte a los datos disponibles, es decir,

aquella que mejor represente la relacin existente entre X e Y. Es importante,

slo a modo de orientacin, ver la representacin grfica de los puntos.

2) Fijado el tipo de curva a travs de su ecuacin en forma explcita con un cierto

nmero de parmetro, determinar stos mediante las condiciones que se

impongan segn el procedimiento de ajuste planteado.

4.1. Mtodos de los Mnimos Cuadrados.

Dados los puntos (x

1

,y

1

), (x

2

,y

2

), ..., (x

m

,y

m

), podemos elegir una funcin de ajuste

definida por:

y = f(x,a

1

,a

2

,...,a

n

)

en la que intervienen n parmetros (a

1

,a

2

,...,a

n

) con n<m.

Para cada valor x

i

de la variable X, tenemos dos valores para Y:

1) El valor, y

j

, observado en la propia distribucin.

2) El valor, que denotaremos por y

j

*

, que se obtiene de sustituir x por x

i

en la

funcin f.

9/25

Para cada trmino x

i

, existe una diferencia entre el valor observado en la

distribucin y el obtenido en forma terica, que llamaremos Residuo.

e

j

= y

j

y

j

*

El mtodo de mnimos cuadrados consiste en determinar los parmetros a

1

,a

2

,...,a

n

de tal forma que los residuos sean mnimos.

Si tomamos la suma de todos los residuos

( )

i j

ij j j

n y y

*

nos encontramos con dos problemas a la hora de minimizar la expresin. El primero es

que tenemos residuos de diferente signo, los cuales se compensarn en la suma,

pudiendo dar una suma muy pequea para residuos muy grandes. El segundo problema

es que la determinacin de los parmetros no es nica, ya que obtendramos diferentes

conjuntos de parmetros que arrojaran la misma suma mnima de los residuos.

Para solucionar estos problemas siguiendo con el mtodo de mnimos cuadrados, lo

que vamos a hacer es tratar de minimizar la expresin:

( )

i j

ij j j

n y y

2

*

Como los valores tericos son los obtenidos a partir de la curva ajustada, tenemos

que la expresin a minimizar se queda como:

( )

i j

ij n i j

n a a a x f y

2

2 1

) , , , , ( K

para lo cual, la condicin necesaria es que las primeras derivadas parciales respecto a

cada uno de los parmetros se anulen.

El sistema que se obtiene recibe el nombre de Sistema de Ecuaciones Normales.

10/25

[ ]

[ ]

[ ]

'

0 ) ( ) , , , ; ( 2

0 ) ( ) , , , ; ( 2

0 ) ( ) , , , ; ( 2

'

2 1

'

2 1

2

'

2 1

1

2

1

i j

a ij n i j

n

i j

a ij n i j

i j

a ij n i j

n

f n a a a x f y

a

f n a a a x f y

a

f n a a a x f y

a

K

L

K

K

Resolviendo este sistema determinamos los valores de los parmetros, as como la

propia funcin f.

A continuacin vamos a utilizar el mtodo descrito para ajustar algunas funciones

que corrientemente se suelen presentar.

4.1.1. Ajuste de una Recta.

Dada una nube de puntos, vamos a tratar de ajustarla mediante una recta de ecuacin

i j

bx a y +

*

Para determinar los coeficientes a y b buscaremos el mnimo de la funcin:

( ) ( ) ( )

+

i j

ij i j

i j

ij i j

i j

ij j j

n bx a y n bx a y n y y

2 2

2

*

) (

para lo cual, obtendremos las derivadas parciales de la funcin con respecto a los

parmetros. Al igualar a cero ambas expresiones, resolvemos el sistema de dos

ecuaciones que aparece.

( )

( )

'

0 ) ( 2

0 ) 1 ( 2

i j

ij i i j

i j

ij i j

n x bx a y

b

n bx a y

a

Dividiendo ambos miembros por 2, nos queda:

( )

( )

'

0 ) (

0

i j

ij i i j

i j

ij i j

n x bx a y

n bx a y

Operando y cambiando trminos de un miembro a otro:

11/25

'

+

+

i j

ij i

i j

ij i

i j

ij i j

i j

ij i

i j

ij

i j

ij j

n x b n x a n x y

n x b n a n y

2

Podemos resumir la expresin anterior en:

'

+

+

i

i i

i j

ij i

i j

ij i j

i

i i

j

j j

n x b n x a n x y

n x b aN n y

2

Ahora ya estamos en condiciones de resolver el sistema, llamado Sistema de

Ecuaciones Normales.

2

X

XY

S

S

b x b y a

4.1.2. Ajuste de una Parbola.

En este caso, la curva seleccionada para ajustarse a la nube de puntos es

2 *

i i j

cx bx a y + +

y para hallar los parmetros a, b y c debemos minimizar la funcin

( )

i j

ij i i j

n cx bx a y

2

2

Las primeras derivadas parciales de la funcin con respecto a cada uno de los

parmetros nos determinan el sistema siguiente:

( )

( )

( )

'

0 ) ( 2

0 ) ( 2

0 ) 1 ( 2

2 2

2

2

i j

ij i i i j

i j

ij i i i j

i j

ij i i j

n x cx bx a y

c

n x cx bx a y

b

n cx bx a y

a

Realizando las mismas operaciones que en el caso anterior para la recta, el sistema

se transforma en

'

+ +

+ +

+ +

i

i

i

i

i

i

i j

ij j

i

i

i

i

i

i i

i j

ij j i

i

i

i

i i

j

j j

n x c n x b n x a n y x

n x c n x b n x a n y x

n x c n x b aN n y

i i

i

i

i i

i

2 2

2

12/25

de cuya resolucin se obtiene los valores numricos de los parmetros de la mejor

parbola de segundo grado en el sentido mnimo cuadrtico para la nube de puntos

dada.

4.1.3. Ajuste Hiperblico.

Son funciones de la forma:

x

b y b yx

1

siendo b una constante cualquiera. Tambin se puede considerar la funcin anterior pero

desplazada una cierta cantidad a:

x

b a y

1

+

El ajuste por mnimos cuadrados lo podemos reducir al caso de la recta, ya visto

anteriormente, sin ms que efectuar la transformacin

x

z

1

con lo que la funcin se convierte en y = a+bz

4.1.4. Ajuste Potencial.

La forma general de la funcin potencial es

b

x a y

que de forma anloga al anterior, lo podemos reducir al caso de una recta simplemente

tomando logaritmos en ambos miembros.

x b a y log log log +

' ' ' bx a y +

4.1.5. Ajuste Exponencial.

La ecuacin general es

x

b a y

y repitiendo el caso anterior, al tomar logaritmos se nos reduce al caso de una funcin

lineal.

b x a y log log log +

13/25

4.2. Mtodo de los Momentos.

El Mtodo de los Momentos se basa en el hecho conocido de que dos distribuciones

son tanto ms parecidas cuanto mayor cantidad de momentos iguales tengan.

Dada la distribucin bidimensional (x

i

,y

i

) dada por un nmero N de puntos,

recordemos que nuestro objetivo era encontrar una cierta funcin y*=f(x,a

0

,...,a

n

) que se

ajuste lo ms posible a la nube de puntos obtenida.

Para hallar la funcin, bastar basarnos en la propiedad que hemos enunciado, para

lo cual, slo tendremos que igualar los n+1 primeros momentos obtenidos de la

distribucin observada con sus correspondientes de la distribucin terica.

Teniendo en cuenta que los momentos respecto al origen de la distribucin

observada vienen dados por la expresin:

N

i

s

i

r

i rs

y x

N

1

1

que para el valor s=1 se convierte en:

N

i

i

r

i r

y x

N

1

1

1

r:0,1,2,...

De forma anloga, los momentos correspondientes a la distribucin terica

obtenidos a partir de la funcin seran:

N

i

i

r

i r

y x

N

1

*

1

1

r:0,1,2,...

donde, recordemos, y

i

*=f(x

i

,a

0

,...,a

n

)

Igualando los n+1 primeros momentos, obtenemos el sistema de ecuaciones:

'

N

i

i

n

i

N

i

i

n

i

N

i

i i

N

i

i i

N

i

i

N

i

i

y x y x

y x y x

y y

1

*

1

1

*

1

1

*

1

L

Tenemos as un sistema de n+1 ecuaciones que nos permite calcular el valor de los

n+1 parmetros que determinan la funcin y

i

*=f(x

i

,a

0

,...,a

n

)

Si esta funcin fuera un polinomio de grado k, el sistema que se obtiene es el

Sistema de Ecuaciones Normales obtenido por el mtodo de Mnimos Cuadrados

cuando la funcin a ajustar es un polinomio de grado k.

14/25

5. REGRESIN.

La Regresin tiene por objeto la determinacin de una cierta estructura de

dependencia que mejor exprese el tipo de relacin de la variable Y con las dems. Es

decir, trata de poner de manifiesto, a partir de la informacin disponible, la estructura de

dependencia que mejor explique el comportamiento de la variable Y (variable

dependiente) a travs de todo el conjunto de variables X

1

, X

2

, ..., X

k

(variables

independientes) con las que se supone que est relacionada.

En este tema slo vamos a tratar el caso de disponer de una variable independiente,

ya que estamos estudiando distribuciones bidimensionales.

Sean pues, X e Y dos variables cuya distribucin conjunta de frecuencias es

(x

i

,y

j

,n

ij

)

DEF Llamaremos Regresin de Y sobre X a la funcin que explica la variable Y para

cada valor de X.

DEF Llamaremos Regresin de X sobre Y a la funcin que explica la variable X para

cada valor de Y.

5.1. Regresin Lineal.

La regresin ser lineal cuando la curva de regresin, obtenida o seleccionada, sea

una recta. Desarrollaremos este caso particular por ser el ms empleado.

5.1.1. Recta de Regresin de Y sobre X.

Haciendo uso de la tcnica de mnimos cuadrados para el ajuste de una recta,

debamos hacer mnima la funcin:

( )

i j

ij i j

n bx a y

2

llegando al sistema de ecuaciones normales

'

+

+

i

i i

i j

ij i

i j

ij i j

i

i i

j

j j

n x b n x a n x y

n x b aN n y

2

Dividiendo ambas ecuaciones por N, expresamos el sistema en funcin de los

momentos respecto al origen:

'

+

+

20 10 11

10 01

b a

b a

15/25

Para resolver el sistema, multiplicamos la primera ecuacin por

10

y sumamos

ambas, quedando:

2

20

11

2

10 20

01 10 11

X

XY

S

S

b

Despejando a en la primera ecuacin y sustituyendo el valor de b obtenido

x

S

S

y

S

S

a

X

XY

X

XY

2

10

2

01

Por tanto, la recta de regresin de Y sobre X, en funcin de los momentos quedar:

x

S

S

x

S

S

y y

X

XY

X

XY

2 2

+

Y reordenando los trminos obtenemos:

) (

2

x x

S

S

y y

X

XY

5.1.2. Recta de Regresin de X sobre Y.

Partiendo de la funcin

( )

i j

ij j i

n by a x

2

y realizando un desarrollo anlogo al del apartado anterior, llegamos a que la recta de

regresin de X sobre Y ser:

) (

2

y y

S

S

x x

Y

XY

DEF Llamaremos Centro de Gravedad de la distribucin conjunto de X e Y al punto

( ) y x, , lugar donde se cortan ambas rectas de regresin.

5.2. Coeficientes de Regresin.

Los coeficientes de regresin lineal son las pendientes de las rectas de regresin.

As, el coeficiente de regresin de Y sobre X ser

2

X

XY

S

S

b

pero

16/25

x

y

b

tg

luego el coeficiente de regresin de Y sobre X nos mide la tasa de incremento de Y para

variaciones de X. Es decir, b indica la variacin de la variable Y para un incremento

unitario de la variable X.

De forma anloga, el coeficiente de regresin de X sobre Y ser

2

Y

XY

S

S

b

y como

x

y

b

' tg '

b nos indicar la variacin de X correspondiente a un incremento unitario de Y.

Tanto el signo de b como de b ser el signo de la covarianza. Una covarianza

positiva nos dar dos coeficientes de regresin positivos y sus correspondientes rectas

de regresin crecientes. Si la covarianza es negativa, las dos rectas de regresin sern

decrecientes al serlo sus pendientes. En caso de que la covarianza sea cero, las

pendientes sern nulas y por tanto las rectas sern paralelas a los ejes coordenados y

perpendiculares entre s.

6. CORRELACIN.

DEF Llamamos Correlacin al grado de dependencia mutua entre las variables de una

distribucin.

El problema que se nos plantea es como medir la intensidad con que dos variables

de una distribucin bidimensional estn relacionadas.

Recordemos que a travs de la curva de regresin expresbamos la estructura de la

relacin existente entre las variables, y que para cada valor de x

i

obtenamos una

diferencia, llamada residuo, entre el valor de Y en la nube de puntos y el

correspondiente valor terico obtenido en la funcin.

Si todos los puntos de la nube estuvieran en la funcin, obtendramos dependencia

funcional, siendo el grado de dependencia entre las variables el mximo posible. Cuanto

ms se alejen los puntos de la funcin (mayor sean los residuos) menor ser la relacin

entre ambas. Es por ello que para estudiar la dependencia entre las variables vamos a

hacer uso de los residuos.

DEF Llamaremos Varianza Residual a la media de todos los residuos elevados al

cuadrado.

( ) ( )

j

j

j j

i j

ij

j j rY

N

n

y y

N

n

y y S

2

*

2

* 2

17/25

Si la varianza residual es grande, entonces los residuos, por trmino medio, sern

grandes, lo que significa que los puntos estarn muy separados de la funcin, siendo

pequea la dependencia entre las variables. Razonando igual, si la varianza es pequea,

la relacin ser grande.

Para que la relacin entre la dependencia de las variables y la medida utilizada sea

directa (en lugar de inversa como ocurre con la varianza residual), definimos el

siguiente coeficiente.

DEF Llamamos Coeficiente de Correlacin General de Pearson a

2

2

1

Y

rY

S

S

R

DEF Llamamos Coeficiente de determinacin al cuadrado del coeficiente de

correlacin, R

2

.

6.1. Campo de Variacin de R y su Interpretacin.

Despejando la varianza residual del coeficiente de correlacin R, tenemos

) 1 (

2 2 2

R S S

Y rY

Dado que la varianza marginal de Y y la varianza residual son sumas de sumandos

no negativos, ambas sern no negativas, de lo cual deducimos que

0 1

2

R

y de aqu obtenemos

1 1 R

Por tanto, el rango de valores de R es el intervalo cerrado [-1,1]

Analicemos ahora, en funcin de los valores de este coeficiente, que dependencia

existe entre las variables.

1) R=1 0

2

rY

S .

Todos los valores tericos coinciden con los obtenidos de la observacin y, por

tanto, la dependencia es funcional. Diremos que existe Correlacin Positiva Perfecta,

indicando con Perfecta que ambas variables varan en el mismo sentido.

2) 1 R 0

2

rY

S .

En este caso, la dependencia tambin es funcional pero ambas variables varan en

sentidos opuestos. Decimos que existe Correlacin Negativa Perfecta.

18/25

3) R=0

2 2

Y rY

S S

No existe ninguna relacin entre la variable Y y la variable X, lo cual significa que

no estn asociadas. Diremos entonces que la Correlacin en Nula.

4) 1<R<0.

La Correlacin es Negativa, siendo ms fuerte conforme ms cerca est de 1.

5) 0<R<1.

La Correlacin es Positiva, y cuanto ms prxima est a uno, ms dependencia

existir entre las variables.

6.2. Coeficiente de Correlacin Lineal.

Sabemos que la varianza residual es

( )

i j

ij

j j rY

N

n

y y S

2

* 2

y que los valores tericos de la distribucin son

) (

2

*

x x

S

S

y y

i

X

XY

j

+

Sustituyendo esta expresin en la varianza residual tenemos:

( )

,

`

.

|

,

`

.

|

+

i j

ij

i

X

XY

j

i j

ij

j j rY

N

n

x x

S

S

y y

N

n

y y S

2

2

2

* 2

) (

( ) ( ) ( ) +

,

`

.

|

i j

ij

i

X

XY

i j

ij

j

i j

ij

i

X

XY

j

N

n

x x

S

S

N

n

y y

N

n

x x

S

S

y y

2

2

2

2

2

) (

( ) ( )

( )

2

2

2

2

2

2

2

2

2

2

2 2

X

Y XY

X

XY

X

X

i j

Y

ij

i j

X

XY

S

S

S S

S

S

S

S

S

S

N

n

x x y y

S

S

XY XY

+

DEF Llamamos Coeficiente de Correlacin Lineal, al coeficiente de correlacin

general aplicado al caso de una funcin lineal. Se denota por r y es

Y X

XY

Y X

XY

Y

X

XY

Y

Y

rY

S S

S

S S

S

S

S

S

S

S

S

r

2 2

2

2

2

2

2

2

2

1 1

19/25

Y el Coeficiente de Determinacin Lineal es

2 2

2

2

Y X

XY

S S

S

r

Ya hemos visto en el apartado anterior que 1 1 r y la interpretacin dada para

R tambin nos sirve para r.

6.3. Interpretacin Analtica de r.

Teniendo en cuenta las rectas de regresin de Y sobre X y de X sobre Y y el

coeficiente de correlacin lineal, podemos expresar las rectas de la siguiente forma:

'

) (

) (

y y

S

S

r x x

x x

S

S

r y y

Y

X

X

Y

Consideremos ahora los siguientes casos:

1) Si r=1.

La varianza residual es cero y los valores tericos coinciden con los observados. Por

tanto, todos los puntos de la nube estn en la recta. La correlacin lineal es perfecta

positiva y las rectas de regresin coinciden, ya que al sustituir r por 1 en la expresin

anterior, obtenemos la misma recta. En este caso, la dependencia funcional existente

viene reflejada por una recta creciente , al ser la pendiente positiva.

2) Si r = 1.

La correlacin es perfecta negativa. En este caso las rectas tambin coinciden, pero

la recta es decreciente al ser la pendiente negativa.

3) Si r=0

La correlacin es nula y las dos rectas son

0

0

x x

y y

las cuales son dos rectas paralelas a cada uno de los ejes y por tanto, perpendiculares

entre s.

20/25

4) Si 1<r<0.

La correlacin es negativa y las rectas de regresin, las cuales ahora son diferentes,

sern las dos decrecientes ya que el signo de las pendientes es el mismo que el de la

covarianza, que es la que da el signo a r.

5) Si 0<r<1

La correlacin es positiva, siendo las dos rectas de regresin crecientes.

6.4. Interpretacin Geomtrica de r.

Partiendo de las rectas de regresin de Y sobre X y de X sobre Y, si las

representamos tenemos

Sabemos que

2

2

'

Y

XY

X

XY

S

S

b

S

S

b

multiplicando miembro a miembro obtenemos

2

2 2

2

2 2

' r

S S

S

S

S

S

S

b b

Y X

XY

Y

XY

X

XY

Es decir

' b b r

el coeficiente de correlacin lineal es la media geomtrica de los coeficientes de

regresin lineales.

21/25

Por otra parte tenemos que

,

`

.

|

,

`

.

|

'

2

tg

1

'

2

tg ' tg '

tg

c b

b

Por lo cual, el coeficiente de correlacin lineal se puede expresar como

,

`

.

|

'

2

tg

tg

'

b b r

1) Si r=t1

Tenemos que ambas tangentes son iguales lo cual implica que '

2

, lo que

geomtricamente significa que las dos rectas coinciden, como se puede ver en la grfica

anterior.

2) Si r=0

Entonces tenemos que se debe verificar una de las dos expresiones siguientes:

0 '

0

'

2

tg

0 tg

'

,

`

.

|

luego las dos rectas son dos paralelas a cada uno de los ejes.

Como conclusin, podemos decir que r es un coeficiente tal que cuando es igual a

+1 o 1, el ngulo entre rectas es de cero grados, ya que coinciden. Cuando r es cero, el

ngulo formado es de 90. De aqu deducimos que cuando ms se acerque r al valor +1

o 1 mas pequeo ser el ngulo entre rectas. Por tanto, r tambin mide la apertura

existente entre las rectas de regresin.

7. VARIANZA DEBIDA A LA REGRESIN Y COEFICIENTE DE

DETERMINACIN LINEAL.

El intento de explicar una variable en funcin de la otra viene motivado por el

supuesto, el cual hemos de comprobar, de que la informacin que suministra una

variable sobre la que se regresa va a mejorar el conocimiento del comportamiento de

la otra variable. Es decir, se supone que en el caso de la regresin de Y sobre X, Y se

explica mejor a travs de X que con la distribucin marginal de Y.

Para ver en que medida la mejora de la descripcin de una variable a travs de la

otra tiene lugar, vamos a definir primero el concepto de Varianza Debida a la Regresin.

Para ello, hemos de considerar las tres variables que se obtienen en la regresin.

22/25

y

j

, que representa los valores observados de la variable Y.

y

j

* que representa los valores tericos asignados a x

i

en la regresin de Y sobre

X.

e

j

que son los residuos o errores que se generan en la regresin mnimo-

cuadrtica.

Los valores medios de estas tres variables son

1) La media de la serie observada de Y

i j

ij

j

N

n

y y

2) La media de los valores tericos.

y

N

n

y y

i j

ij

j

L

*

*

3) La media de los residuos en la regresin lineal de Y sobre X

0

L

i j

ij

j

N

n

e e

Teniendo en cuenta estos resultados, podemos definir las siguientes varianzas:

DEF Llamamos Varianza Total de los valores observados a ( )

i j

ij

j Y

N

n

y y S

2

2

DEF Llamamos Varianza de los Errores o Residuos a

( )

i j

ij

j e

N

n

e e S

2

2

Si tenemos en cuenta que la media de los residuos tiene valor nulo, al desarrollar la

expresin anterior llegamos a que

2 2

rY e

S S

que es la llamada varianza residual.

DEF Llamamos Varianza Debida a la Regresin, a la varianza de los valores tericos.

( ) ( )

i j

ij

j

i j

ij

j R

N

n

y y

N

n

y y S

2

*

2

* 2

*

23/25

En la regresin lineal, podemos encontrar una relacin entre las tres varianzas

anteriores, la cual pasamos a obtener. Para ello tendremos en cuenta que la regresin es

lineal.

( )

,

`

.

|

+

i j

ij

i

X

XY

i j

ij

j R

N

n

y x x

S

S

y

N

n

y y S

2

2

2

* 2

) (

( )

( )

( )

2 2

2

2

2

2

2

2

2

2

2

2

Y

X

i j

ij

i

X

S r

S

S

S

S

S

N

n

x x

S

S

X

XY

X

XY XY

Por otra parte, la varianza residual ser

2 2 2 2 2 2

) 1 (

Y Y Y rY

S r S r S S

Luego tenemos que

2 2 2

2 2 2

rY R Y

R Y rY

S S S

S S S

+

Dividiendo ambas ecuaciones miembro a miembro

2

2

2

2

1

Y

rY

Y

R

S

S

S

S

+

El primer sumando del segundo miembro nos indica la parte de la variacin de Y

que es explicada por la recta de regresin. El segundo sumando indica la parte no

explicada por la recta, la que escapa de sta o variacin residual.

De la expresin anterior tenemos

2

2

2

2

2

1 r

S

S

S

S

Y

rY

Y

R

El coeficiente de determinacin lineal r

2

nos medir el grado de acierto de la

utilizacin de la regresin. O lo que es lo mismo, r

2

nos dar el porcentaje de

variabilidad de Y que queda explicada por la regresin. La introduccin de r, coeficiente

de correlacin lineal, se justifica con el fin de aadir a r

2

el carcter de la asociacin

(positiva o negativa).

Teniendo en cuenta la expresin anterior, si r

2

= 1, es decir, si la correlacin es

perfecta:

2 2

2

2

2

1

Y R

Y

R

S S

S

S

r

24/25

lo que implica que la varianza residual

2

rY

S es nula, luego se ha mejorado al mximo la

descripcin de Y mediante la utilizacin de la informacin suministrada por X. Toda la

variabilidad marginal de Y est contenida en la regresin.

Si r=0, caso de correlacin nula

2 2 2

2

2

2

0 0

Y rY R

Y

R

S S S

S

S

r

es decir, en este caso X no nos sirve para ampliar la descripcin del comportamiento de

la variable Y.

8. APLICACIONES DE LA REGRESIN Y LA CORRELACIN.

8.1. Uso y Abuso de la Regresin.

La aplicacin de los mtodos expuestos de regresin y correlacin exige un anlisis

terico previo de las posibles relaciones entre las variables. Puede ocurrir que se

seleccionen dos variables cualesquiera al azar y que d la casualidad de que,

estadsticamente, la correlacin sea perfecta cuando no existe relacin posible entre

ellas.

Por ejemplo, el hecho de que, casualmente, la correlacin lineal entre la tasa de

natalidad en Nueva Zelanda y la produccin de cereales en Espaa a lo largo de un

determinado periodo fuera perfecta no nos debera llevar a suponer que existe algn tipo

de relacin lineal entre estas variables.

Se deben seleccionar variables entre las que la fundamentacin terica avale algn

tipo de relacin, evitando, en lo posible, relaciones a travs de otra variable principal..

Por ejemplo, el consumo de bebidas puede variar en la misma direccin que el consumo

de gasolina, pero no porque una variable dependa directamente de la otra, sino porque

ambas van en el mismo sentido que las variaciones de la renta, que ser la principal

variable explicativa.

8.2. Prediccin.

El objetivo ltimo de la regresin es la prediccin o pronstico sobre el

comportamiento de una variable para un valor determinado de la otra. As, dada la recta

de regresin de Y sobre X, para un valor X=x

0

de la variable, obtenemos y

0

Es claro que la fiabilidad de esta prediccin ser tanto mayor, en principio, cuanto

mejor sea la correlacin entre las variables. Por tanto, una medida aproximada de la

bondad de la prediccin podra venir dada por r.

25/25

BIBLIOGRAFA RECOMENDADA.

Introduccin a la Teora de la Estadstica. Aut.: Mood/Graybill. Ed. Aguilar.

Introduccin a la Probabilidad y la Medida. Aut. Procopio Zoroa. Ed. PPU

Algoritmo. Matemticas II. Cou. Aut.: Vizmanos y Anzola. Edit. SM.

Estadstica Terica y Aplicada. Aut.: A. Vortes. Edit.: PPU

Teora de Probabilidades y Aplicaciones. Aut.: Cramer. Edit.: Aguilar.

Вам также может понравиться

- Factores de Riesgo Del Abandono Escolar Desde La Perspectiva Del Profesorado de Educación Secundaria Obligatoria en Andalucía (España)Документ20 страницFactores de Riesgo Del Abandono Escolar Desde La Perspectiva Del Profesorado de Educación Secundaria Obligatoria en Andalucía (España)kudasai_sugoiОценок пока нет

- 2010 Matematicas 71 13Документ24 страницы2010 Matematicas 71 13kudasai_sugoi100% (1)

- 2010 Matematicas 51 13Документ36 страниц2010 Matematicas 51 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 50 13Документ36 страниц2010 Matematicas 50 13kudasai_sugoi100% (1)

- 2010 Matematicas 54 13 PDFДокумент32 страницы2010 Matematicas 54 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 68 13Документ24 страницы2010 Matematicas 68 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 70 13Документ26 страниц2010 Matematicas 70 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 53 13Документ34 страницы2010 Matematicas 53 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 58 13 PDFДокумент26 страниц2010 Matematicas 58 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 52 13Документ26 страниц2010 Matematicas 52 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 60 13 PDFДокумент30 страниц2010 Matematicas 60 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 57 13 PDFДокумент22 страницы2010 Matematicas 57 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 69 13Документ28 страниц2010 Matematicas 69 13kudasai_sugoi100% (1)

- 2010 Matematicas 66 13Документ30 страниц2010 Matematicas 66 13kudasai_sugoi100% (1)

- 2010 Matematicas 62 13Документ36 страниц2010 Matematicas 62 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 64 13Документ20 страниц2010 Matematicas 64 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 65 13Документ26 страниц2010 Matematicas 65 13kudasai_sugoi100% (1)

- 2010 Matematicas 55 13 PDFДокумент28 страниц2010 Matematicas 55 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 56 13 PDFДокумент22 страницы2010 Matematicas 56 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 61 13 PDFДокумент18 страниц2010 Matematicas 61 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 63 13Документ16 страниц2010 Matematicas 63 13kudasai_sugoi100% (1)

- 2010 Matematicas 59 13 PDFДокумент24 страницы2010 Matematicas 59 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 57 13 PDFДокумент22 страницы2010 Matematicas 57 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 56 13 PDFДокумент22 страницы2010 Matematicas 56 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 60 13 PDFДокумент30 страниц2010 Matematicas 60 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 61 13 PDFДокумент18 страниц2010 Matematicas 61 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 28 13Документ44 страницы2010 Matematicas 28 13kudasai_sugoiОценок пока нет

- 2010 Matematicas 59 13 PDFДокумент24 страницы2010 Matematicas 59 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 55 13 PDFДокумент28 страниц2010 Matematicas 55 13 PDFkudasai_sugoiОценок пока нет

- 2010 Matematicas 54 13 PDFДокумент32 страницы2010 Matematicas 54 13 PDFkudasai_sugoiОценок пока нет

- Tarea 2 Estadistica InvestigacionДокумент26 страницTarea 2 Estadistica InvestigacionRUTH ISABEL ROJAS CLEVELОценок пока нет

- Tarea 1ejercicios de Dispersión y CorrelaciónДокумент9 страницTarea 1ejercicios de Dispersión y CorrelaciónElizabeth Garrido VelizОценок пока нет

- TALLER Estadisticos Asociacion y Modelos de RegresionДокумент3 страницыTALLER Estadisticos Asociacion y Modelos de RegresionandresОценок пока нет

- Diagrama de DispersionДокумент15 страницDiagrama de Dispersionjoseph ayma cutiОценок пока нет

- Trabajo Final - MÉTODOS CUANTITATIVOS EN FINANZASДокумент9 страницTrabajo Final - MÉTODOS CUANTITATIVOS EN FINANZASAderly- Gestión de Microfinanzas cuellarОценок пока нет

- Examen Parcial de Estadistica para Economistas I - 2017 - Solucionario 2Документ4 страницыExamen Parcial de Estadistica para Economistas I - 2017 - Solucionario 2Willians S. Tame HuallpaОценок пока нет

- Caso - Diagrama de DispersiónДокумент16 страницCaso - Diagrama de DispersiónBrahyam Ludeña PañaoОценок пока нет

- 9-Distribucion de Probabilidad Conjunta PDFДокумент13 страниц9-Distribucion de Probabilidad Conjunta PDFSumate Por CentroОценок пока нет

- Actividad 7 Estadistica Descriptiva PDFДокумент9 страницActividad 7 Estadistica Descriptiva PDFMaria FlorezОценок пока нет

- TISE 2019 Paper 83Документ7 страницTISE 2019 Paper 83DiegoОценок пока нет

- Ajuste Por Cuadrados MínimosДокумент7 страницAjuste Por Cuadrados MínimosyesicatrrsОценок пока нет

- Fórmulas de Análisis de Correlacion PDFДокумент2 страницыFórmulas de Análisis de Correlacion PDFLeyla Lizet Sandoval BarretoОценок пока нет

- Coeficiente de Correlación de PearsonДокумент2 страницыCoeficiente de Correlación de PearsonveronicaОценок пока нет

- Caso#1 Superfast Market Estadística para La AdministraciónДокумент20 страницCaso#1 Superfast Market Estadística para La Administraciónguasec1Оценок пока нет

- Matriz de ConsistenciaДокумент5 страницMatriz de ConsistenciaYuryPaniaguaОценок пока нет

- 01 Practica Correlacion y RegresionДокумент2 страницы01 Practica Correlacion y RegresionCarlos Ramos BenitesОценок пока нет

- Analisis de Correlacion y DeterminacionДокумент42 страницыAnalisis de Correlacion y DeterminacionMireya HuanquiОценок пока нет

- Regresión Simple y MúltipleДокумент15 страницRegresión Simple y MúltipleelfeebleОценок пока нет

- Estadística BidimensionalДокумент10 страницEstadística BidimensionalJosé Marín GarcíaОценок пока нет

- Regresion LinealДокумент14 страницRegresion LinealJonathan Suarez MontoyaОценок пока нет

- Estadistica Aplicada 8a Semana Correlación y RegresiónДокумент21 страницаEstadistica Aplicada 8a Semana Correlación y Regresiónrcuc5882Оценок пока нет

- Calculo de Probabilidad de Falla en Taludes MinerosДокумент9 страницCalculo de Probabilidad de Falla en Taludes Minerosalarcon_figmm100% (1)

- UNIDAD 5 Probabilidad y EstadisticaДокумент6 страницUNIDAD 5 Probabilidad y EstadisticaJoseEduardoCarrilloPacheco100% (1)

- Alvarez - Morales - Taller - 8 PH 2 PobДокумент4 страницыAlvarez - Morales - Taller - 8 PH 2 PobGloria MoralesОценок пока нет

- Tema 15 Regresion LinealДокумент18 страницTema 15 Regresion LinealKevin Carlos100% (1)

- Estudio de Mercado InversiónДокумент89 страницEstudio de Mercado InversiónJosé Castillo100% (1)

- Informe de EstadísticaДокумент7 страницInforme de EstadísticaFernando Esqueda100% (5)

- Diagramas de Dispersión .... - .Документ25 страницDiagramas de Dispersión .... - .Marlon Socell Figueroa AyalaОценок пока нет

- Sesión #3 PDFДокумент32 страницыSesión #3 PDFAlejandra Gomez OrtegaОценок пока нет

- Trading Cuantitativo SP 500 Estrategia - En.españolДокумент18 страницTrading Cuantitativo SP 500 Estrategia - En.españoljeffersonОценок пока нет