Академический Документы

Профессиональный Документы

Культура Документы

Cadeias Markov14

Загружено:

ptscribОригинальное название

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Cadeias Markov14

Загружено:

ptscribАвторское право:

Доступные форматы

Rafael A.

Rosales

Processos Estoc

asticos

Notas de Aula

7 de dezembro de 2009

Matematica Aplicada `a Negocios

Faculdade de Filosoa Ciencias e Letras de Ribeirao Preto

Conte udo

1 Introducao. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

2 Tempo discreto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2.1 Cadeias de Markov . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2.1.1 Propriedade de Markov . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.1.2 Probabilidades de n passos . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

2.1.3 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

2.2 Classes de comunicacao . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

2.3 Tempos do primeiro retorno e da primeira chegada . . . . . . . . . . . . . . . . . . . . . . 12

2.3.1 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

2.4 Propriedade forte de Markov . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

2.5 Recorrencia e transitoriedade . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

2.5.1 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

2.5.2 Passeios aleatorios simples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

2.5.3 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.6 Distribuicao invariante . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.6.1 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

2.7 Convergencia ao equilbrio . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

2.7.1 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 43

2.8 Teorema ergodico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

2.8.1 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

2.9 Aplicacoes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

2.9.1 Processos de ramicacao

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

2.9.2 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

3 Tempo contnuo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

3.1 Processos a tempo contnuo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

3.2 Matriz Q . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

3.3 Propriedades da distribuicao exponencial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 57

3.4 Processo de Poisson. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60

3.4.1 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

3.5 Processos de Markov . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

3.5.1 Cadeia de transi cao e tempos de permanencia . . . . . . . . . . . . . . . . . . . . . 65

3.5.2 Equacoes de Forward e Backward . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 67

3.5.3 Exerccios . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

3.6 Estrutura de classe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

VI Conte udo

3.7 Tempos da primeira chegada e probabilidades de absorcao . . . . . . . . . . . . . . . . 69

3.8 Recorrencia e transitoriedade . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

3.9 Distribuicao invariante . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 71

3.10 Convergencia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 72

3.11 Teorema Ergodico . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 73

4 Apendice . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 75

4.1 Relacoes de Recorrencia . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 75

4.1.1 Forma matricial . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

4.2 Funcoes geradoras . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 80

Referencias Bibliogracas . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 81

Indice . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 83

Prefacio

As seguintes notas constituem um curso elementar sobre processos aleatorios. O curso e

elementar pois evita utilizar a teoria da medida e por outro lado considera os topicos mais

simples que geralmente sao apresentados em um curso introdutorio. Uma excelente alterna-

tiva a estas notas esta constituida pela referencia [4]. Esta utima esta baseada no ponto de

vista construtivista, o qual descansa sobre as nocoes de acoplamento e simulacao. A aborda-

gem adotada na apresentacao destas notas e tradicional, entretanto a demonstracao de um

dos Teoremas mais importantes utiliza o argumento de acoplamento. Seguindo o enfoque

tradicional, os processos a tempo continuo sao introduzidos construtivamente utilizando o

processo de Poisson. Finalmente, tambem e encorajada a simulacao de processos em varios

exerccios com o proposito de ganhar uma maior intuicao sobre os conceitos introduzidos na

teoria.

Nada nestas notas e original. A apresentacao segue de perto os livros de J. Norris, [7] e

Grimmett, Stirzacker, [5]. Em particular, a primeira parte dedicada ao estudo de processos

em tempo discreto, inclui boa parte dos captulos 1.1-1.10 de [7]. A segunda parte a qual

representa uma introducao aos processos a tempo contnuo esta inspirada nos captulos

2.1-3.8 em [7] e os captulos 6.8-6.12 em [5].

Supoe-se um conhecimento da teoria de probabilidade a nvel de graduacao assim como

conhecimentos basicos sobre equacoes diferenciais e em diferenca, e nalmente tambem

alguns rudimentos de algebra linear.

Estas notas foram preparadas para a materia titulada Introducao a Processos Es-

tocasticos, ministrada durante o segundo semestre do ano 2007 aos alunos do curso de

Matematica Aplicada a Negocios da USP.

1

Introducao

Um processo estocastico e uma seq uencia de variaveis aleatorias X = (X

t

), t T , onde

t usualmente representa o tempo. Neste caso conjunto dos ndices T e identicado com N

ou R

+

. A seq uencia (X

t

) geralmente e utilizada com o proposito de representar a evolucao

aleatoria de um fenomeno fsico. Neste curso so serao consideradas seq uencias de variaveis

aleatorias X

t

denidas sobre o mesmo espaco de probabilidade, todas com valores no con-

junto S o qual suporemos nito ou enumeravel. Seguindo a convencao usual utilizaremos a

nota cao t para os ndices contnuos e n para o caso discreto.

Ressaltamos que X

t

e realmente uma funcao X(, t) onde e um evento elementar

do espaco das trajetorias do processo. Ao considerar a seq uencia (X

t

) estamos portanto

considerando um espaco de funcoes aleatorias. A m de entender isto melhor, lembramos

algumas nocoes de teoria de probabilidade. Dado um espaco de probabilidade (, A, P),

uma variavel aleatoria e uma fun cao : (, A) (R, B), tal que

1

(B) = { : () B} A

para todo B B, onde B e a menor sigma algebra gerada pelos conjuntos abertos de R.

Seja agora

() =

1

(B) = {

1

(B) : B B} A,

a sigma algebra gerada pela variavel aleatoria , i.e. intuitivamente () denota a porcao da

informacao contida no espaco de probabilidade inerente a . A distribuicao de probabilidade,

P, de e denida como

P( B) = P{

1

(B)}.

Observamos que esta denicao permite determinar a probabilidade de qualquer evento asso-

ciado a , desde que esta inclui as probabilidades de todos os conjuntos

1

(B) = () A.

A m de generalizar estes conceitos para processo X, suponhamos que existe um espaco

de probabilidade (, A, P) tal que (X) A. Neste caso se X e um processo com ndices

discretos e valores em S temos que

X : (, A) (S

, (S

)),

sendo (S

) a sigma algebra gerada pelos conjuntos abertos de S. Se S = C, o espaco das

funcoes continuas em [0, ), entao X e um processo com trajetorias continuas.

A suposicao, nada trivial, de que os eventos denidos sobre os espaco dos caminhos de

um processo, , podem ser medidos por uma funcao de probabilidade P representa um dos

problemas mais fundamentais da teoria dos processos estocasticos. Durante o curso, nos

suporemos que isto e possvel e nao faremos mais referencia a este assunto. Os interessados

2 1 Introducao

nos detalhes podem consultar o apendice em [7] ou os textos mais avancados tais como [1],

e [8], procurando pelas secoes referentes aos -sistemas

1

. Estas referencias e todas as outras

mencionadas na bibliograa podem guiar o estudo posterior e mais profundo da teoria dos

processos estocasticos.

1

Estas classes de conjuntos tambem sao conhecidos em teoria de probabilidade como os sistemas

-, seguindo a nomenclatura introduzida por Eugene B. Dynkin. Dynkin realmente utilizou um

resultado ja estabelecido em um contexto mais geral conhecido como o Teorema de Classes de

W. Sierpi nski.

2

Tempo discreto

2.1 Cadeias de Markov

Para desenvolver a intuicao, o seguinte exemplo introduze de maneira informal a propriedade

que dene uma ampla variedade de processos conhecidos como cadeias de Markov.

Exemplo 2.1. Um sapo que habita num lago pode pular em procura de alimento entre nove

Vitorias regias dispostas de acordo ao seguinte desenho

v

1

v

2

v

3

v

4

..

v

5

v

6

v

7

v

8

v

9

No instante n = 0 o sapo encontra-se na planta v

1

de tal maneira que com probabilidade

p, 0 < p < 1, este pode pular a planta v

2

e com q = 1 p a planta v

9

. As mesmas regras

determinam os pulos a partir de v

i

para v

i+1

ou v

i1

, i = 1, . . . , 9 (se i = 9 entao i +1 = 1, e

se i = 1 entao i 1 = 9). Denotamos por X

n

{v

1

, v

2

, . . . , v

9

} a posicao do sapo no instante

n, n N. A seq uencia de variaveis aleatorias (X

n

), n 0, que correspondem as posicoes do

sapo formam um processo aleatorio. Temos portanto que

P(X

0

= v

1

) = 1,

P(X

1

= v

2

| X

0

= v

1

) = p, P(X

1

= v

9

| X

0

= v

1

) = q,

Utilizando probabilidade condicional podemos calcular a probabilidade de que o sapo se

encontre numa determinada planta apos de n 2 pulos, por exemplo,

P(X

n

= v

5

|X

n1

= v

4

, . . . , X

0

= v

1

) = P(X

n

= v

5

|X

n1

= v

4

) = p,

o qual e consequencia imediata das regras que determinam os movimentos do sapo. Em

particular esta equacao enfatiza o fato de que a distribuicao de X

n

dado (X

0

, . . ., X

n1

) so

depende de X

n1

. Esta unica simplicacao fornece a estrutura necessaria para desenvolver

a maior parte da teoria. Em particular, esta permite responder as seguintes perguntas.

(i) Qual a distribuicao de X

n

?, (ii) Qual a distribuicao do evento {X

n

| X

0

= v

1

}? De

maneira equivalente, no contexto deste exemplo, (iii) qual e a probabilidade de encontrar o

sapo na planta v

5

apos 37 pulos?, (iv) ou a probabilidade de que este esteja na planta v

3

4 2 Tempo discreto

apos de 5

3

pulos, dado que este inicio o seu trajeto na procura de alimento na planta v

1

?

As seguintes perguntas relacionadas sao geralmente tambem de interesse: (v) Sera possvel

calcular a distribuicao de X

n

no limite n ? (vi) Qual e o n umero esperado de pulos

realizados pelo sapo ate voltar pela primeira vez a planta v

1

? (vii) Se a planta v

6

e realmente

a cabeca de um jacare faminto, qual e o n umero de pulos em media realizados pelo sapo

antes de ser devorado pelo jacare?

2.1.1 Propriedade de Markov

Seja S um conjunto enumeravel. Um elemento i S e chamado de estado, e S o espaco de

estados. Seja = (

1

: i S) uma distribuicao de probabilidade em S, isto e,

0

i

1,

iS

i

= 1.

Denicao 2.1. A distribuicao inicial do processo X e a distribuicao

i

= P(X

0

= i) = P

_

{ : X

0

(w) = i}

_

, i S.

Denicao 2.2. Uma matriz P = (p

ij

: i, j S) e estocastica se cada linha (p

ij

: j S) e

uma distribuicao em S.

Um grafo e denido por dois conjuntos, um conjunto de vertices e outro de elos.

Denotamos por G = (E, V ) o grafo formado pelos elos E = {e

1

, e

2

, . . .} com vertices

V = {v

1

, v

2

, . . .}. Observamos que existe uma correspondencia um-a-um entre uma ma-

triz estocastica e um grafo G com vertices em S. Por exemplo, para S = {1, 2, 3}, podemos

considerar o par

P =

_

_

b a c

a c b

c b a

_

_

v

1

p

a

a

c

c

v

2

o

b

b

c

ww

v

3

a

onde a > 0, b > 0, e c > 0, sao constantes tais que a +b +c = 1. Para o exemplo 2.1, onde

S = {v

1

, v

2

, . . . , v

9

}, temos

P =

_

_

0 p 0 0 0 0 0 0 q

q 0 p 0 0 0 0 0 0

0 q 0 p 0 0 0 0 0

0 0 q 0 p 0 0 0 0

0 0 0 q 0 p 0 0 0

0 0 0 0 q 0 p 0 0

0 0 0 0 0 q 0 p 0

0 0 0 0 0 0 q 0 p

p 0 0 0 0 0 0 q 0

_

_

v

1

v

2

q

p

v

3

q

p

v

4

q

p

.

.

.

v

5

q

p

v

6

q

p

v

7

q

p

v

8

q

p

v

9

q

p

q

p

A continuacao denimos formalmente um processo conhecido como cadeia de Markov. O

resto da secao esta dedicado a mostrar que a estrutura basica deste processo e determinada

em sua totalidade por P e .

Denicao 2.3 (cadeia de Markov). X = (X

n

), n N e uma cadeia de Markov com

distribuicao inicial e matriz de probabilidade de transicao P, se P e estocastica e

2.1 Cadeias de Markov 5

(i) X

0

tem distribuicao ,

(ii)Para quaisquer n 0, e (i

0

, i

1

, . . . , i

n+2

) S

n+1

,

P(X

n+1

= i

n+1

| X

0

= i

0

, . . . , X

n

= i

n

) = P(X

n+1

= i

n+1

| X

n

= i

n

) (2.1)

= p

inin+1

.

A relacao em (2.1) e conhecida como a propriedade de Markov. Intuitivamente esta

rela cao indica que o processo nao apresenta memoria dos lugares visitados no passado. Se

o processo X = (X

n

), n N satisfaz as condicoes (i) e (ii) diremos que X e Markov(, P)

ou simplesmente uma cadeia de Markov.

Teorema 2.1. X e uma cadeia de Markov se, e somente se para todo i

0

, i

1

, . . . , i

N

S

N

,

P(X

0

= i

0

, X

1

= i

1

, . . . , X

N

= i

N

) =

i0

p

i0i1

p

i1i2

p

i

N1

i

N

.

Demonstracao. Seja X Markov(, P), entao

P(X

0

= i

0

, X

1

= i

1

, . . . , X

N

= i

N

)

= P(X

N

= i

N

| X

0

= i

0

, . . . , X

N1

= i

N1

)

P(X

N1

= i

N1

| X

0

= i

0

, . . . , X

N2

= i

N2

)

P(X

1

= i

1

| X

0

= i

0

)P(X

0

= i

0

)

=

i0

p

i0i1

p

i1i2

p

i

N1

i

N

,

onde a ultima igualdade segue (i) e (ii) da denicao 3.8, utilizando-se como hipotese que X

e Markov (, P). Para vericar a equivalencia no sentido oposto somamos i

N

sobre todo S

a ambos lados da igualdade no Teorema,

i

N

S

P(X

0

= i

0

, . . . , X

N

= i

N

) =

i

N

S

i0

p

i0i1

p

i1i2

p

i

N1

i

N

,

o qual implica

P(X

0

= i

0

, . . . , X

N1

= i

N1

) =

i0

p

i0i1

p

i1i2

p

i

N2

i

N1

,

uma vez que P(X

0

= i

0

, . . . , X

N

= i

N

) e a distribuicao conjunta de X

0

, . . ., X

N1

, X

N

, e

i

N

S

p

i

N1

i

N

= 1, ja que P e estocastica. Utilizando inducao deduzimos que para cada n

em 1, . . . , N 1,

P(X

0

= i

0

, . . . , X

n

= i

n

) =

i0

p

i0i1

p

in1in

,

e em particular que P(X

0

= i

0

) =

i0

. Assim, para n = 0, 1, . . . , N 1,

P(X

n+1

= i

n+1

| X

0

= i

0

, . . . , X

n

= i

n

) =

P(X

0

= i

0

, . . . , X

n+1

= i

n+1

)

P(X

0

= i

0

, . . . , X

n

= i

n

)

=

i0

p

i0i1

p

inin+1

i0

p

i0i1

p

in1in

= p

inin+1

,

o qual mostra que X e Markov (, P).

O seguinte resultado fornece uma interpretacao crucial da propriedade referida anterior-

mente como perda de memoria. Seja

i

= (

ij

: j S), uma distribuicao de probabilidade

concentrada em i, ou seja

ij

= 1 se i = j e

ij

= 0 se i = j.

6 2 Tempo discreto

Teorema 2.2 (Propriedade fraca de Markov). Seja X Markov(, P). Dado o evento

X

m

= i, o processo X

m+n

, n Z

+

, e Markov(

i

, P) e independente de X

0

, . . ., X

m

.

Demonstracao. A prova consiste em mostrar que a seguinte igualdade

P

_

{X

m

= i

m

, . . . , X

m+n

= i

m+n

} A|X

m

= i

_

=

iim

p

imim+1

p

im+n1im+n

P(A|X

m

= i)

e valida para qualquer evento A determinado pelas variaveis aleatorias X

0

, . . ., X

m

. Isto

e consequencia da nocao de independencia (condicional) de eventos da forma {X

m

, . . .,

X

m+n

} e A. Segue imediatamente desta igualdade e do Teorema 2.1 que X

m+n

, n N e

Markov(

i

, P).

Consideramos primeiro o caso particular A = {X

0

= i

0

, . . . , X

m

= i

m

} de tal forma que

P(X

m

= i

m

, . . . ,X

m+n

= i

m+n

A| X

m

= i)

=

P(X

m

= i

m

, . . . , X

m+n

= i

m+n

, A, {i

m

= i})

P(X

m

= i)

,

mas o numerador e dado por

P(X

m

= i

m

, . . . , X

m+n

= i

m+n

, A, i

m

= i)

= P(A, i

m

= i)P(X

m

= i

m

, . . . , X

m+n

= i

m+n

| A, i

m

= i)

= P(A, i

m

= i)P(X

m

= i

m

, . . . , X

m+n

= i

m+n

| X

m

= i)

= P(A, X

m

= i

m

)

iim

p

imim+1

p

im+n1im+n

,

sendo que Tanto a segunda como a terceira igualdade segue diretamente do Teorema 2.1.

No caso geral temos que qualquer evento A pode ser representado como

A =

_

k

A

k

,

onde A

k

sao eventos elementares disjuntos determinados por {X

0

, X

1

, . . . , X

m

= i}. O

resultado neste caso segue utilizando o mesmo argumento mas somando sobre os eventos

A

k

.

2.1.2 Probabilidades de n passos

Voltamos agora a uma das perguntas inicialmente formuladas no exemplo 2.1 que e a de

como calcular as distribuicoes condicionais e nao condicionais do processo no instante n,

P(X

n

= j|X

0

= i) e P(X

n

= i) para i, j S.

A propriedade de Markov e as operacoes basicas do produto matricial permitem obter estas

probabilidades de maneira eciente. Se representamos a distribuicao inicial como um vetor

(la) em S, entao

(P)

j

=

iS

i

p

ij

=

iS

P(X

0

= i)P(X

1

= j | X

0

= i)

= P(X esta em j no instante 1)

Utilizando o produto matricial introduzimos agora a seguinte notacao,

(PP)

ij

= (P

2

)

ij

, i, j S

2.1 Cadeias de Markov 7

isto e,

(P

2

)

ij

=

kS

p

ik

p

kj

= p

2

ij

=

kS

P(X

2

= j | X

1

= k)P(X

1

= k | X

0

= i)

= P(X realiza uma transicao de i a j em dois passos)

Denicao 2.4. Para n 0, denimos o n-esimo iterado da probabilidade de transicao como

p

n

ij

= P(X

n

= j | X

0

= i)

A matriz formada pelos elementos (p

n

ij

), i, j S sera denotada por P

n

.

Com o proposito de enfatizar a condicao inicial X

0

= i, as vezes tambem sera empregada

a notacao p

n

ij

= P

i

(X

n

= j).

Denicao 2.5. Seja X uma cadeia de Markov. X e temporalmente homogenea se para

quaisquer i, j S e m, n,

P(X

m+n

= j|X

m

= i) = P(X

n

= j|X

0

= i).

Todos os processos considerados adiante sao temporalmente homogeneos.

Teorema 2.3. Seja X Markov(, P). Para todo n, m 0 temos que

(i) P(X

n

= j) = (P

n

)

j

.

(ii) P

i

(X

n

= j) = P(X

m+n

= j | X

m

= i) = P(X

n

= j | X

0

= i) = p

n

ij

.

Demonstracao. Do Teorema 2.1, da denicao 2.4 e da notacao introduzida temos

P(X

n

= j) =

ioS

in1S

P(X

0

= i

0

, . . . , X

n1

= i

n1

, X

n

= j)

=

ioS

in1S

i0

p

i0i1

p

in1j

= (P

n

)

j

,

o qual termina a prova do primeiro item. Seguindo a propriedade de Markov exposta no

Teorema 2.2, dado o evento {X

m

= i}, (X

m+n

) e Markov(

i

, P). Resulta portanto suciente

considerar =

i

para o primeiro item, i.e., P

i

(X

n

= j) = (

i

P

n

)

j

= p

n

ij

.

Observamos que P

1

= P e P

0

= I, onde I denota a matriz identidade.

Teorema 2.4 (Chapman-Kolmogorov). Seja X uma cadeia de Markov(, P), entao

P

m+n

= P

m

P

n

.

Antes de proceder com a prova observamos que este resultado e uma generalizacao de

(PP)

ij

=

k

p

ik

p

kj

ao caso (P

m+n

)

ij

=

k

p

m

ik

p

n

kj

.

Demonstracao.

p

m+n

ij

= P

i

(X

m+n

= j)

=

kS

P(X

m+n

= j, X

m

= k | X

0

= i)

=

kS

P(X

m+n

= j | X

m

= k, X

0

= i)P(X

m

= k | X

0

= i)

=

kS

P(X

m+n

= j | X

m

= k)P(X

m

= k | X

0

= i) =

kS

p

m

ik

p

n

kj

.

8 2 Tempo discreto

2.1.3 Exerccios

Exerccio 2.1. (i) Mostre que (P)

j

e uma distribuicao de probabilidade em S. (ii) Mostre

que P

n

e uma matriz estocastica em S para qualquer n 0.

Exerccio 2.2. Suponha que os movimentos da BOVESPA podem ser modelados por uma

cadeia de Markov com valores em S = {, +}, sendo que representa um dia onde a

bolsa fecha em valor negativo e + um dia com fechamento positivo. Nesta caso o grafo e

a matriz de transicao que denem a evolucao dia a dia da BOVESPA sao dados por

1

_

P =

_

1

1

_

0 < , < 1. (i) Se a cadeia come ca num dia do tipo , e = =

3

4

, mostrar que

n

=

_

P(X

n

= ), P(X

n

= +)

_

=

_

1

2

(1 + 2

n

),

1

2

(1 2

n

)

_

(

n

e a distribuicao do processo em n, isto e a probabilidade de que a BOVESPA feche

em ou + respectivamente, sendo que

0

= (1, 0)). (ii) Interpretar lim

n

n

. (iii)

Calcular p

n

11

= P(X

n

= 1|X

0

= 1) no caso geral para qualquer 0 < 1 e 0 < 1.

[Dica: utilize a equacao de Chapman-Kolmogorov P

n+1

= P

n

P para obter uma relacao de

recorrencia para p

n

11

. O apendice apresenta brevemente a teoria necessaria para resolver este

tipo de recorrencia.]

Exerccio 2.3. Uma consultora nanceira classica emprestamos de carros em quatro ca-

tegorias: o emprestimo foi pago em sua totalidade (F), o contrato encontra-se em boas

condicoes sendo que todos os juros estao ao dia (G), a conta esta em situacao irregular com

um ou mais pagamentos pendentes (A), ou a conta se encontra em pessimas condicoes e foi

vendida a uma agencia de colecao do credito (B). O historico indica que cada mes 10% dos

contratos do tipo G paga em sua totalidade os juros, 80% permanecem em G, e 10% viram

do tipo B. Logo 10% das contas do tipo A pagam os juros totalmente, 40% viram do tipo

G, 40% permanecem em A, e 10% viram do tipo B. (i) Calcule a proporcao de contratos

do tipo B que pagarao a sua divida totalmente no futuro. (ii) Qual sera a proporcao de

contratos de tipo G que num futuro serao do tipo B.

Exerccio 2.4. Seja (X

n

)

n0

uma cadeia de Markov com valores em S = {v

1

, v

2

, v

3

}, e o

seguinte grafo e matriz de transicao

v

1

1

v

2

1/2

1/2

v

3

1/2

1/2

P =

_

_

0 0 1

1/2 1/2 0

0 1/2 1/2

_

_

,

onde as las e as colunas de P estam dispostas de acordo com a ordem (v

1

, v

2

, v

3

). Encontre

uma equacao geral para p

n

v1v1

. [Dica: utilize a diagonalizacao da matriz P.]

Exerccio 2.5. Seja (X

n

)

n0

uma sequencia de v.a. independentes e identicamente dis-

tribudas, temos entao

(a) S

n

=

n

i=1

X

i

,

(b) M

n

= X

1

X

2

. . . X

n

,

(c) L

n

= X

1

X

2

. . . X

n

,

(d) K

n

= X

n

+X

n1

.

2.1 Cadeias de Markov 9

(i) Qual das seq uencias X

n

, S

n

, M

n

, L

n

e K

n

e Markov? (ii) Encontre a matriz de proba-

bilidade de transicao para as seq uencias que sao cadeias de Markov.

Exerccio 2.6. Suponha agora que Z

0

, Z

1

, . . . sao variaveis aleatorias independentes e iden-

ticamente distribudas tais que Z

i

= 1 com probabilidade p e Z

i

= 0 com probabilidade

1 p. Seja S

0

= 0 e S

n

= Z

1

+ . . . + Z

n

. Em cada um dos seguintes casos determine se

(X

n

)

n0

e uma cadeia de Markov:

(a) X

n

= Z

n

, (b) X

n

= S

n

, (c) X

n

= S

0

+. . . +S

n

, (d) X

n

= (S

n

, S

0

+. . . +S

n

).

Encontre o espaco de estados e a matriz de probabilidade de transicao nos casos em nos

quais (X

n

)

n0

e uma cadeia de Markov.

Exerccio 2.7. Seja (X

n

)

n0

Markov (, P). Se Y

n

= X

kn

, mostrar que (Y

n

)

n0

e Markov

(, P

k

). Em geral, a amostragem de (X

n

)

n0

a intervalos constantes de comprimento k gera

uma cadeia chamada o k-esqueleto de (X

n

)

n0

.

Exerccio 2.8. Seja X

0

uma v.a. com valores no conjunto enumeravel S. Seja U

1

, U

2

, . . .

uma seq uencia de v.as. independentes e com distribuicao uniforme em [0, 1]. Sejam as funcoes

F : S [0, 1] S, f : [0, 1] S

tais que

X

n

=

_

F(X

n1

, U

n

), se n 1,

f(U

0

), se n = 0.

(i) Mostre que (X

n

)

n0

e uma cadeia de Markov e encontre a matriz de probabilidade de

transicao P em termos de F. Escreva a distribuicao inicial em termos de f. (ii)

E possvel

construir qualquer cadeia desta forma?

Exerccio 2.9. Utilize o exerccio anterior para simular o processo seguido pelo sapo no

exemplo 2.1 tomando p = 1/2. (i) Faca um graco de X

n

() versus n para diferentes . (ii)

Utilize a matriz de probabilidade de transicao apresentada no exerccio 2.4 para simular esta

cadeia e estime utilizando as suas simulacoes a probabilidade p

50

v1v1

. Dica: utilize o seguinte

estimador (justicado pelo Teorema 2.22 adiante)

p

50

v1v1

= {# vezes em v

1

no instante 50}/{# total de caminhos simulados}.

Exerccio 2.10. Uma pulga pula sobre os vertices de um triangulo de maneira que qualquer

pulo tem a mesma probabilidade. Encontrar a probabilidade de que depois de n pulos a pulga

encontra-se no lugar de partida. Uma segunda pulga tambem decide pular sobre os vertices

do triangulo, mas a probabilidade de pular no sentido horario e duas vezes a probabilidade

no sentido contrario. Qual a probabilidade de que apos de n pulos esta ultima esteja no

mesmo lugar onde iniciou. [Lembrar que e

i/6

=

3/2 i/2.]

Exerccio 2.11.

Seja (X

n

)

n0

uma cadeia de Markov em S, e seja I : S

n

{0, 1}. Mostre

que a distribuicao condicional de X

n

, X

n+1

, . . . dado o evento {I(X

1

, . . . , X

n

) = 1 {X

n

=

i}} e identica a distribuicao de X

n

, X

n+1

, . . . dado {X

m

= i}.

Exerccio 2.12. Seja X uma cadeia de Markov em Z

+

e probabilidades de transicao

p

01

= 1, p

i,i+1

+p

i,i1

= 1, p

i,i+1

=

_

i + 1

i

_

2

p

i,i1

, i 1.

Mostre que se X

0

= 0 entao a probabilidade de que X

n

1 para todo n 1 e 6/

2

.

10 2 Tempo discreto

Exerccio 2.13. Seja (X

n

)

n0

uma cadeia de Markov com espaco de estados S, e suponha

que h : S T e bijetiva. Mostre que Y

n

= h(X

n

) dene uma cadeia de Markov em T . h

tem que ser bijetiva?

Exerccio 2.14. O seguinte exerccio mostra como trabalhar com uma cadeia de Markov

quando so se tem informacao sobre algumas das transicoes do processo. Seja J um sub-

conjunto do espaco de estados nito S de uma cadeia de Markov com matriz de transicao

particionada da seguinte forma,

J J

c

P =

J

J

c

_

A B

C D

_

Suponhamos e possvel registrar as entradas a J, e neste caso e observada uma cadeia de

Markov (

X

n

) com valores em J. (i) Mostre que a matriz de transicao de

X

n

e

P = A+B

n0

D

n

C = A+B(I D)

1

C.

(ii) O Dr. P. Silva ca a maior parte do seu tempo em Ribeirao Preto no trabalho (T), no

seu at (F), em uma boate (B), ou com uma amante (A). Cada hora, ele muda de um destes

possveis estados de acordo com uma matriz de probabilidade de transicao P, mas a sua

mulher que desconhece da existencia da amante acha que as mudancas estao determinadas

pela matriz P

E

,

T F B A

P =

T

F

B

A

_

_

1/3 1/3 1/3 0

0 1/3 1/3 1/3

1/3 0 1/3 1/3

1/3 1/3 0 1/3

_

_

,

T F B

P

E

=

T

F

B

_

_

1/3 1/3 1/3

1/3 1/3 1/3

1/3 1/3 1/3

_

_

.

As pessoas so encontram com o Dr. Silva quando esta se encontra em J = {T, F, B}. (ii)

Calcule a matriz

P que aparentemente controla os movimentos do Dr. Silva.

As aventuras do Dr. Silva serao continuadas no exerccio 2.38.

2.2 Classes de comunicacao

Iniciamos a continuacao o estudo de grupos de estados que apresentam certas caractersticas

em comum. Um dos objetivos e o de restringir o estudo do processo denido em S a partes

mais simples tais que juntas estas permitam fornecer uma visao geral do processo sobre S.

Denicao 2.6. Sejam i e j dois pontos quaisquer em S. O estado i conduz a j, denotado

i j, se existe n > 0 tal que p

n

ij

> 0. Utilizamos a notacao i j para indicar que i nao

conduz a j.

Denicao 2.7. O estado i comunica com o estado j, denotado i j, se i j e j i.

Utilizamos a notacao i j para indicar i j ou j i, ou i j e j i.

Ressaltamos que na ultima denicao o n umero de passos num sentido nao e ne-

cessariamente igual ao n umero no sentido contrario.

2.2 Classes de comunicacao 11

Teorema 2.5. Para quaisquer dois estados i, j S, i = j, as seguintes armacoes sao

equivalentes.

(i) i j.

(ii)p

i0i1

p

i1i2

p

in1in

> 0 para uma seq uencia de estados i

0

, i

1

, . . . , i

n

com i

0

= i e i

n

= j.

(iii)p

n

ij

> 0 para algum n 0.

Demonstracao. Observamos primeiro que

p

n

ij

P

i

(X

n

= j para alguns n 0)

n=0

p

n

ij

,

ja que

{X

n

= j | X

0

= i}

_

alguns k n

{X

k

= j | X

0

= i}

_

kn

{X

k

= j | X

0

= i}

demonstrando a equivalencia entre (i) e (iii). Segue-se do Teorema 2.4 que

p

n

ij

=

i1,i2,...,in1

p

ii1

p

i1i2

. . . p

in1j

,

o qual implica a equivalencia entre (ii) e (iii).

E simples vericar que relacao e uma relacao de equivalencia em S (faca isto como

um exerccio). A relacao pode ser utilizada portanto para classicar os elementos de S,

uma vez que esta induz una parti cao de S. As classes desta particao sao conhecidas como

as classes de comunicacao de S .

Denicao 2.8. Uma classe de comunicacao C e fechada se

i C : i j j C.

A classe fechada relacionada a i sera denotada por C(i) = {j S : i j}. Uma classe sera

chamada de aberta se esta nao e fechada.

Uma classe fechada e uma classe sem sada ja que se em algum instante X atinge um

estado da classe fechada, entao X nao consegue se comunicar com um estado de outra classe.

Denicao 2.9. Um estado i S e chamado de estado absorvente se o conjunto {i} e uma

classe fechada.

Neste sentido uma classe de comunicacao fechada e uma classe absorvente.

Denicao 2.10. X e uma cadeia de Markov irredutvel se S e a unica classe de comunicacao

induzida por .

Se X e irredutvel entao diremos que P e uma matriz irredutvel, ou equivalentemente

que S e irredutvel.

Exemplo 2.2. A procura das classes de comunicacao e simplicada ao achar o grafo G as-

sociado a matriz de probabilidade de transicao P. Consideramos por exemplo a seguinte

matriz

12 2 Tempo discreto

P =

_

_

1/2 1/2 0 0 0 0

0 0 1 0 0 0

1/3 0 0 1/3 1/3 0

0 0 0 1/2 1/2 0

0 0 0 0 0 1

0 0 0 0 1 0

_

_

.

Neste caso se chamamos os estados de v

1

, v

2

, . . ., v

6

, e os associamos nesta ordem as las e

as colunas de P, entao encontramos o seguinte grafo,

v

1

v

4

v

3

v

2

v

5

v

6

Diretamente do grafo deduzimos que esta cadeia apresenta as classes de comunicacao

{v

1

, v

2

, v

3

}, {v

4

} e {v

5

, v

6

}. A classe {v

5

, v

6

} e fechada ja que uma vez que X entra neste

conjunto de estados X nao pode mais sair destes. Observamos que {v

1

, v

2

, v

3

} formam uma

classe desde que v

1

v

2

e v

1

v

3

, v

2

v

1

e v

2

v

3

, e nalmente v

3

v

1

, v

3

v

2

. Logo

{v

4

} / {v

1

, v

2

, v

3

} ja que v

4

v

1

(e tambem v

4

v

2

e v

4

v

3

). As classes {v

1

, v

2

, v

3

}

e {v

4

} sao classes abertas desde que estas comunicam com estados de outras classes. Isto

conclui a descricao das classes de comunicacao de S.

Exerccio 2.15. Seja X uma cadeia de Markov com grafo de transicao

c

(i) Encontre as classes de estados fechadas. (ii) Diga se X e irredutvel.

2.3 Tempos do primeiro retorno e da primeira chegada

Grande parte dos problemas encontrados no estudo das cadeias de Markov e em geral dos

processos estocastico podem ser reduzidos ao estudo de duas variaveis aleatorias conhecidas

como o primeiro tempo de retorno e o primeiro tempo de chegada.

Denicao 2.11. Seja X Markov(, P) com valores em S. O primeiro tempo de chegada ao

conjunto A S e a variavel aleatoria

A

: Z

+

dada por

A

() = inf{n 0 : X

n

() A}.

(sendo inf{} = .) . O primeiro tempo de retorno a A S e a variavel aleatoria

A

:

Z

+

denida como

A

() = inf{n 1 : X

n

() A}.

2.3 Tempos do primeiro retorno e da primeira chegada 13

Segue diretamente desta denicao que

A

=

A

1

{X0 / A}

q.c.

1

As seguintes notacoes serao utilizada em numerosas ocasioes. Condicionando pelo evento

inicial {X

0

= i}, a probabilidade de que X chegue a A e denotada por

h

A

i

= P

i

(

A

< ) =

n0

P

i

(

A

= n).

O tempo esperado para chegar ate A a partir de i e denotado por

k

A

i

= E

i

[

A

] =

n0

nP(

A

= n) +P(

A

= ).

Denicao 2.12. Se A e uma classe fechada, entao h

A

i

e chamada de probabilidade de ab-

sorcao em A.

Exemplo 2.3. O seguinte exemplo ilustra o calculo de h

A

i

e k

A

i

num caso elementar. Seja X

uma cadeia com valores em S = {1, 2, 3, 4} e o seguinte grafo de transicao

1

1

2

2

1

2

3

1

2

4

1

2

Se X e iniciada no estado 2, qual a probabilidade de X ser absorvida em 4? Logo, quanto

tempo demora X para ser absorvida em 1 ou em 4?

Seja A = {1, 4}, claramente das denicoes de h

i

e k

i

temos

h

4

1

= 0, h

4

4

= 1, k

A

1

= k

A

4

= 0.

Suponhamos agora que X

0

= 2 e a seguir consideramos as possibilidades apos da primeira

transicao, isto e, com probabilidade 1/2 pulamos de 2 a 1 e com 1/2 de 2 a 3, logo

h

4

2

=

1

2

h

4

1

+

1

2

h

4

3

, (a)

k

A

2

= 1 +

1

2

k

A

1

+

1

2

k

A

3

. (b)

A justicativa destas equacoes esta baseada essencialmente na propriedade de Markov. Para

(a), seja E = {Xe absorvida em 4} entao

h

4

2

= P(E | X

0

= 2) =

kS

P(E, X

1

= k | X

0

= 2)

= P(E, X

1

= 1 | X

0

= 2) +P(E, X

1

= 3 | X

0

= 2)

= P(E | X

1

= 1, X

0

= 2)P(X

1

= 1 | X

0

= 2)

+P(E | X

1

= 3, X

0

= 2)P(X

1

= 3 | X

0

= 2)

= P(E | X

1

= 1)p

21

+P(E | X

1

= 3)p

23

,

1

q.c. e a forma abreviada de quase certamente. A armacao sobre uma variavel aleatoria se diz

quase certa se P{ : e verdadeira} = 1, ou equivalentemente se P{ : nao e verdadeira} = 0.

E claro que existe diferenca entre e verdade e e verdade q.c.

14 2 Tempo discreto

sendo que a ultima linha segue do Teorema 2.1. Um argumento similar pode ser utilizado

para comprovar (b), mais a justicativa formal sera deixada para o Teorema 2.7 adiante.

Com probabilidade p

21

= 1/2 ocorre a primeira transicao ao estado 1, logo temos que

considerar k

4

1

como o valor esperado dos passos ate a absorcao. A outra possibilidade, a

qual corresponde a transicao de 2 a 3 inclui as quantidades p

23

= 1/2 e h

4

3

. Utilizando

exatamente este mesmo procedimento agora obtemos h

4

3

e k

A

3

,

h

4

3

=

1

2

h

2

+

1

2

h

4

4

(c)

k

A

3

= 1 +

1

2

k

A

2

+

1

2

k

A

4

(d)

Substituindo (c) em (a) e lembrando que h

1

4

= 0, h

4

4

= 1, obtemos

h

4

2

=

1

2

_

1

2

h

4

2

+

1

2

_

, logo h

4

2

=

1

3

.

Finalmente, de (d) em (b) e k

A

1

= k

A

4

= 0,

k

A

2

= 1 +

1

2

_

1 +

1

2

k

A

2

_

, entao k

A

2

= 2.

Este exemplo tem por objetivo mostrar o argumento central baseado na decomposicao

associada a primeira transicao. Dependendo da simetria inerente ao grafo de transicao,

sucessivas decomposicoes podem levar diretamente a resposta nal. Em geral este metodo

permite construir uma equacao em diferenca a qual pode ser resolvida utilizando diversas

tecnicas. O apendice a estas notas apresenta um metodo geral para resolver este tipo de

equacoes.

Em geral temos o seguinte resultado.

Teorema 2.6 (probabilidade da primeira chegada). O vetor da probabilidade dos

tempos da primeira chegada ao conjunto A S, h

A

= (h

A

i

: i S), e a solucao nao

negativa mnima ao sistema linear

h

A

i

=

_

1, se i A,

jS

p

ij

h

A

j

, se i / A.

(2.2)

h e a solucao mnima se para uma outra solucao g = (g

i

: i S) tal que g

i

0, entao

pontualmente g

i

h

i

.

Demonstracao. Mostraremos primeiro que h

A

i

e uma solucao ao sistema indicado. Trivial-

mente, se X

0

= i A entao

A

= 0 implica h

A

i

= 1. Se X

0

= i / A, entao

A

1 e seguindo

a propriedade de Markov,

P

i

(

A

< | X

1

= j) = P(

A

< | X

1

= j, X

0

) = P(

A

< | X

1

= j)

= P

j

(

A

< ) = h

A

j

,

logo,

h

A

i

=

jS

P

i

(

A

< , X

1

= j) =

jS

P

i

(

A

< | X

1

= j)P

i

(X

1

= j)

=

jS

p

ij

h

A

j

.

2.3 Tempos do primeiro retorno e da primeira chegada 15

Mostramos agora que h

A

e a solucao mnima. Suponhamos que g = (g

i

: i S) e uma outra

solu cao qualquer portanto se i A entao g

i

= 1 = h

A

i

. Porem, se i / A entao

g

i

=

jS

p

ij

g

j

=

jA

p

ij

+

j / A

p

ij

g

j

.

Substituindo da mesma maneira mais uma vez para g

j

,

g

i

=

jA

p

ij

+

j / A

p

ij

_

kA

p

jk

+

k/ A

p

jk

g

k

_

= P

i

(X

1

A) +P

i

(X

1

/ A, X

2

A) +

j / A,k/ A

p

ij

p

jk

g

k

.

Repetindo este argumento por inducao tem-se

g

j

= P

i

(X

1

A) +. . . +P

i

(X

1

/ A, . . . , X

n1

/ A, X

n

A)

+

j1 / A...jn / A

p

ij1

p

j1j2

. . . p

jn1jn

g

jn

.

Se g e nao negativa entao o ultimo termo da equacao acima e nao negativo. Por outro lado,

os termos restantes tem soma igual a P

i

( n), portanto

g

i

P

i

(

A

n), n 1,

Assim, no limite n ,

g

i

lim

n

P

i

(

A

n) = P

i

_

_

n

{

A

n}

_

= P

i

(

A

< ) = h

i

.

Este Teorema quando aplicado ao exemplo 2.3 leva diretamente ao seguinte sistema

h

4

4

= 1, h

4

2

=

1

2

h

4

1

+

1

2

h

4

3

, h

4

3

=

1

2

h

4

2

+

1

2

h

4

4

,

o qual expressa h

4

2

em terminos do valor desconhecido h

4

1

. Da minimalidade da solucao

podemos considerar h

4

1

= 0, o qual leva ao valor h

4

2

= 1/3.

Apresentamos a continuacao dois exemplos classicos da aplicacao do principio de de-

composicao da primeira transicao. Cada um destes resulta em uma equacao em diferenca

particular.

Exemplo 2.4 (runa do jogador). Seja X Markov(, P) com valores em Z

+

e probabilidades

de transicao p

0,0

= 1, p

i,i1

= q, p

i,i+1

= p para 0 < p < 1, q = 1 p. Este processo

apresenta a seguinte representacao interessante. Suponha que voce entra num cassino com

i R$. Cada vez que voce joga, voce pode ganhar um real com probabilidade p ou perder

um real com probabilidade q = 1 p. Desta forma X

n

representa a sua fortuna depois da

n-esima aposta. Suponha que o cassino apresenta uma fonte ilimitada de dinheiro, portanto

nao existe em principio um limite superior para a quantidade da sua fortuna. A gura 2.2

apresenta uma caminho tpico deste processo. Qual a probabilidade de voce perder tudo o

seu dinheiro? Nao e difcil chegar a seguinte resposta

P

i

(X

n

chega a 0) = P

i

(

0

< ) = h

0

i

.

Da decomposicao da primeira transicao obtemos entao que

16 2 Tempo discreto

h

0

0

= 1,

h

0

i

= ph

0

i+1

+qh

0

i1

, i 1. (2.3)

Um metodo geral para resolvermos a equacao em diferenca de segunda ordem e apresentado

no apendice. Apresentamos a seguir um outro metodo parecido com o metodo utilizado para

resolver equacoes diferenciais ordinarias lineares, o qual consiste em encontrar duas solucoes,

1

e

2

, linearmente independentes tais que

h

0

i

= c

1

(

1

)

i

+c

2

(

2

)

i

.

Propomos primeiro uma solucao da forma h

0

i

=

i

, de maneira que a recorrencia em (2.3)

toma a forma

i

= p

i+1

+ q

i1

, i 1. Em particular para i = 1 temos a equacao

caracterstica

p

2

+q = 0

com razes

=

1

1 4pq

2p

+

=

1 +

1 4pq

2p

.

Duas situacoes sao possveis, A: 1 4pq = 0 (quando p = q =

1

2

), e B: 1 4pq = 0.

Analisamos cada caso separadamente.

Caso A. Se p = q entao temos

=

+

= = 1. Logo propomos mais uma solucao

(linearmente independente de

i

) da forma i

i

e entao em geral obtemos

h

0

i

= c

1

()

i

+c

2

i()

i

= c

1

+c

2

i.

Esta solucao tem que ser valida para todo i 0, o qual forca c

2

= 0 de maneira que no

limite i , h

0

i

ainda possa satisfazer h

0

i

1. A nossa solucao agora apresenta a forma

h

0

i

= c

1

, mas da condicao inicial do problema h

0

0

= 1 = c

1

+ c

2

inferimos que c

1

= 1,

logo nalmente h

0

i

= 1. Isto implica que mesmo quando o cassino e honesto, com certeza

sempre acabaremos arruinados, independentemente da nossa quantidade inicial de dinheiro.

(

E melhor saber retirarse a tempo!)

Caso B. Se p = q, entao

=

1

_

1 4p(1 p)

2p

=

1

_

(2p 1)

2

2p

= 1

e

=

1 +

_

(2p 1)

2

2p

=

q

p

Neste caso a solucao geral ja toma a forma desejada

h

0

i

= c

1

(1)

i

+c

2

_

q

p

_

i

,

porem ainda ca por ser determinados os valores de c

1

e c

2

. Observamos que se p < q,

entao no limite i temos que (q/p)

i

diverge, portanto seguindo o mesmo argumento

empregado no caso A conclumos que h

0

i

= 1 para i 1. Isto e, se a chance de perder cada

aposta e maior que a chance de ganhar, entao com certeza tambem acabaremos arruinados!

Finalmente se p > q, utilizando a condicao inicial na solucao geral temos

h

0

i

= c

1

+ (1 c

1

)

_

q

p

_

i

=

_

q

p

_

i

+c

1

_

1

_

q

p

_

i

_

.

2.3 Tempos do primeiro retorno e da primeira chegada 17

Sendo p > q, necessariamente 1 (q/p)

i

> 0, o qual implica que c

1

0 e entao h

0

i

0.

Utilizamos a propriedade minimal de h

0

i

demonstrada no Teorema 2.6 para justicar a

escolha c

1

= 0. A solucao neste caso e portanto

h

0

i

=

_

q

p

_

i

.

Conclumos que com probabilidade positiva podemos perder todo o nosso dinheiro mas a

mesma diminui geometricamente com i, isto e, a medida que entramos com mais dinheiro

no cassino. Finalmente no limite i temos que a probabilidade de nao car arruinados

e 1.

Exemplo 2.5 (processo de nascimento e morte simples). Seja X uma cadeia de Markov com

valores em Z

+

e probabilidades de transicao p

0,1

= 0, p

i,i+1

= p

i

, e p

i,i1

= q

i

. Este

processo e muito parecido com o processo que descreve a runa do jogador, mas agora as

probabilidades de transicao em cada instante dependem do estado atual do processo. A

cadeia assim denida pode ser utilizada para modelar o crescimento de uma populacao a

qual no instante n apresenta i indivduos, i.e., X

n

= i.

Uma quantidade importante nesta aplicacao e a probabilidade de extincao da populacao.

Dado que a populacao apresenta inicialmente i indivduos temos

P

i

(chegar a 0 indivduos) = P

i

(

0

< ) = h

0

i

.

Utilizando a decomposicao da primeira transicao temos que esta probabilidade satisfaz a

seguinte relacao de recorrencia

h

0

i

= p

i

h

0

i+1

+q

i

h

0

i1

, i = 1, 2, . . .

Observamos que, a diferenca do exemplo 2.4, a equacao em diferenca que descreve h

0

i

agora

nao e homogenea pois os coecientes q

i

, p

i

dependem do estado atual do processo. Mesmo

assim, neste caso ainda e possvel encontrar a solucao diretamente. Seja

i

= h

0

i1

h

0

i

,

logo

p

i

i+1

= p

i

h

0

i

p

i

h

0

i+1

= p

i

h

0

i

(h

0

i

q

i

h

0

i1

)

= h

0

i

(1 p

i

) +q

i

h

0

i1

= q

i

(h

0

i1

h

0

i

) = q

i

i

,

e portanto

i+1

=

q

i

p

i

i

.

Desta forma, utilizando inducao sobre i conseguimos

i+1

=

q

i

p

i

q

i1

p

i1

q

1

p

1

1

.

Se

i

=

i

k=1

q

k

/p

k

, para i 1, entao

i+1

=

i

1

.

Por outro lado observamos que

1

+

2

+. . . +

i

= h

0

0

h

0

i

.

18 2 Tempo discreto

Combinando estes dois resultados temos a forma geral para a probabilidade de extincao

h

0

i

= 1

1

(

0

+

1

+. . . +

i1

).

Para obtermos h

0

i

, ainda temos que calcular

1

. Consideramos a tal m separadamente os

seguintes casos, A:

i=0

i

= , e B:

i=0

i

< .

Caso A. A m de garantirmos h

0

i

1 para todo i 1 neste caso e necessario que

1

= 0.

Desta forma h

0

i

= 1, i 1, isto e, com certeza a populacao sera extinta para qualquer

n umero inicial de indivduos.

Caso B. Se

i=0

i

< , entao deve existir um ndice k < tal que

q

k+n

q

1

p

k+n

p

1

= 0,

para todo n 0. Portanto e possvel considerar

1

> 0 sempre e quando

1

(

0

+. . . +

i1

) <

1, para i 1. Utilizando o Teorema 2.6 escolhemos

1

=

_

i=0

i

_

1

,

ja que neste caso obtemos a solucao mnima para h

0

i

. Obviamente a escolha satisfaze

1

(

0

+

. . . +

i1

) < 1 e entao da expressao geral para h

0

i

temos

h

0

i

= 1

i1

j=0

j=0

j

=

j=i

j=0

j

< 1, i 1.

Conclumos que para qualquer quantidade inicial de indivduos, i 1, a probabilidade de

extincao h

0

i

< 1, ou equivalentemente P

i

(sobrevivencia) = 1 h

0

i

> 0.

Este exemplo, igualmente ao anterior, mostra como a condicao de minimalidade e util

na solucao de equacoes em diferenca para calcular h

A

i

, em especial quando S nao e nito

pois neste caso usualmente nao temos uma das condicoes de contorno necessarias.

Voltamos agora a considerar os tempos esperados da primeira chegada a um conjunto

A S, isto e k

A

i

. Para esta quantidade apresentamos o seguinte resultado geral.

Teorema 2.7 (tempo esperado da primeira chegada). O vetor de tempos esperados

de chegada k

A

= (k

A

i

: i S), e a solucao mnima, nao-negativa ao sistema de equacoes

lineares

k

A

i

=

_

0, se i A,

1 +

j=A

p

ij

k

A

j

, se i / A.

Demonstracao. Mostramos primeiro que k

A

= (E

i

[

A

] : i S) satisfaz este sistema. Se

X

0

= i A entao

A

= 0, logo E

i

[

A

] = E

i

[0] = 0. Se X

0

= i / A entao

A

1.

Observamos primeiro que

E

i

[

A

| X

1

= j] = E

i

[

A

| X

1

= j, X

0

= i]

= E[inf{n 0 : X

n

A} | X

1

= j, X

0

= i]

= E[inf{n 1 : X

n

A} | X

1

= j]

= 1 +E[inf{n 0 : X

n

A} | X

0

= j] = 1 +E

j

[

A

]

sendo que a primeira e a terceira igualdade seguem da propriedade de Markov. A terceira

tambem utiliza X

0

= i / A, e a quarta e consequencia da homogeneidade (temporal) do

processo. Agora

2.3 Tempos do primeiro retorno e da primeira chegada 19

k

A

i

= E

i

[

A

] =

jS

E

i

[

A

1

{X1=j}

] =

jS

A

()1

{X1=j}

() P

i

()

=

jS

n

nP

i

(

A

() = n, X

1

() = j)

=

jS

n

nP

i

(

A

() = n| X

1

= j) P

i

(X

1

= j)

=

jS

E

i

[

A

| X

1

= j] p

ij

,

e portanto da primeira parte da prova

k

A

i

=

jS

(1 +E

j

[

A

]) p

ij

= 1 +

jS

E

j

[

A

]) p

ij

= 1 +

j / A

p

ij

k

A

j

.

A restricao do somatorio ao complemento de A e devida a que k

A

j

= 0 para j A.

Mostramos agora que (k

A

i

: i S) e de fato a solucao mnima. Suponhamos que r =

(r

i

: i S) e qualquer outra soluc ao ao sistema. Entao k

A

i

= r

i

= 0 para qualquer i A. Se

i / A, dado que r

i

satisfaz o sistema,

r

i

= 1 +

j / A

p

ij

r

j

= 1 +

j / A

p

ij

_

1 +

k/ A

p

jk

r

k

_

= 1 +

j / A

p

ij

+

j / A,k/ A

p

ij

p

jk

r

k

= P

i

(

A

1) +P

i

(

A

2) +

j / A,k/ A

p

ij

p

jk

r

k

Utilizando inducao

r

i

=

n

k=1

P

i

(

A

k) +

j1 / A,...,jn / A

p

ij1

p

j1j2

p

jn1jn

r

jn

.

Se r e nao negativa, entao necessariamente

r

i

n

k=1

P

i

(

A

k),

o qual e valido para todo n 1, logo no limite

r

i

k=1

P

i

(

A

k) = E

i

[

A

] = k

A

i

.

Nesta ultima linha utilizamos a identidade

k0

P( > k) = E[], valida para qualqer

variavel aleatoria nao negativa.

Existe uma outra maneira para calcular os valores esperados do primeiro tempo de

retorno, baseada no metodo da funcao geradora.

Denicao 2.13. Seja uma variavel aleatoria com valores em um conjunto enumeravel S.

A funcao geradora de probabilidade de e denida por

G(z) = E[z

] =

iS

z

i

P( = i),

para tudo |z| 1 pertencente ao raio de convergencia da serie de potencia a direita.

20 2 Tempo discreto

O seguinte Lema apresenta algumas das propriedades basicas destas funcoes. A sua

demonstracao e deixada como um exerccio.

Lema 2.1. Se tem funcao geradora G(z), entao (i) G(1) = 1, (ii) G(0) = P( = 0), e

(iii) E[] = G

(1) =

dG(z)

ds

z=1

.

Seja h

j

i

(n) a distribuicao do primeiro tempo de retorno de i a j, isto e,

h

j

i

(n) = P

i

(

j

= n), n = 0, 1, 2, . . .

Consideramos agora as seguintes funcoes geradoras

G

ij

(z) =

n=0

z

n

p

n

ij

, H

i

(z) =

n=0

z

n

h

i

i

(n).

Lema 2.2. Seja X uma cadeia de Markov e i S em estado qualquer. Neste caso, G

ii

(z) =

1 +H

i

(z)G

ii

(z) e G

ij

(z) = H

i

(z)G

jj

(z) se i = j.

Demonstracao. Veja [5], pagina 85.

Estes resultados podem ser utilizados para calcular o tempo medio do primeiro retorno.

Do Lema 2.2 temos que H

i

(z) = 1 (G

ii

(z))

1

, o qual combinado com o Lema 2.1 resulta

em

k

i

i

= E

i

[

i

] = H

i

(z)

z=1

=

_

1

1

G

ii

(z)

_

z=1

.

Exemplo 2.6. Duas cadeias de Markov estao denidas pelas seguintes matrizes de probabi-

lidade de transicao,

(a)

_

_

1 2p 2p 0

p 1 2p p

0 2p 1 2p

_

_

, (b)

_

_

0 p 0 1 p

1 p 0 p 0

0 1 p 0 p

p 0 1 p 0

_

_

Calculamos a seguir os tempos de recorrencia esperados para cada um dos possveis estados

em (a) e (b). Encontramos primeiramente a funcao geradora G

ii

(z), para o qual calculamos

P

n

= ND

n

N

1

. Da equacao caracterstica associada obtemos os tres autovalores 1, (12p),

e (1 4p), logo

N =

_

_

1 1 1

1 0 1

1 1 1

_

_

, N

1

=

_

_

1/4 1/2 1/4

1/2 0 1/2

1/4 1/2 1/4

_

_

D

n

=

_

_

1 0 0

0 (1 2p)

n

0

0 0 (1 4p)

n

_

_

e entao calculando o produto ND

n

N

1

obtemos os elementos da diagonal

p

n

11

=

1

4

+

1

2

(1 2p)

n

+

1

4

(1 4p)

n

, p

n

22

=

1

2

+

1

4

(1 4p)

n

, p

n

33

= p

n

11

.

Desta forma

2.3 Tempos do primeiro retorno e da primeira chegada 21

G

11

(z) =

n0

z

n

_

1

4

+

1

2

(1 2p)

n

+

1

4

(1 4p)

n

_

=

1

4(1 z)

+

1

2(1 z(1 2p))

+

1

4(1 z(1 4p))

,

e logo utilizando os resultados do Lema 2.2,

k

1

1

= H

1

(z)

z=1

=

16p

4

4p

4

= 4,

o qual tambem e o valor de k

3

3

. Analogamente para p

n

22

, temos

G

22

(z) =

n0

z

n

_

1

2

+

1

2

(1 4p)

n

_

=

1

2(1 z)

+

1

2(1 z(1 4p))

,

portanto

k

2

2

= H

2

(z)

z=1

=

8p

2

4p

2

= 2.

Para a cadeia denida por (b) procedemos da mesma forma. Neste caso os autovalores sao

1,1, i(2p 1), e i(2p 1), logo

p

n

jj

=

1

4

_

1 + (1)

n

+ (i(2p 1))

n

+ (i(2p 1))

n

_

,

para qualquer j = 1, 2, 3, 4; e entao nalmente do Lema 2.2,

k

1

1

= k

2

2

= k

3

3

= k

4

4

= 4.

2.3.1 Exerccios

Exerccio 2.16. Uma cadeia de Markov com espaco de estados {1, 2, 3} apresenta a seguinte

matriz de probabilidade de transi cao

P =

_

_

1

3

1

3

1

3

0

1

2

1

2

0 0 1

_

_

.

Mostre que o estado 3 e absorvente. Dado que X

0

= 1, encontre o tempo esperado ate

absorcao.

Exerccio 2.17. Uma moeda honesta e lancada repetidas vezes. Calcule o n umero esperado

de lancamentos ate aparecer a sequencia {cara, coroa, cara} pela primeira vez.

Exerccio 2.18. (i) Calcule a probabilidade da sua runa sendo que o seu capital inicial e i,

isto e calcule h

0

i

, mas agora suponha que voce se encontra jogando contra uma outra pessoa

com capital inicial j = a i. (ii) Calcule a probabilidade da runa do seu oponente.

Exerccio 2.19. Responda a pergunta (vii) formulada no exemplo 2.1.

Exerccio 2.20. Considere o enunciado do exerccio 2.18 e neste caso (i) calcule o tempo

esperado da sua runa. (ii) Calcule o tempo esperado da runa do seu oponente.

22 2 Tempo discreto

Exerccio 2.21. Este exerccio e uma continuacao do exerccio exerccio 2.3. Qual e o

n umero medio de meses no qual uma conta do tipo A permanecera no sistema? (isto e,

o n umero de meses em media para que esta vire do tipo F ou B.)

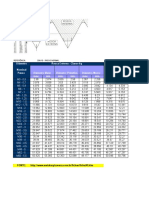

Exerccio 2.22. Um tabuleiro apresenta nove quadros, duas escadas, e duas cobras dispos-

tas de acordo ao desenho na gura 2.1. Suponha que voce inicia o jogo no quadro 1, e logo

em cada turno voce joga uma moeda (honesta) de tal maneira que se o resultado e cara

entao voce avanca dois quadros, mas se o resultado e coroa voce avanca so um quadro. Se

voce se encontra com o pe de uma escada voce imediatamente sobe ate o nal dela, mas se

voce se encontra com a cabeca de uma cobra voce desce ate o nal da cauda. (i) Quantas

turnos sao necessarios em media para chegar ate o quadro 9? (ii) Qual a probabilidade de

que um jogador que tenha chegado ate ao quadro 5 consiga chegar ate o 9 sem voltar ate o

quadro 1? (iii) Calcule a quantidade de turnos esperados se em lugar de uma moeda agora

e utilizado um dado de tal forma que voce avanca n quadros quando a face superior e n.

Figura 2.1. Serpentes e escadas. A origem deste jogo remonta-se a 200 A.C., estando

possvelmente relacionado ao jogo hindu de nome Moksha-Patamu. Este ultimo foi utilizado por

lideres religiosos para ensinar a diferenca entre o bem e o mal para as criancas. A versao atual foi

popularizada na Inglaterra Vitoriana ao redor de 1890.

Exerccio 2.23. Seja (X

n

)

n0

Markov em {0, 1, 2, . . .} com matriz de transicao denida

por

p

0j

= a

j

se j 0, p

ii

= r, p

i,i1

= 1 r se i 1.

Encontre o valor esperado dos tempos de retorno.

2.4 Propriedade forte de Markov

Um avanco signicativo na teoria e conseguido ao considerar eventos do tipo

{X

T+1

, . . . X

T+n

| X

T

= i, . . . , X

0

= i}

para o instante aleatorio T(), em lugar de

{X

m+1

, . . . X

m+n

| X

m

= i, . . . , X

0

= i}

onde m e um instante xo determinado a priori

2.4 Propriedade forte de Markov 23

Denicao 2.14. A variavel aleatoria T : {0, 1, . . .} {} e um tempo de parada para

o processo X, se o evento {T = m} so depende de X

0

, . . . , X

m

.

Exemplo 2.7. Seja X um processo aleatorio com valores em S. (i) O primeiro tempo de

retorno ao estado i,

i

, e um tempo de parada para X uma vez que

{

i

= n} = {X

0

= i, X

1

= i, . . . , X

n1

= i, X

n

= i}.

(ii) O primeiro tempo de chegada a i,

i

, tambem e um tempo de parada para X. (iii) O

ultimo tempo de sada de A S,

A

= sup{n 0 : X

n

A}

nao e um tempo de parada para X, ja que {

A

= n} claramente depende do evento {X

n+m

A : m 1}.

A propriedade de Markov ainda e valida se variavel aleatoria T e um tempo de parada. O

ponto crucial e observar que se B e um evento determinado por X

0

, . . . , X

T

, entao B{T =

m} esta determinado por X

0

, . . . , X

m

.

Teorema 2.8 (Propriedade forte de Markov). Seja X Markov(, P) e B um evento

determinado por X

0

, . . . , X

T

. Dado o evento {T < , X

T

= i}, o processo (X

T+n

), n 0,

e Markov(

i

, P) e independente de X

0

, . . . , X

T

.

Demonstracao. Seja B = {X

0

, . . . , X

T

} entao B {T = m} esta determinado por

X

0

, . . . , X

m

. Agora

P({X

T

= j

0

, . . . , X

T+n

= j

n

} {B, T < , X

T

= i})

=

m0

P({X

T

= j

0

, . . . , X

T+n

= j

n

} {B, T = m, X

T

= i}),

logo

P(X

T

= j

0

, . . . , X

T+n

= j

n

, B| T < , X

T

= i)

=

m0

P(X

T

= j

0

, . . . , X

T+n

= j

n

, B, T = m, X

T

= i)

P(T = m, X

T

= i)

1

,

mas se T = m, entao X

T

= X

m

. Desta forma temos que

m0

P(X

m

= j

0

, . . . , X

m+n

= j

n

, X

0

, . . . , X

m

, T = m, X

m

= i)P(T = m, X

m

= i)

1

=

m0

P(X

m

= j

0

, . . . , X

m+n

= j

n

| X

0

, . . . , X

m

, X

m

= i, T = m)

P(X

0

, . . . , X

m

, X

m

= i, T = m)P(T = m, X

m

= i)

1

,

assim, da propriedade fraca de Markov,

m0

P(X

m

= j

0

, . . . , X

m+n

= j

n

| X

m

= i)P(X

0

, . . . , X

m

| T = m, X

m

= i).

Da homogeneidade do processo, conclumos portanto que

P

i

(X

0

= j

0

, . . . ,X

n

= j

n

)

m0

P(X

0

, . . . , X

m

| T = m, X

m

= i)

= P

i

(X

0

= j

0

, . . . , X

n

= j

n

)P(B| T < , X

T

= i).

24 2 Tempo discreto

0

i

i

1

i

5

i

E

1

i

E

2

i

E

3

i

E

4

i

E

5

i

E

6

i

Xn()

Figura 2.2. tempos de excursao e do primeiro retorno a i.

2.5 Recorrencia e transitoriedade