Академический Документы

Профессиональный Документы

Культура Документы

Cuadrados Minimos

Загружено:

Aquim ChinchillaАвторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Cuadrados Minimos

Загружено:

Aquim ChinchillaАвторское право:

Доступные форматы

Nociones sobre cuadrados mnimos

por Dr. Horacio Bruzzone

1. Introduccin

Supongamos que, a travs de una serie de mediciones, se han determinado un

conjunto de n pares de valores de dos magnitudes fsicas, X e Y, asociadas a un cierto

fenmeno. Es decir, se tiene el siguiente conjunto de datos experimentales:

{x

i

t x

i

, y

i

t y

i}

; i = 1 hasta n

Supongamos adems que hay motivos suficientes como para conjeturar que

existe una relacin funcional lineal entre X e Y (si la relacin funcional es ms

compleja, lo que sigue puede an aplicarse de varias maneras), es decir:

Y = a+ bX

En este caso, cabe plantearse un doble problema: me permiten mis datos

afirmar que la relacin lineal es correcta (al menos dentro del rango de valores

medidos)? Y, supuesto que esto tiene respuesta afirmativa como determino los

parmetros a y b, y cuales son sus incertezas?

La tcnica ms usual para responder a esas preguntas, desarrollada

originalmente por Gauss, se conoce como el mtodo de ajuste por cuadrados mnimos,

y se basa en lo que sigue.

Sean a y b los valores que se quieren encontrar. Para cada par de datos x

i

,y

i

,se

define la cantidad: d

i

= y

i

-(a+bx

i

). Es intuitivo ver que, si la relacin es efectivamente

lineal, y los a y b son los correctos, cada d

i

debe ser pequeo (luego precisaremos

mejor esto). No podemos esperar que sean cero, porque hay incertezas de medicin

tanto en X como en Y, pero lo razonable es esperar que, si los valores de a y b

elegidos son los que corresponden a la recta buscada, todos los d

i

sean chicos. Como

criterio que satisface esto, se puede proponer que la suma de los d

i

sea mnima (en

realidad, esto da el criterio para evaluar a y b). Sin embargo, la suma simple no es

buen criterio, porque los d

i

pueden ser positivos y negativos, y cancelarse mutuamente

haciendo que la suma sea mnima aunque los d

i

sean grandes en mdulo. Para evitar

este problema, se pueden sumar los mdulos o, lo que es ms conveniente, los d

i

elevados al cuadrado. Entonces, la primera aproximacin del mtodo consiste en

elegir los valores de a y b que minimizan a la suma:

'

d

i

i

n

2

1

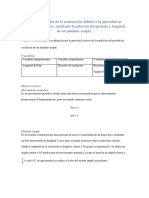

2. Cuadrados mnimos ponderados

Antes de ver como se obtienen a y b usando ese proceso de minimizacin,

vamos a dar un paso ms para decidir que suma minimizar. Para ello, vamos a

suponer (de momento arbitrariamente, luego se precisar esto) que los errores de la

magnitud X son despreciables frente a los errores de Y. Ntese, de paso, que d

i

es la

distancia, en la direccin del eje y, entre y

i

y el valor y

i

(= a + bx

i

) que es la

coordenada y del punto de la recta buscada cuya abcisa es x

i

. Es claro que, si los x

i

no tienen error; es cierto que la relacin es lineal y que sus parmetros son a y b,

entonces las diferencias entre y

i

e y

i

son nicamente atribuibles a los errores en los y

i

.

Pero si estos errores son distintos entre si, parece sensato realizar el procedimiento de

minimizacin asignando una mayor importancia a los d

i

provenientes de valores de

los y

i

que tengan errores ms chicos. Esto se logra por el procedimiento de

ponderar, que consiste en multiplicar a cada d

i

por una cantidad que sea mayor

cuanto ms pequeo sea el correspondiente y

i

. La forma ms sencilla de hacer esto

es dividir a cada d

i

por y

i

: cuanto menor es el error, mayor es el coeficiente que

tiene el d

i

. Usando este criterio, lo que se debe minimizar es:

_

,

_

,

d

y

y a bx

y

i

i

i

n

i i

i

i

n

1

2

1

2

Al mtodo de obtencin de a y b usando la minimizacin de se lo llama

cuadradados mnimos ordinarios, mientras que al que minimiza a se lo llama

cuadrados mnimos ponderados. Como la tcnica de minimizacin es comn,

describiremos slo la de cuadrados mnimos ponderados.

Una parte considerable del problema original que tenemos planteado consiste

en responder a esta pregunta: dados n valores de x

i

,y

i

, y y

i

cuales son los valores

de a y b que minimizan a ? El anlisis matemtico ensea que son la solucin del

siguiente sistema de ecuaciones:

a b

0 0 ;

Haciendo esas derivadas se obtiene:

a a

y a bx

y a

y a bx

y

y a bx

y

b b

y a bx

y

x

y a bx

y

i i

i

i

i i

i

i

i i

i

i

i i

i

i

i

i i

i

i

_

,

_

,

_

,

_

,

_

,

2 2

2

2

2

2 0

2 0

Desarrollando las sumatorias, y definiendo (para simplificar notacin):

S

y

S

x

y

S

y

y

S

x

y

S

y

y

S

x y

y

i

x

i

i

y

i

i

xx

i

i

yy

i

i

xy

i i

i

1

2 2 2

2

2

2

2 2

( )

;

( )

;

( )

( )

;

( )

;

( )

el sistema de ecuaciones se escribe como:

S aS bS

S aS bS

y x

xy x xx

0

0

cuya solucin es:

( ) ( )

b

SS S S

SS S

b

S

SS S

a

S S S S

SS S

a

S

SS S

xy x y

xx x xx x

xx y x y

xx x

xx

xx x

2

2

2 2

2

2

; ; ;

Tambin se han agregado expresiones para las incertezas de a y b. No se dar aqu el

detalle de su clculo, basta comentar que se obtienen de las expresiones de a y b,

propagando los errores y

i

, que afectan a cada y

i

que aparece en las sumatorias (

( ) a

a

y

y

j

j

j

2

2

_

,

y otra equivalente para b).

3. Confiabilidad

Queda todava por contestar la pregunta de si los datos permiten

confiablemente asumir que las variables X e Y guardan una relacin lineal. Este tema

est un poco confuso en la literatura, y es frecuente encontrar que el criterio para

sostener la relacin lineal es que un coeficiente, r

2

, llamado coeficiente de correlacin

de los datos y definido como sigue:

r

SS S S

SS S SS S

xy x y

xx x yy y

2

2

2 2

( )

( )( )

sea suficientemente cercano a 1. Haciendo un poco de maniobras algebraicas, se

puede demostrar que si r

2

=1, entonces todos los puntos (x

i

, y

i

) estn alineados en una

recta. Obviamente, si se cumple esa condicin, la relacin lineal queda asegurada.

Pero el problema es que no se puede decir nada cuando r

2

es menor que 1, en el

sentido que no hay criterio slido para saber que es cercano a 1.

Existe un criterio ms elaborado, que es aplicable cuando los errores en Y son

de naturaleza puramente estadstica (y gaussiana). Su derivacin es bastante

complicada, y requiere el uso de teora estadstica, por lo que no se dar en este curso.

Por otra parte, la mdula de la argumentacin empleada en ese criterio es extensible a

casos no estadsticos, y la discutiremos a continuacin.

Ya se mencion que, grficamente, d

i

es la distancia en la direccin del eje y

entre el dato i-simo y la recta obtenida usando el mtodo de cuadrados mnimos (es

decir, aquella determinada por los valores de a y b que se obtienen del mtodo). Por lo

tanto, d

i

/ y

i

es una medida de cuanto vale esa distancia comparada con el error en

Y en ese punto. Supongamos que los errores en Y son de naturaleza instrumental. Es

claro que, si ese cociente es menor o igual que 1, para ese dato particular, se puede

decir que el punto pertenece (experimentalmente) a la recta. Si los errores fueran

estadsticos gaussianos, esta condicin no es suficiente, porque hay una probabilidad

respetable (33%) de que el valor medio utilizado para y

i

caiga fuera del intervalo

definido por una dispersin, y en estos casos se debera agregar un intervalo de

probabilidad en esa condicin. Dejando de lado este problema, consideremos ahora

que pasa con el conjunto de datos. En principio, es posible que algunos de los puntos

tengan ese cociente menor que 1 mientras que otros lo tengan mayor que 1. Parece

razonable usar como criterio para decidir si se acepta o no la relacin lineal el que la

mayora de los puntos satisfaga esa condicin. Y esto se puede hacer sencillamente

calculando el valor que toma , una vez calculados a y b. En efecto, es la suma de

los cuadrados de esos cocientes, de modo que /n es el valor medio de ese cuadrado.

Luego, ( /n)

1/2

es una estimacin de cuanto vale el promedio de los d

i

/ y

i

, y si

resulta ser menor o igual que 1, la relacin lineal debe ser aceptada; si es mucho

mayor que 1, debe ser rechazada. Entre el valor 1 y mucho mayor que 1 queda un

margen de indecisin (entre otras cosas, en decidir cuanto es mucho). La ventaja de

la teora estadstica mencionada ms arriba consiste en que, haciendo una

comparacin que es substancialmente equivalente, da resultados en trminos de

probabilidades para cualquier valor que se obtenga en la comparacin. Con todo, el

criterio expuesto aqu tiene la ventaja de ser sencillo de entender y vlido para

cualquier tipo de errores.

Que relacin tiene esto con el r

2

? Si se reemplazan los resultados de a y b

dados ms arriba en la expresin de , y se usa la definicin de r

2

, haciendo un poco

de maniobras algebraicas se encuentra que:

( )( / ) 1

2 2

r S S S

yy y

en donde se ve que si r

2

vale 1, es cero y por tanto, el criterio dado anteriormente

se satisface. Sin embargo, el hecho que r

2

sea cercano a 1 (=0,95, por ejemplo) no

alcanza para garantizar que sea pequeo (menor o del orden de n) porque el otro

factor (S

yy

- S

y

2

/S) es habitualmente un nmero mucho mayor que 1.

Todava no se dijo nada sobre n, el nmero de datos. Si los datos fueran slo 2,

es obvio que determinan un nico valor de pendiente y ordenada al origen, y

consecuentemente, =0. Pero tambin es claro que, con slo dos datos, no se puede

pretender asegurar una relacin lineal entre las variables X e Y. Tambin es claro que,

cuantos ms datos se tengan, mayor confianza se puede tener en determinar la

existencia (o inexistencia) de una relacin lineal. En un tratamiento estadstico existen

criterios adicionales sobre el nmero de datos requeridos, pero para lo que nos

interesa ac basta decir que un mnimo razonable para n es n = 10. De todos modos,

hay que agregar otra consideracin: no basta con tener un valor de n razonable; es

necesario adems que los rangos de valores de X e Y cubiertos por los datos sean

tambin razonables, al menos que cubran un orden de magnitud. Ntese que, en un

rango de valores relativamente pequeo, cualquier funcin puede ser bien aproximada

por una recta.

Una vez llegados a este punto, tambin puede verse cual es la diferencia

esencial entre el mtodo de cuadrados mnimos ponderados y el ordinario. El

ponderado admite dar un criterio para aceptar o no la hiptesis lineal, el ordinario no,

porque an que se pueda definir en l un coeficiente equivalente al r

2

, hemos visto que

esto no sirve para garantizar la hiptesis lineal. Es frecuente encontrar en calculadoras

de mano y en paquetes de computacin mtodos de correlacin lineal que, ante un

conjunto de datos x

i

, y

i

dan valores de a, b, r

2

, e incertezas de a y b. Todos estos

programas usan cuadrados mnimos ordinarios, y como no tienen incertezas en los

datos Y, asumen que estas incertezas son constantes e iguales a [ /(n-2)]

1/2

, usando

este valor en las frmulas de propagacin. Pero, salvo el que dividen por n-2 en lugar

de dividir por n (debido a razones estadsticas), lo que estn usando como error en Y

es la distancia promedio a la recta, y se pierde as toda posibilidad de dar un criterio.

En efecto, este mtodo supone que esos apartamiento de la recta son debidos a un

error, en lugar de compararlos con los errores de medicin. Este uso puede ser

aceptable en algunas disciplinas (ciencias sociales, por ejemplo, en las que no es fcil

ni habitual determinar errores), pero de ningn modo es aceptable en fsica, en donde

cada dato debe conocerse con su error.

4. Errores en las dos variables

Acabamos de mencionar la importancia y conveniencia de incluir los errores

de los datos en el mtodo de cuadrados mnimos. Y nos queda pendiente la discusin

de que criterio usar para decidir que una de las variables tiene errores despreciables,

que es lo que justifica el tratamiento anterior. El modo de aclarar este punto es

replantear el problema para el caso general de errores en ambas variables, cosa que es

relativamente nueva (D. York, Canadian Journal of Physics, 44 (1966) p. 1079,

completado por J. Williamson, Canadian Journal of Physics, 46 (1968) p. 1845, y con

trabajos hasta la fecha que aclaran y mejoran el mtodo). A continuacin se dar un

resumen de las ideas en las que se basa.

Hay dos cosas que modificar en el tratamiento anterior: una es incluir en los

factores de peso a los x

i

, la otra es modificar consistentemente la distancia a la

recta que se usa. Es claro que ya no se justifica minimizar la distancia en y (porque

no en x?), y la solucin es minimizar la distancia perpendicular a la recta. Sea d

i

esa

distancia (va a depender de la pendiente b, porque la pendiente de la recta

perpendicular es -1/b y tambin de los valores x

i

e y

i

), por analoga al caso anterior, se

eligen los pesos como los d

i

evaluados propagando los errores x

i

y y

i

(notar

que con la definicin anterior de d

i

, y

i

es su error si no hay error en x). Este clculo

es sencillo, y se obtiene la siguiente sumatoria a minimizar:

2

2

2 2

( )

( ) ( )

y a bx

y b x

i i

i i

i

El efecto final (engaoso) es el de minimizar la suma de los viejos d

i

2

pero dividos por

coeficientes que incluyen el error en x. Ntese que ahora aparece un nuevo trmino

que depende de b en el denominador, por lo que al derivar e igualar a cero, las

ecuaciones sern ms complejas. De hecho, en el caso general de errores todos

distintos entre si, no hay solucin analtica para a y b, sino que deben obtenerse

soluciones en forma numrica. En cambio, las incertezas de a y b si tienen soluciones

analticas (pero muy arduas de calcular), supuesto que se conocen a y b.

En lo que sigue, nos limitaremos a un caso ms sencillo, llamado de errores

proporcionales ( x

i

/ y

i

= constante para todo i). Esta limitacin se adopta porque

permite disponer de soluciones analticas, y sin perder generalidad, permite entender

que significa que uno de los errores sea despreciable.

Llamando d al cociente de errores podemos escribir

2

en la forma:

2 2 2

2

2

1

1

b d

y a bx

y

i i

i

( )

( )

Siguiendo el mismo procedimiento que en el caso anterior, se forma un

sistema de 2 ecuaciones para a y b, que pueden ser despejados y resulta una ecuacin

cuadrtica para b, cuyas soluciones son:

db

db

db

r db

db

r r

a

S

S

S

S

b

y

x

+

+ +

+ t + +

1

]

1

, , ,

( )

( )

;

1

2

1 1

4

2

2 2

2

4 2

en donde se ha llamado b* a la solucin ya conocida del caso ponderado y r

2

tambin

es el del caso ponderado, lo mismo que las sumatorias S que aparecen en a

+,-

. Para

decidir cual signo tomar en la solucin, hay que hacer un anlisis de cual solucin es

un mnimo y cual un mximo. Se encuentra que esto depende del signo de b*: si b* es

positivo, se debe tomar el signo + de la raz y viceversa.

Tomaremos en adelante la solucin b

+

y, para simplificar escritura, en lo que

sigue se usa esa raz sin el subndice. Tambin se pueden calcular las incertezas de

estas soluciones, y se obtiene:

[ ]

b

b

a

a

f b b d r b d f b b d r f b b d r

b d

S

donde f b b d r b d

b d r

d bb b r

2 2 2 2 2 2 2 2 2

2 2

2 2 2 2

2 2 2

2 2 2

2

1 1

1

1

1

1 2

+ +

+

+

+

+

( , , , ) ; ( ) ( , , , ) [ ( , , , )]

( , , , ) ( )

/

( / )

De estas expresiones se puede ver que, en el lmite d0, bb* (basta sacar

factor comn 1/(b*d)

2

en la raz y desarrollar en serie); aa* ; y como f1, las

incertezas tienden a las clsicas. Tambin se puede ver que si r

2

1, bb* y aa*

pero ahora las incertezas se modifican, resultando:

a b

a b

d b

,

,

( )

2 2 2 2

1 +

es decir, son mayores que las del caso clsico. Ntese que el incremento relativo de

las incertezas es proporcional a (db*)

2

= (b* x

i

/ y

i

)

2

. Como las incertezas clsicas

son, substancialmente, proporcionales a una especie de valor medio de ( y

i

)

2

, lo que

esto dice es que se debe agregar otro trmino que es substancialmente proporcional a

b* multiplicado por una especie de valor medio de ( x

i

)

2

, lo cual es razonable. Por

otro lado, esto pone en evidencia que criterio se debe usar para decir que un error es

ignorable (o suficientemente pequeo) comparado con el otro: lo que cuenta no es que

d sea chico, sino que db* lo sea. Dicho de otra forma, el modo de asegurar a priori si

los errores en alguna de las variables son despreciables ( para errores proporcionales)

consiste en estimar aproximadamente la pendiente de la recta y luego comparar los

y con el producto de esa pendiente con los x. Si resulta y mucho mayor, los

x son ignorables; si mucho menor, los y son ignorables, si son del mismo orden,

entonces se deben incluir ambos.

Вам также может понравиться

- Resumen NII7 Instrumentos FinancierosДокумент1 страницаResumen NII7 Instrumentos Financierosariel502010Оценок пока нет

- Form. y Evaluacion de ProyectosДокумент9 страницForm. y Evaluacion de ProyectosAquim ChinchillaОценок пока нет

- EjemploДокумент303 страницыEjemploJuan Carlos Amores GuevaraОценок пока нет

- 337 Lectura6.2Документ37 страниц337 Lectura6.2hundel01Оценок пока нет

- Constitucion SociedadДокумент3 страницыConstitucion SociedadAquim ChinchillaОценок пока нет

- MercadoaralДокумент14 страницMercadoaralAquim ChinchillaОценок пока нет

- Impuesto Selectivo Al Consumo - Derecho RioДокумент9 страницImpuesto Selectivo Al Consumo - Derecho RioAquim ChinchillaОценок пока нет

- Leyes de Exponentes y LogaritmosДокумент8 страницLeyes de Exponentes y LogaritmosAquim Chinchilla100% (3)

- DOC7207Документ2 страницыDOC7207Aquim ChinchillaОценок пока нет

- Modelo de La Ruta Mas CortaДокумент10 страницModelo de La Ruta Mas CortaGabriela Altamirano OropezaОценок пока нет

- Informe Lab FIS 102 Practica 02.odtДокумент16 страницInforme Lab FIS 102 Practica 02.odtCristian R. Medrano ArancibiaОценок пока нет

- Simulacro 2. Con RespuestasДокумент1 страницаSimulacro 2. Con RespuestasLineth Margarita Sanchez HernandezОценок пока нет

- Ecuacion de Una RectaДокумент1 страницаEcuacion de Una RectaÉrika RuedaОценок пока нет

- Radiaciones Ionizantes I X OrtegaДокумент462 страницыRadiaciones Ionizantes I X OrtegajpmafrОценок пока нет

- Laboratorio Perdidas Por Fricción de Una TuberiaДокумент15 страницLaboratorio Perdidas Por Fricción de Una TuberiaJuan CuevasОценок пока нет

- Fuerza Electromotriz Y Potencial Estándar.: Celdas ElectroquímicasДокумент22 страницыFuerza Electromotriz Y Potencial Estándar.: Celdas ElectroquímicasDan CheshireОценок пока нет

- Motores MonofásicosДокумент2 страницыMotores MonofásicosSamuel Jhonatan Montalvo BardalesОценок пока нет

- Caja FullerДокумент5 страницCaja FullerEdu Cristian Calle Morocho0% (1)

- 2-Fibras Concretos Fibroreforzados OgДокумент80 страниц2-Fibras Concretos Fibroreforzados OgjorsucaОценок пока нет

- Practica No5Документ5 страницPractica No5Ulises vargasОценок пока нет

- Planeaciones EEYM U3 19 2Документ17 страницPlaneaciones EEYM U3 19 2Gianfranco PontecorboОценок пока нет

- Pavimentos Rígidos JallloranaДокумент16 страницPavimentos Rígidos JallloranaBryan Jallorana MarcatincoОценок пока нет

- INTELLI - Grapas Conectores y VarillasДокумент2 страницыINTELLI - Grapas Conectores y VarillasSantiago PazОценок пока нет

- Analisis VectorialДокумент22 страницыAnalisis VectorialMiguel Perez RОценок пока нет

- Exposicion Fusibles y DisyuntoresДокумент9 страницExposicion Fusibles y Disyuntoresbam_bamОценок пока нет

- LM75 TechData Spanish March 14 2014 (AppReady) PDFДокумент8 страницLM75 TechData Spanish March 14 2014 (AppReady) PDFjonathan fuentesОценок пока нет

- 2.1.1. Crecimiento Deoxido de Grove - DealДокумент41 страница2.1.1. Crecimiento Deoxido de Grove - DealladycharlotОценок пока нет

- Cinemática Vectorial - Conceptos BásicosДокумент23 страницыCinemática Vectorial - Conceptos BásicosjnzhrjОценок пока нет

- Tema #9.0. - Analisis Dinamico Modal Espectral.Документ31 страницаTema #9.0. - Analisis Dinamico Modal Espectral.Saydi iris CarrascoОценок пока нет

- Laboratorio Pendulo SimpleДокумент9 страницLaboratorio Pendulo SimpleSEBASTIAN BASILIO DE LA CRUZ HUANCARUNAОценок пока нет

- MagnitudesДокумент4 страницыMagnitudesALEX F. C. ZAMORAОценок пока нет

- TEMA 7 Baleo y Sus ObjetivosДокумент11 страницTEMA 7 Baleo y Sus ObjetivosDeymar Luk CortezОценок пока нет

- (Química 2º Bachillerato) Ejercicios + Soluciones: Equilibrio Químico y Cinética QuímicaДокумент29 страниц(Química 2º Bachillerato) Ejercicios + Soluciones: Equilibrio Químico y Cinética QuímicaÁlvaro S.91% (11)

- Ads 5 2006 Eo B Bases IntegradasДокумент15 страницAds 5 2006 Eo B Bases IntegradasJoelcito Pillco AlarconОценок пока нет

- EquilibrioДокумент9 страницEquilibrioMeryLoyolaОценок пока нет

- Dario Universidad Nacional de San Cristóbal de HuamangaДокумент38 страницDario Universidad Nacional de San Cristóbal de HuamangaRomel Canchari GutierrezОценок пока нет

- Metodologia para El Diseño de MaterialesДокумент263 страницыMetodologia para El Diseño de MaterialescarlosvargassanchezОценок пока нет

- 02 Cap. Ii Calculos RPДокумент33 страницы02 Cap. Ii Calculos RPJhenzo Rocca100% (1)

- Asfalto en Frio PDFДокумент68 страницAsfalto en Frio PDFEdwin Carpio MedinaОценок пока нет