Академический Документы

Профессиональный Документы

Культура Документы

Cadenas de Markov Finitas Introducción

Загружено:

Eliza H. AguilarОригинальное название

Авторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Cadenas de Markov Finitas Introducción

Загружено:

Eliza H. AguilarАвторское право:

Доступные форматы

CADENAS DE MARKOV

1. Introduccin.

2. Definicin de proceso estocstico.

3. Realizacin de un proceso

estocstico.

4. Clasificacin de los procesos

estocsticos.

5. Ejercicios

Objetivos

3. Conocer los tipos de Procesos

Estocsticos.

1. Definir matemticamente que es un

Proceso Estocstico.

2. Conocer que es una realizacin de un

Proceso Estocstico.

4. Aplicar los conceptos aprendidos en

clase.

Procesos de Markov Finitos

1. Introduccin.

2. Cadena de Markov.

3. Probabilidad de Transicin de un Paso.

4. Probabilidad de Transicin Estacionarias.

5. Matriz de Probabilidades de Transiciones de un

Paso.

6. Probabilidades de Estado Inicial del Proceso.

7. Proposiciones.

8. Diagrama de Transiciones.

II. Procesos de Markov Finitos. Intro.

Las cadenas de Markov

fueron inventadas por el

matemtico ruso Andrei

Andreevitch Markov alrededor

de 1905 que las introdujo en

1917. Su intencin era crear

un modelo probabilstico para

analizar la aparicin de

vocales en poemas y textos

literarios.

II. Procesos de Markov Finitos. Intro.

Las cadenas de

Markov pueden aplicarse

a una amplia gama de

fenmenos cientficos y

sociales, y se cuenta con

una teora matemtica

extensa al respecto.

II. Cadenas de Markov de Tiempo

Discreto

Definicin 2. Un proceso estocstico {X

n

, nT}

es una cadena de Markov de tiempo discreto

si:

i) Tiene un espacio de estados S discreto,

esto es S={0,1,2,3,}

ii) Tiene un espacio paramtrico de tiempo T

discreto, es decir T={0,1,2,3,} y

iii) Cumple la propiedad markoviana

Un proceso estocstico tiene la propiedad markoviana si las

probabilidades de transicin en un paso slo dependen del

estado del sistema en el perodo anterior (memoria limitada)

Propiedad Markoviana

Si consideramos el tiempo (n+1) como el

tiempo futuro, el tiempo n como el presente y

los tiempos 0, 1, , n-1 como el tiempo

pasado, entonces (1) establece que la

distribucin de probabilidad del estado del

proceso en el tiempo futuro (n+1) depende

nicamente del estado del proceso en el tiempo

presente n, y no depende de los estados del

proceso en los tiempos pasados 0, 1, . . . , n1.

II. Cadenas de Markov de Tiempo

Discreto

Proposicin 1. Para una cadena de Markov

{X

n

, nT} se cumple que

Demostracin

Aplicando la distribucin conjunta al lado

izquierdo de la igualdad (2) y aplicando (1)

tenemos

II. Cadenas de Markov de Tiempo

Discreto

(2)

P(X

0

=i

o

, X

1

=i

1

, ,X

n

=i)=

A la probabilidad P(X

n+1

=j/X

n

=i) se le denota

como P

ij

(n,n+1)

,es decir P(X

n+1

=j/X

n

=i)=P

ij

(n,n+1)

y

representa la probabilidad de transicin de ir

del estado presente i al estado futuro j en un

paso o periodo. Cuando las P

ij

(n,n+1)

no

dependen de n se dice que las probabilidades

de transicin son estacionarias u homogneas

en el tiempo y P

ij

(n,n+1)

se representa por P

ij

, es

decir P

ij

(n,n+1)

=P

ij

2.1. Probabilidades de transicin de

un paso

P

(n)

es la matriz de transicin en n pasos, de orden (M+1)x(M+1)

Propiedad Markoviana

Las probabilidades de transicin P

ij

de un

paso estn representadas en una matiz en una

matriz P=[P

ij

] i,jS con S={0,1,2,,n}discreto y

finito, llamada matriz de probabilidades de

transicin de un paso o matriz de Marvok

Continuacin:

Hallar la matriz de transicin:

Ejemplo: Ruina del Jugador

4

3

2

1

0

4 3 2 1 0

P

Suponga que se producen 2 colas (1 y 2). Si un cliente

compra la cola 1, hay 90% que la siguiente compra sea cola

1. Si compra cola 2, hay una probabilidad de 80% que la

prxima compra sea cola 2.

a) Si actualmente una persona es comprador de cola 2.

Cul es la prob. que compre cola 1 pasadas 2 compras

a partir de hoy?

b) Si actualmente una persona es comprador de cola 1.

Cul es la prob. que compre cola 1 pasadas 3 compras

a partir de ahora?

c) Supongamos que el 60% de toda la gente toma hoy cola

1 y el 40% cola 2. A tres compras a partir de ahora. Qu

fraccin de los compradores estar tomando cola 1?

Ejemplo: Produccin de bebidas

Tipos de modelos de Markov:

Procesos de Markov (Modelos semi-

markovianos): Las probabilidades de transicin

entre estados pueden variar a medida que

transcurren ms ciclos

Ejemplo: para modelizar la esperanza de vida, el riesgo

de muerte aumenta con la edad

Cadenas de Markov: Las probabilidades de

transicin se suponen constantes a lo largo del

tiempo

Las Cadenas de Markov

Ejemplo 1. Sea una cadena de Markov X

n

,

nT con S= 0, 1,2 y con la siguiente matriz

de probabilidades de transicin.

Determinar

Ejemplo 2.

Supongamos que un insecto se desplaza a

travs de los puntos que han sido marcados en

un crculo (ver Figura 1). La forma en que se

desplaza el insecto sobre el crculo es a travs

de saltos que da en cada punto marcado en un

momento del tiempo medido en minutos.

Figura 1. Posibles puntos de

ubicacin del insecto sobre el

circulo.

El insecto, tiene la probabilidad p de moverse a

la derecha y 1-p de moverse a la izquierda.

Supongamos, adems, que el insecto inicialmente

se encuentra en el punto 1 y que al desplazarse

mira al centro del circulo.

a) Determinar X

n

b) El espacio de estados S

c) El espacio parametrico T

d) La Matriz de probabilidades de transicin

En general puede considerarse que una

cadena de Markov inicia su evolucin

partiendo de un estado inicial i

cualquiera, o bajo una distribucin de

probabilidad inicial sobre el espacio de

estados S.

Una distribucin inicial para una cadena

de Markov con espacio de estados

S= 0, 1,2,, n

2.3. Distribucin de probabilidad del

estado inicial del proceso

S= 0, 1,2,, n

es simplemente una distribucin de

probabilidad sobre este conjunto, es

decir, una coleccin de probabilidades

que se denota por [P(X

0

=i

0

)]=[

0

(i

0

)]

iS que satisface las siguientes

condiciones:

2.3. Distribucin de probabilidad del

estado inicial del proceso

Entonces (2) es equivalente a

Esta igualdad establece que la cadena de

Markov se encuentra completamente

definida mediante la distribucin

inicial [

0

(i

0

)] y la matriz de

probabilidades de transicin P.

2.3. Distribucin de probabilidad del

estado inicial del proceso

Proposicin 3. Una cadena de Markov

X

n

,nT queda completamente definida si

son conocidas la matriz de

probabilidades P=[P

ij

] y la distribucin

de probabilidad inicial del proceso

[

0

(i

0

)] iS

2.3. Distribucin de probabilidad del

estado inicial del proceso

Ejemplo 3.

Sea una cadena de Markov X

n

,nT, con

S= 0,1,3 y con la siguiente matriz de

probabilidades P.

Es la representacin

mediante un grafo

dirigido de las

transiciones que se

dan entre los estados

i,jS de una cadena

de Markov. Una

transicin de i a j

se denota por ij o

de j a i se denota por

ji

2.4. Diagrama de transiciones

Figura 2. Transiciones

entre estados.

Ejemplo 4.

Elaborar el diagrama de transicin

entre estados de la siguiente matriz

Propiedad Markoviana

GRACIAS

Si Cuidamos el Medio

Ambiente, cuidamos a todos

nuestros seres queridos

Вам также может понравиться

- 1 Cadenas de Markov en Tiempo DiscretoДокумент36 страниц1 Cadenas de Markov en Tiempo DiscretoJuan Pablo UrreaОценок пока нет

- CMTD - Cadenas de Markov en Tiempo DiscretoДокумент35 страницCMTD - Cadenas de Markov en Tiempo DiscretoEljem Nefta100% (1)

- Cadenas de MarkovДокумент40 страницCadenas de MarkovAstrid SandovalОценок пока нет

- Cadenas de Marko-ResumenДокумент16 страницCadenas de Marko-ResumenArturo CLorcaОценок пока нет

- 2 Cadenas de MarkovДокумент43 страницы2 Cadenas de MarkovgustavobenitesОценок пока нет

- Unidad 4 Cadenas de MarkovДокумент19 страницUnidad 4 Cadenas de MarkovCristofer MagañaОценок пока нет

- Cadenas de MarkovДокумент10 страницCadenas de MarkovLUIS EMANUEL RAMOS ARZATEОценок пока нет

- Cadena de MarkovДокумент27 страницCadena de MarkovLeo MessiОценок пока нет

- Cadenas de Markov: procesos estocásticos con transiciones probabilísticasДокумент12 страницCadenas de Markov: procesos estocásticos con transiciones probabilísticasDanielaОценок пока нет

- Unidad 4 Cadenas de MarkovДокумент20 страницUnidad 4 Cadenas de MarkovCristhian PerezОценок пока нет

- R 66900Документ30 страницR 66900as_oleo_mys_ca100% (1)

- Tecnológico Nacional de México: PeríodoДокумент20 страницTecnológico Nacional de México: PeríodoWendy Estefania Saldivar CuervoОценок пока нет

- Cadenas de Markov 2010 IIДокумент129 страницCadenas de Markov 2010 IIroberto1809100% (3)

- 11a - Cadenas de Markov (Intro)Документ10 страниц11a - Cadenas de Markov (Intro)julissa milenaОценок пока нет

- Io2 1Документ23 страницыIo2 1Cristina Huañapaco GutierrezОценок пока нет

- Cadenas de MarkovДокумент29 страницCadenas de MarkovManuel Lara LopezОценок пока нет

- Inv - Ope.2 - UNIDAD IVДокумент22 страницыInv - Ope.2 - UNIDAD IVJonathan Millan RodríguezОценок пока нет

- Cadenas de Markov IO2Документ19 страницCadenas de Markov IO2canoconsultingОценок пока нет

- Cadenas de MarkovДокумент9 страницCadenas de MarkovDANITZA KATHERINE JUANEZОценок пока нет

- CADENAS DE MARKOV y Sus PropiedadesДокумент39 страницCADENAS DE MARKOV y Sus PropiedadesCarlittos CalderoneОценок пока нет

- Unidad 4 Cadenas de MarkovДокумент13 страницUnidad 4 Cadenas de MarkovJesus Esteban Cota DominguezОценок пока нет

- Mod Esto Unidad 04Документ59 страницMod Esto Unidad 04Enzo Karol VelásquezОценок пока нет

- Cadenas de MarkovДокумент67 страницCadenas de MarkovRicardoCamanSilva100% (1)

- Inv. Ope Ii U4Документ22 страницыInv. Ope Ii U4Victor Manuel Cruz Martinez100% (1)

- Ejercicios Procesos Estocasticos, Cadenas de Markov DiscretasДокумент4 страницыEjercicios Procesos Estocasticos, Cadenas de Markov DiscretasJUAN DAVID ALVAREZ GAMEZ100% (1)

- Conceptos Cadenas MarkovianasДокумент4 страницыConceptos Cadenas MarkovianasAndres RiveraОценок пока нет

- Cadenas de MarkovДокумент70 страницCadenas de Markovgers0n1100% (2)

- Cadenas de Markov en tiempo continuoДокумент12 страницCadenas de Markov en tiempo continuoSerchimanОценок пока нет

- 3 Cadenas Markov Procesos DiscretosДокумент184 страницы3 Cadenas Markov Procesos DiscretosCynthia0015Оценок пока нет

- Unidad 4 y 5Документ43 страницыUnidad 4 y 5Karla LiceaОценок пока нет

- Cadenas de Markov para determinar probabilidadesДокумент7 страницCadenas de Markov para determinar probabilidadesIan EstradaОценок пока нет

- Unidad 5 Procesos EstocásticosДокумент30 страницUnidad 5 Procesos EstocásticosLG LupОценок пока нет

- Cadenas de Markov: predicción de eventos económicosДокумент7 страницCadenas de Markov: predicción de eventos económicosFelix SantanaОценок пока нет

- Clase6 IOCadenasMarkovДокумент36 страницClase6 IOCadenasMarkovJuan Paredes Campos0% (1)

- Cadenas de Markov2Документ9 страницCadenas de Markov2Paola Andrea VelezОценок пока нет

- Unidad 5 - Cadenas de MarkovДокумент19 страницUnidad 5 - Cadenas de MarkovluisОценок пока нет

- Procesos EstocásticosДокумент41 страницаProcesos EstocásticosDanilo GutierrezОценок пока нет

- Cadenas markovNPJ PDFДокумент33 страницыCadenas markovNPJ PDFOchoa VictorОценок пока нет

- Cadenas de MarkovДокумент21 страницаCadenas de MarkovangieebiirofbОценок пока нет

- Cadena Markov PDFДокумент10 страницCadena Markov PDFManuel VásquezОценок пока нет

- Procesos Estocásticos 2019 PDFДокумент56 страницProcesos Estocásticos 2019 PDFstephanie leivaОценок пока нет

- Guía 1 Cadenas de MarkovДокумент3 страницыGuía 1 Cadenas de MarkovJim Robles GarcíaОценок пока нет

- MarcosMI Actividad1 Modulo3Документ53 страницыMarcosMI Actividad1 Modulo3Isael Marcos MatusОценок пока нет

- Capitulo I, Cadenas de Markov - FimgmДокумент64 страницыCapitulo I, Cadenas de Markov - FimgmMiguel Angel Gaytan MontesОценок пока нет

- Cadena-De-marko Abosorbent y Regular ConceptovДокумент19 страницCadena-De-marko Abosorbent y Regular ConceptovTeresa Estrada BarreyraОценок пока нет

- Cadena de Markov en ingeniería industrialДокумент18 страницCadena de Markov en ingeniería industrialEnrique GonzalezОценок пока нет

- Cadena de MarkovДокумент21 страницаCadena de MarkovEdzon Alberto Cervantes ZetinaОценок пока нет

- Trabajo de Procesos Estocásticos IIIДокумент10 страницTrabajo de Procesos Estocásticos IIILening SegoviaОценок пока нет

- Markov - Matriz de Probabilidades de TransicionДокумент8 страницMarkov - Matriz de Probabilidades de TransicionANDRICK BOUCHOT NAVARROОценок пока нет

- Cadenas de Markov en tiempo continuo: definición e importanciaДокумент3 страницыCadenas de Markov en tiempo continuo: definición e importanciaAndrea Navarro100% (1)

- Procesos EstocásticosДокумент49 страницProcesos EstocásticosSusana Maria Encina0% (1)

- 3 Cadenas de MarkovДокумент35 страниц3 Cadenas de MarkovDEIYA BAUTISTAОценок пока нет

- Inves RochaДокумент12 страницInves RochaJesus PerezОценок пока нет

- BorrachoДокумент22 страницыBorrachoCristhyan NaranjoОценок пока нет

- Cadena de Markov - Poisson - Martingala - Mov BrownianoДокумент10 страницCadena de Markov - Poisson - Martingala - Mov BrownianoEnoc BarrigaОценок пока нет

- Cobit 5Документ3 страницыCobit 5Eliza H. AguilarОценок пока нет

- Tramapalabras 1Документ25 страницTramapalabras 1Eliza H. Aguilar70% (23)

- Letramania 3Документ80 страницLetramania 3Gonzalo Amaya100% (2)

- Estimados Alumnos PP2Документ1 страницаEstimados Alumnos PP2Eliza H. AguilarОценок пока нет

- Resolucion de La Práctica Calificada de Analisis y Diseño de SistemasДокумент2 страницыResolucion de La Práctica Calificada de Analisis y Diseño de SistemasEliza H. AguilarОценок пока нет

- Letramania 2Документ64 страницыLetramania 2Gonzalo Amaya0% (2)

- Gestión de Los RRHHДокумент2 страницыGestión de Los RRHHEliza H. AguilarОценок пока нет

- Propuesta de TrabajoДокумент2 страницыPropuesta de TrabajoEliza H. AguilarОценок пока нет

- Gestion Del CronogramaДокумент1 страницаGestion Del CronogramaEliza H. AguilarОценок пока нет

- Buenos DíasДокумент1 страницаBuenos DíasEliza H. AguilarОценок пока нет

- Car TulaДокумент1 страницаCar TulaEliza H. AguilarОценок пока нет

- Iso 27001-27005Документ5 страницIso 27001-27005Eliza H. Aguilar100% (1)

- Uper - Rrtresponsable Del Área de CapacitacionДокумент3 страницыUper - Rrtresponsable Del Área de CapacitacionEliza H. AguilarОценок пока нет

- Reglamento Practica Pre ProfesionalДокумент20 страницReglamento Practica Pre ProfesionalEliza H. AguilarОценок пока нет

- CompañerosДокумент1 страницаCompañerosEliza H. AguilarОценок пока нет

- TAREAДокумент2 страницыTAREAEliza H. AguilarОценок пока нет

- Patrimonio NacionalДокумент3 страницыPatrimonio NacionalFelipe63% (16)

- Unit 9Документ9 страницUnit 9Eliza H. AguilarОценок пока нет

- 3 Lab 3-4-1 Archivo de AudioДокумент2 страницы3 Lab 3-4-1 Archivo de AudioEliza H. AguilarОценок пока нет

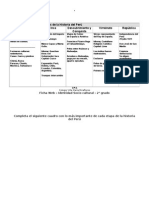

- 2G-FWISC4.Etapas de La Historia Del Perú - RptaДокумент2 страницы2G-FWISC4.Etapas de La Historia Del Perú - RptaCarlos Alberto Carreño Ramirez100% (1)

- Introduccción A La Gestión de ProyectosДокумент55 страницIntroduccción A La Gestión de ProyectosEliza H. AguilarОценок пока нет

- AbrilДокумент1 страницаAbrilEliza H. AguilarОценок пока нет

- FormatosДокумент2 страницыFormatosEliza H. AguilarОценок пока нет

- Investigacion TecnologicaДокумент3 страницыInvestigacion TecnologicaEliza H. AguilarОценок пока нет

- Areas Naturales Protegidas en El PeruДокумент33 страницыAreas Naturales Protegidas en El PeruEliza H. AguilarОценок пока нет

- Lista de Asistencia de Alumnos 2014-IIДокумент1 страницаLista de Asistencia de Alumnos 2014-IIEliza H. AguilarОценок пока нет

- CartasДокумент3 страницыCartasEliza H. AguilarОценок пока нет

- TareaДокумент8 страницTareaElizabeth Mescua CamargoОценок пока нет

- Planillas ProcesosДокумент3 страницыPlanillas ProcesosEliza H. AguilarОценок пока нет

- Mapa ProyectosДокумент7 страницMapa ProyectosEliza H. AguilarОценок пока нет

- 1.esquema Comunicacion Jakobson 1Документ4 страницы1.esquema Comunicacion Jakobson 1Patoo MezaОценок пока нет

- Humedad Relativa, YungayДокумент415 страницHumedad Relativa, YungayMiguel Leon MartinezОценок пока нет

- Metales: clasificación y tiposДокумент2 страницыMetales: clasificación y tiposJorge CaleroОценок пока нет

- Sistema anti-incendio inteligenteДокумент3 страницыSistema anti-incendio inteligentegusequeОценок пока нет

- Practica de Instr 06 MARLEnyДокумент11 страницPractica de Instr 06 MARLEnyVanessa Quispe SulcaОценок пока нет

- RIQAS Explicado en EspanolДокумент25 страницRIQAS Explicado en EspanolCARLOS100% (2)

- MSDS Joint Compound - PASTA HAMILTON PDFДокумент10 страницMSDS Joint Compound - PASTA HAMILTON PDFJohnny AlvaroОценок пока нет

- Puente TacomaДокумент20 страницPuente Tacomagdesk1Оценок пока нет

- Fisica Sem 3Документ4 страницыFisica Sem 3Juanjo Peña SantosОценок пока нет

- SassanoДокумент29 страницSassanoJuan Pablo Galvez Gonzalez100% (3)

- Practico 3 - 2012Документ14 страницPractico 3 - 2012sandra_muñoz_15Оценок пока нет

- Grupo Electrogeno de 170 KWДокумент2 страницыGrupo Electrogeno de 170 KWWilian CastroОценок пока нет

- Ii!Iii 1iáiДокумент104 страницыIi!Iii 1iáiMario ParedesОценок пока нет

- Ciclo Del Cobre TerminadoДокумент7 страницCiclo Del Cobre TerminadoJose Julián LópezОценок пока нет

- Distribución de probabilidad de la suma de números extraídos de una urnaДокумент6 страницDistribución de probabilidad de la suma de números extraídos de una urnacamilo101350% (2)

- Aplicaciones de La LixiviacionДокумент2 страницыAplicaciones de La LixiviacionAarón Bayona0% (1)

- Andres Tabla PeriodicaДокумент8 страницAndres Tabla Periodicaandres villamilОценок пока нет

- ANTIACAROSДокумент4 страницыANTIACAROSJorshshshОценок пока нет

- Copia de Folletos Diseño y Construcción de Pozos PDFДокумент2 страницыCopia de Folletos Diseño y Construcción de Pozos PDFAndrea Ospino GarcíaОценок пока нет

- HydraulicaДокумент46 страницHydraulicaedwar_12100% (1)

- d3d3LmludGVjY2EudW5lZC5lcw 238170 1489493213 TUTV 3 Uned 2017 VisualДокумент94 страницыd3d3LmludGVjY2EudW5lZC5lcw 238170 1489493213 TUTV 3 Uned 2017 VisualmatrizledОценок пока нет

- Programacion LinealДокумент30 страницProgramacion LinealivangodoycОценок пока нет

- El Metodo CientificoДокумент2 страницыEl Metodo CientificoByron Anibal Luis GarciaОценок пока нет

- Glosario de Términos MinerosДокумент4 страницыGlosario de Términos MinerosLuis Zendo Zepeda VásquezОценок пока нет

- Problema Del TiburonДокумент9 страницProblema Del TiburonSergio0% (3)

- Clasificación de Peirce de las relaciones triádicas y signos en 10 clasesДокумент10 страницClasificación de Peirce de las relaciones triádicas y signos en 10 clasesnatassja lopezОценок пока нет

- Catalogo Cursos PDFДокумент34 страницыCatalogo Cursos PDFramonluhrОценок пока нет

- Métodos de medición de temperatura optimizados paraДокумент31 страницаMétodos de medición de temperatura optimizados paraTomas Garcia MirandaОценок пока нет

- Mecánica de suelos II UNSLGC IcaДокумент23 страницыMecánica de suelos II UNSLGC Icaomar kanaОценок пока нет

- Reporte Cápsulas de IndometacinaДокумент6 страницReporte Cápsulas de IndometacinaAxelWarnerОценок пока нет