Академический Документы

Профессиональный Документы

Культура Документы

Cadenas de Markov FINAL

Загружено:

Jesús Eduardo Méndez CuayaАвторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Cadenas de Markov FINAL

Загружено:

Jesús Eduardo Méndez CuayaАвторское право:

Доступные форматы

Instituto Tecnolgico de

Puebla

Investigacin de

Operaciones II

III. Cadenas de Markov

Integrantes:

Lopez Flores Karina

Flores Lopez Alfredo

Romero Garca Jessica

Que es una cadena de Markov?

Una cadena de Markov es una sucesin de ensayos similares u observaciones en

la cual cada ensayo tiene el mismo nmero finito de resultados posibles y en

donde la probabilidad de cada resultado para un ensayo dado depende slo del

resultado del ensayo inmediatamente precedente y no de cualquier resultado

previo.

Andrei Andreivich Markov fue un matemtico ruso que postulo el principio de

que existen ciertos procesos estocsticos cuyo futuro depende nicamente de su

presente y es independiente de su pasado.

Para que sirve?

> Para estudiar el comportamiento a corto y largo plazo de ciertos

sistemas estocsticos

> Para determinar la poltica o el curso de accin optimo que maximice

el ingreso esperado del proceso en un numero de etapas finito o

infinito

Aplicaciones

Resolver problemas de inventario

Lneas de espera

Mantenimiento y remplazo

Clasificacin de los clientes

Secuencia del DNA

Anlisis de redes genticas

Estimacin de la demanda de ventas a travs del tiempo y el valor

del crdito

Estocstico

Son de inters para describir el comportamiento de un sistema en

operacin durante algunos periodos

Una sucesin de observaciones

1 ,

2

se denomina proceso

estocstico si;

Los valores de estas observaciones no se pueden predecir examante

Se pueden especificar las probabilidades para los distintos valores

posibles en cualquier instante de tiempo

Estructura del sistema estocstico

La condicin del sistema puede estar en una S+1 categoras

mutuamente excluyentes llamadas estados .Por conveniencia estos

estados se etiquetan 0, 1, 2 S.

La variable aleatoria

, representa el estado del sistema en el

tiempo t, de manera que sus nicos valores posibles son 0, 1, S.

El sistema se observa en puntos del tiempo dados etiquetados

t=0,1,2, de esta forma los procesos estocsticos {

}= {

0

,

1

,

2

}

Proporciona una representacin matemtica de la forma en que

evoluciona la condicin del sistema fsico a travs del tiempo.

FORMULACIN DE CADENAS DE

MARKOV

1) Existe un numero limitado o finito de estados

2) La probabilidad de que los estados cambien permanece igual a lo

largo del tiempo

3) Se puede predecir cualquier estado futuro a partir del estado

anterior de la matriz de probabilidades de transicin

4) El tamao y construccin del sistema no cambian durante el anlisis

PROPIEDAD MARKOVIANA DE PRIMER ORDEN

+1

=

+1

1

=

1

,

2

=

2

, ,

=

= (

+1

=

+1

|

=

)

DEFINICIONES EN LAS CADENAS DE

MARKOV DE PRIMER ORDEN:

Estados: Las condiciones en las cuales se encuentra un ente sucesos

posibles.

Ensayos: Las ocurrencias repetidas de un evento que se estudia.

Probabilidad de Transicin: La probabilidad de pasar de un estado

actual al siguiente en un perodo tiempo, y se denota por

( la

probabilidad de pasar del estado i al estado j en una transicin

perodo)

Diagrama de transicin

La transicin de un estado a otro en dos periodos consecutivos de

tiempo se puede graficar con un diagrama de transicin

Nodos=estado

Arco

Probabilidad de

transicin

Matriz de Transicin de un solo

paso

Transicin : cualquier cambio de estado.

Se muestra la informacin de probabilidad de moverse de un estado a

otro en una transicin

1 2 3

P=

1

2

3

11

12

13

21

22

23

31

32

33

PROPIEDADES:

1)La suma de los elementos de cada

fila debe ser igual a 1.

2)La matriz de transicin debe ser

cuadrada.

3)Las probabilidades de transicin

deben estar entre 0 y 1

EJEMPLO

Supongamos que el clima de una determinada regin slo puede ser

soleado (

1

) o nublado (

2

) y que en condiciones del clima en maanas

sucesivas forman una cadena de Markov con probabilidades de

transicin estacionarias. La matriz de transicin esta dada por:

1

2

P=

Si un da concreto est nublado, Cul es la probabilidad de que est

nublado el da siguiente?

22

= 0.4

2

.7 .3

.6 .4

Probabilidad de transicin

estacionarias de n pasos

Hace referencia a cuando un proceso inicia en un

estado

, debe pasar a estado

y durante su

trayecto pasa por una n cantidad de estados.

Se utiliza en procesos complejos y variantes, es por

eso que se justifica su estudio en el campo estocstico

En el ejemplo anterior, con la matriz de transicin:

1

2

P=

Si un mircoles est nublado, Cul es la probabilidad de que el viernes

siguiente haga sol?

Calculando la matriz de transicin en dos pasos:

2

=

=

2

.7 .3

.6 .4

.7 .3

.6 .4

.7 .3

.6 .4

.67 .33

.66 .34

1 2

Estado Alcanzable: un estado j es alcanzable desde el estado i si hay una

trayectoria que conduzca de i a j.

Si consideramos el ejemplo 1 podemos afirmar que el estado 3 es accesible

desde el estado 1. An cuando en una etapa no podemos llegar desde el

estado 1 al estado 3, si podemos hacerlo al cabo de 2, 3, ..., n etapas.

Estados que se Comunican: se dice que dos estados i y j se comunican

si j es alcanzable desde i, e i es alcanzable desde j.

2 estados que son alcanzables viceversa se comunican y pertenecen a una

misma clase de estados.

ESTADOS

Estado Absorbente: un estado i es absorbente cuando j llega al

estado i y no puede salir de l, por tanto es cero la probabilidad de

hacer una transicin fuera de ese estado. Una vez que el sistema hace

una transicin hacia un estado absorbente, permanece en el siempre.

En el ejemplo 2, en cuanto al estado 0 y estado 4, estos son

estados absorbentes debido a que una vez que se accede a ellos la probabilidad de

seguir en ese estado es de un 100%.

1 2

Estado Recurrente: siempre que parta del estado i, ser un estado

recurrente si se puede volver al mismo estado i.

Estado Transitorio: un estado i es un estado transitorio si existe un

estado j que es alcanzable desde i, pero el estado i no es alcanzable

desde el estado j.

En el ejemplo 1 todos los estados son recurrentes. En el ejemplo 2 los estados 1, 2

y 3 son transitorios debido a que si se comienza en cualquiera de ellos no se puede

asegurar con certeza que se volver al mismo estado en algn momento (esto

debido a que existe una probabilidad no nula de acceder a un estado absorbente: 0

o 4).

1 2

Estado Peridico: un estado es peridico si, partiendo de ese estado,

slo es posible volver a l en un nmero de etapas que sea mltiplo

de un cierto nmero entero mayor que uno. Si un estado recurrente

no es peridico, se conoce como aperidico (no sabemos cuando

vamos a regresar al estado .

Ejemplo completo de clima

El clima en el pueblo de Centerville puede cambiar con rapidez de un da a otro . Sin

embargo, las posibilidades de tener clima seco (sin lluvia) maana es de alguna

forma mayor si hoy esta seco , es decir si no llueve . En particular la probabilidad de

que maana este seco es de 0.8 si hoy esta seco, pero es de solo 0.6 si hoy llueve.

Estas probabilidades no cambian si se considera la informacin acerca del clima en

los das anteriores a hoy .

La evolucin del clima da tras da en Centerville es un proceso estocstico. Si se

comienza en algn da inicial (etiquetado como da 0), el clima se observa cada da t

,para t=0,1,2

1. Encontrar el estado del sistema para el dia t:

Estado 0 = El da t es seco

Estado 1 = El da t es lluvioso

2. Representacin de la formula

i=tiempo 0 (actual)

j=tiempo siguiente

(

+1

=

= = (

+1

= 0

= 0 = 0.8

(

+1

=

= = (

+1

= 0

= 1 = 0.6

3. Matriz y diagrama de transicin

0 1 0 1

P=

0

1

00

01

10

11

= P =

0

1

0.8 0.2

0.6 0.4

0 1

0.2

0.6

0.8 0.4

Donde

00

+

01

= 1 0.8=0.2

10

+

11

= 1 0.6= 0.4

La matriz P contiene los estados posibles del problema.

Debe leerse que la si hoy es un da seco la probabilidad que maana sea

seco es 0.8

Si hoy es un seco, la probabilidad que maana sea lluvioso es 0.2

Si hoy es un da lluvioso, la probabilidad que maana sea seco es 0.6

Si hoy es un da lluvioso ,la probabilidad que maana sea lluvioso es 0.4

El proceso estocstico proporciona una representacin

matemtica de la forma como evoluciona el clima Centerville a travs del

tiempo.

|

|

.

|

\

|

=

4 . 0 6 . 0

2 . 0 8 . 0

1

0

1 0

P

{ } { } ,... , ,

3 2 1

X X X X

t

=

La probabilidad del estado del clima dos, tres, cuatro, cinco das a futuro se puede

conocer a partir de las matrices de transicin de dos, tres, cuatro y cinco pasos. Partiendo

de la matriz de transicin de un paso.

0.8 0.2

0.6 0.4

0.8 0.2

0.6 0.4

0.76 0.24

0.72 0.28

2

=

3

=

2

0.8 0.2

0.6 0.4

0.76 0.24

0.72 0.28

0.752 0.248

0.744 0.256

4

=

3

0.8 0.2

0.6 0.4

0.752 0.248

0.744 0.256

0.75 0.25

0.749 0.251

5=

4

0.8 0.2

0.6 0.4

0.75 0.25

0.749 0.251

0.75 0.75

0.75 0.25

Observe que en la matriz de cinco pasos, las dos filas tienen elementos idnticos.

Esto se denomina probabilidad del estado estable de la cadena de Markov.

Matrices de transicin de estados en n pasos del clima:

Ejemplo de la bebida de cola

Suponga que toda la industria de bebidas de cola produce solo dos. Dado

que una persona la ultima vez compro cola 1, hay 90 % de probabilidades

de su que su siguiente compra sea cola 1 .Dado que la ultima compra de

una persona fue cola 2, hay 80 % de probabilidades de que su siguiente

compra sea cola 2.

1.- Si una persona en la actualidad es comprador de cola 2, Cul es la

probabilidad de que compre cola 1 dos veces a partir de ahora ?

2.- Si una persona en la actualidad es comprador de cola 1 , Cul es la probabilidad de que

compre cola 1 tres ocasiones a partir de ahora ?

Solucin

* Las compras de cada individuo pueden representarse como una

cadena de Markov en dos estados , donde:

Estado 1 La persona compro cola tipo 1 la ultima vez

Estado 2 La persona compro cola tipo 2 la ultima vez

Si se define Xn como el tipo de cola que una persona compra en su

n-sima compra futura (compra actual de cola Xo) , entonces Xo, X1.

Se podra escribir como la cadena de Markov con la siguiente matriz

de transicin :

cola 1 cola 2

cola 1

.90 .10

.20 .80

P = cola 2

1.-Se busca P= (

2

= 1|

0

= 2) =

21

(2) = elemento 21 de

2

2

=

.90 .10

.20 .80

.90 .10

.20 .80

=

.83 .17

.34 .66

Contestar pregunta 1 y 2

21

(2) =.34 Esto significa que la probabilidad de un bebedor de cola 2

en el futuro compre 2 veces cola 1 es 0.34.

Otra forma de solucin

21

(2) = (Probabilidad de que la siguiente compra sea cola 1 y la

segunda compra sea cola 1) + ( probabilidad de que la siguiente

compra sea cola 2 y la segunda compra sea cola 1 )=

= (.20)(.90)+(.80)(.20)=0.34

2.- Se busca

11

(3) = elemento 11 de

3

3

= P (

2

) =

.90 .10

.20 .80

.83 .17

.34 .66

=

.781 .219

.438 .562

Por lo tanto ,

11

(3) = .781

Cola

2

Cola

2

Cola

1

Cola

1

22

=.80

21

=.20

21

=.20

11

=.90

Tiempo 1 tiempo 2 tiempo 3

Вам также может понравиться

- Toma de Decisiones Ejercicios ResueltosДокумент52 страницыToma de Decisiones Ejercicios ResueltosJesús Eduardo Méndez Cuaya73% (33)

- PRESENTACIÓN ISO 14001-2015 (1) Última ActualizaciónДокумент31 страницаPRESENTACIÓN ISO 14001-2015 (1) Última ActualizaciónFernando Vega100% (1)

- Cronograma de Apqp ImpermeablesДокумент9 страницCronograma de Apqp ImpermeablesJesús Eduardo Méndez CuayaОценок пока нет

- Minuta para Juntas GeneralesДокумент8 страницMinuta para Juntas GeneralesJesús Eduardo Méndez CuayaОценок пока нет

- 01 Cuestionario Sobre EsclavitudДокумент3 страницы01 Cuestionario Sobre EsclavitudJesús Eduardo Méndez CuayaОценок пока нет

- Implementacion de Un Modelo de Mantenimiento Centrado en La Confibilidad. 2007Документ28 страницImplementacion de Un Modelo de Mantenimiento Centrado en La Confibilidad. 2007Jesús Eduardo Méndez CuayaОценок пока нет

- Modelo APAДокумент5 страницModelo APAJesús Eduardo Méndez CuayaОценок пока нет

- Modelo de Reemplazo de Equipo TareaДокумент15 страницModelo de Reemplazo de Equipo TareaJesús Eduardo Méndez Cuaya80% (5)

- Disenos de Plackett-BurmanДокумент20 страницDisenos de Plackett-BurmanMarco Antonio100% (2)

- Ejercicios de Tarea MochilaДокумент6 страницEjercicios de Tarea MochilaJesús Eduardo Méndez Cuaya100% (3)

- Ejemplos de Cursos de CapacitaciónДокумент5 страницEjemplos de Cursos de CapacitaciónJesús Eduardo Méndez CuayaОценок пока нет

- Tarea 3 - Hidrocarburos Aromáticos, Alcoholes y Aminas DIANADELMARДокумент9 страницTarea 3 - Hidrocarburos Aromáticos, Alcoholes y Aminas DIANADELMARDianaОценок пока нет

- El OzonoДокумент7 страницEl Ozonoyusneidy valentina quesada gomezОценок пока нет

- GP8 HguДокумент4 страницыGP8 HguSTHEFANY LUCIA MEZA ACUNAОценок пока нет

- Rol AsistencialДокумент3 страницыRol AsistencialJavier RamirezОценок пока нет

- Inspiración de Las EscriturasДокумент7 страницInspiración de Las EscriturasDario MejiaОценок пока нет

- Tercer Periodo MatematicasДокумент5 страницTercer Periodo MatematicasMagda MartinezОценок пока нет

- Quimica Fisica, Fisica Atomica y Fisica MolecularДокумент21 страницаQuimica Fisica, Fisica Atomica y Fisica Molecularmanuel vegaОценок пока нет

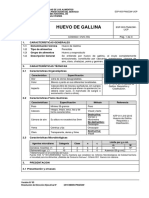

- QALIWARMA, Huevo de Gallina.Документ3 страницыQALIWARMA, Huevo de Gallina.Alonzo CustodioОценок пока нет

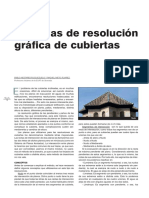

- Sistemas de Resolucion Grafica de Cubiertas 1 Parte PDFДокумент12 страницSistemas de Resolucion Grafica de Cubiertas 1 Parte PDFFausto Xavier Saquicela RiveraОценок пока нет

- Admin Permiso Temporal Individual Compras Insumos Basicos Con Clave Unica 2237647 PDFДокумент1 страницаAdmin Permiso Temporal Individual Compras Insumos Basicos Con Clave Unica 2237647 PDFCarlos YañezОценок пока нет

- Diapositivas Dengue, Zika y ChikungunyaДокумент33 страницыDiapositivas Dengue, Zika y ChikungunyaJennifferValera0% (1)

- Fundamentos Sistemas Propulsion I PDFДокумент127 страницFundamentos Sistemas Propulsion I PDFyeisonОценок пока нет

- Cachorros Respet El JuegoДокумент1 страницаCachorros Respet El JuegoGregoWhiteОценок пока нет

- Sem.01 Analizamos La Participacion Democratica en La Sociedad Antigua Primer AñoДокумент4 страницыSem.01 Analizamos La Participacion Democratica en La Sociedad Antigua Primer AñoCalebGYОценок пока нет

- Ensayo Control FiscalДокумент4 страницыEnsayo Control Fiscalkarolvalentina50% (2)

- Actividad 5 MuestreoДокумент7 страницActividad 5 MuestreoCORPOSALUD BARRANCABERMEJA50% (2)

- Administracic3b3n de Lc3adquidos Parenterales Factor Goteo EquipoДокумент67 страницAdministracic3b3n de Lc3adquidos Parenterales Factor Goteo EquipoAleida vallejos culquiОценок пока нет

- Sildenafilo CitratoДокумент4 страницыSildenafilo CitratoJaime AlegríaОценок пока нет

- Estudio Academico ROSA ALEJANDROДокумент3 страницыEstudio Academico ROSA ALEJANDRONelson Salas100% (3)

- La Descentralizacion en El PeruДокумент58 страницLa Descentralizacion en El PeruHugos Vasquez100% (1)

- Marco de Especificaciones Prueba Nacional Estandarizada 2023Документ62 страницыMarco de Especificaciones Prueba Nacional Estandarizada 2023Marco AguilarОценок пока нет

- Derechos RealesДокумент3 страницыDerechos RealesJUAN CARLOS KRISHNA JUNCHAYA HUAMANОценок пока нет

- Radiologia e HistoriaДокумент24 страницыRadiologia e HistoriaPam OОценок пока нет

- Brochure de Promoción y Prevención 2020-0723Документ2 страницыBrochure de Promoción y Prevención 2020-0723Jenifer RamirezОценок пока нет

- Pauta de Evaluaciòn Imural 5ºДокумент2 страницыPauta de Evaluaciòn Imural 5ºMaría Inés Morales BurgosОценок пока нет

- Flexpipe Systems Technical Information Manual - 06-1876 - R4 1 - Spanish - Sept 2013Документ72 страницыFlexpipe Systems Technical Information Manual - 06-1876 - R4 1 - Spanish - Sept 2013Ana FigueroaОценок пока нет

- Crucigrama SocialesДокумент9 страницCrucigrama SocialesEly FerОценок пока нет

- IC Family Vacation Itinerary 27505 - ESДокумент5 страницIC Family Vacation Itinerary 27505 - ESMariana Gurrola SotoОценок пока нет

- Problemas Resueltos de Transmisión de Calor (U.Sevilla)Документ65 страницProblemas Resueltos de Transmisión de Calor (U.Sevilla)rubiohot6975% (4)