Академический Документы

Профессиональный Документы

Культура Документы

Otsenka Effektivnosti Parallelnyh Algoritmov Dlya Modelirovaniya Mnogosloynogo Perseptrona

Загружено:

Дина НиколаеваАвторское право

Доступные форматы

Поделиться этим документом

Поделиться или встроить документ

Этот документ был вам полезен?

Это неприемлемый материал?

Пожаловаться на этот документАвторское право:

Доступные форматы

Otsenka Effektivnosti Parallelnyh Algoritmov Dlya Modelirovaniya Mnogosloynogo Perseptrona

Загружено:

Дина НиколаеваАвторское право:

Доступные форматы

166 УПРАВЛЕНИЕ, ВЫЧИСЛИТЕЛЬНАЯ ТЕХНИКА И ИНФОРМАТИКА

УДК 004.891.2

В.В. Симонов

Оценка эффективности параллельных алгоритмов

для моделирования многослойного персептрона

Дано краткое описание параллельного алгоритма моделирования многослойного пер-

септрона и параллельного алгоритма обучения iRprop. Алгоритмы используют парал-

лельные вычисления с разделяемой памятью и параллельность на уровне инструкций

процессора. Приведено сравнение быстродействия последовательного и параллельного

алгоритмов, а также динамика изменения их быстродействия за последние 6 лет.

Ключевые слова: многослойный персептрон, обучение многослойного персептрона,

параллельные вычисления с разделяемой памятью, SIMD инструкции.

Введение

Алгоритмы моделирования и обучения нейронных сетей имеют высокую вычисли-

тельную сложность. Во многих приложениях ИНС, вычислительная сложность пропор-

циональна квадрату количества настраиваемых связей ИНС. Обучение больших ИНС мо-

жет занимать несколько дней. Ускорение процесса их обучения поможет исследователям

быстрее находить оптимальные топологии и добиваться более точных результатов прогно-

зирования и распознавания. Также быстродействие моделей ИНС очень важно для систем

принятия решений в реальном времени, например систем, использующих машинное зрение.

Объем задач, решаемых с помощью ИНС, непрерывно растет. Увеличивается слож-

ность моделей, ужесточаются бизнес-требования, предъявляемые к моделям. Все это

приводит к увеличению вычислительной сложности.

Ранее созданные программы не могут использовать даже половину вычислительной

мощности современных процессоров, так как не используют параллельные вычисления,

а потенциал увеличения производительности отдельно взятого процессорного ядра прак-

тически исчерпан. Быстродействие ранее созданных алгоритмов на современных компью-

терах будет повышаться медленнее роста сложности задач, что приведет к неэффективно-

сти систем, использующих эти алгоритмы. Поэтому сейчас очень важно создавать новые,

параллельные реализации моделей ИНС, чтобы они могли использовать возрастающую

вычислительную мощь современных ЭВМ и легко масштабировались для решения боль-

ших и сложных практических задач.

Проблема разработки параллельных алгоритмов встала относительно недавно, но ее

актуальность непрерывно растет. На данный момент имеется совсем немного теоретиче-

ских разработок и методов организации параллельных вычислений. Поэтому необходимо

искать новые способы распараллеливания алгоритмов, разрабатывать методы выделения

шагов, способных выполняться параллельно.

Использование параллельных вычислений позволит повысить энергоэффективность

процесса моделирования и обучения, измеренную в миллионах операций с плавающей

точкой (mflops) на затраченный ватт электроэнергии.

1. Постановка задачи

Для популярных в настоящее время математических моделей ИНС и моделей их обу-

чения необходимо разработать параллельные алгоритмы, позволяющие в полной мере

использовать вычислительную мощь современных многоядерных процессоров. Парал-

лельные алгоритмы должны хорошо масштабироваться. Это означает, что со временем

количество вычислительных потоков, способных выполняться одновременно, будет расти,

и алгоритмы должны быть построены таким образом, чтобы обеспечить работой как

можно большее количество параллельных потоков.

2. Выбор метода исследования

Быстродействие реализации сравнивается с быстродействием алгоритмов, реализо-

ванных в библиотеке Fast Artificial Neural Network Library (FANN) версии 1.2.0 [1]. Реа-

лизация ИНС из библиотеки FANN обладает отличным быстродействием и использует

оптимизации, такие как оптимизация доступа к данным, разворачивание циклов (loop

unrolling).

Быстродействие измерялось в секундах, затраченных реализациями алгоритмов на

выполнение одних и тех же вычислений. Высчитывалось среднее время из десяти прохо-

дов для каждой реализации.

Доклады ТУСУРа, № 1 (21), часть 1, июнь 2010

В.В. Симонов. Оценка эффективности параллельных алгоритмов 167

В ходе тестирования было установлено, что реализации многослойного персептрона и

iRprop [2] не требовательны к пропускной способности памяти. Их быстродействие огра-

ничено только быстродействием процессора. Было проведено тестирование реализации на

различных процессорах Intel от 2004 до 2009 года выпуска, от Pentium 4 до Core i7, что

позволит сделать некоторые выводы относительно масштабируемости реализаций и спрог-

нозировать будущие изменения быстродействия.

3. Описание параллельных алгоритмов

3.1. Параллельная реализация многослойного персептрона

Многослойный персептрон реализован в виде класса Perceptron. Этот класс отвечает

за прямое распространение сигнала в нейронной сети и информацию о топологии сети.

Perceptron содержит данные двух видов: данные для чтения (Structure) и данные для

чтения и записи (Data). Во время функционирования нейронной сети ее структура не ме-

няется, т.е. описание структуры сети используется только для чтения, в то время как

Data полностью перезаписывается при прямом распространении сигнала в сети. Чтобы

можно было выполнять прямое распространение сигнала параллельно, необходимо соз-

дать копию экземпляра Perceptron для каждого потока, но так как структура персептро-

на при этом не меняется, ее можно не копировать. Для этих целей был создан метод

Perceptron::ParallelCopy. Таким образом, объект Structure может использоваться не-

сколькими объектами Perceptron. Для разделяемых объектов Structure реализован под-

счет ссылок, это позволяет удалить класс Structure, если на него не ссылается ни один

из Perceptron.

При прямом распространении сигнала выходной сигнал для каждого нейрона слоя

рассчитывается параллельно. Это реализовано с помощью стандарта OpenMP [3].

Число синапсов каждого нейрона сети сделано кратным четырем. Например, если

число синапсов нейрона – 13, оно будет увеличено до 16. Однако пользователь по-

прежнему может работать только с 13 синапсами, веса добавленных 3 синапсов всегда

равны нулю. Добавление дополнительных синапсов делается для того, чтобы можно было

применить векторные инструкции для SSE (Streaming SIMD Extension) [4, 5] для вычис-

ления взвешенной суммы входов нейронов. Инструкции SSE позволяют выполнить одну и

ту же арифметическую операцию над 4 вещественными числами одинарной точности од-

ной командой. Использование SSE позволило увеличить быстродействие сети в 2,5 раза.

3.2. Параллельная реализация алгоритма iRprop

При обучении ИНС с помощью алгоритма iRprop ей сначала предъявляются все при-

меры обучающей выборки, для каждого примера вычисляется ошибка аппроксимации

(разность между выходом нейронной сети и полученным значением). Происходит обрат-

ное распространение ошибки, т.е. распространение сигнала от выхода нейронной сети ко

E

входу. Вычисляется оценка частной производной , где E(W) – функция ошибки

wij

нейронной сети от всех весов сети W; wij – вес нейронной сети, связывающий i нейрон с

j, wij W .

Эти шаги можно выполнить параллельно. Для этого каждый вычислительный поток

должен иметь параллельную копию многослойного персептрона (можно использовать Per-

ceptron::CloneParallel), копию массива отклонений (ошибок) каждого нейрона в сети и

копию массива оценок частной производной функции ошибки по весу для каждого на-

страиваемого веса в сети.

4. Постановка эксперимента

В результате выполнения данной работы была написана библиотека классов, содер-

жащая параллельную реализацию многослойного персептрона и параллельную реализа-

цию алгоритма обучения iRprop.

Было произведено тестирование библиотеки. Для этого была взята большая нейрон-

ная сеть с 200 входами, 100 нейронами в скрытом слое, 1 нейроном в выходном слое.

Сеть представляла собой многослойный персептрон, в котором каждый нейрон после-

дующего слоя был связан со всеми нейронами предыдущего слоя. Для сравнения быстро-

действия использовалась библиотека FANN [1]. Для компиляции параллельной и последо-

вательной (FANN) реализаций использовался компилятор Microsoft C++ Compiler 10.

Веса нейронной сети инициализировались каждый раз одними и теми же значениями,

одинаковыми для FANN сети и для описываемой реализации. Далее на каждой тестовой

машине проводились 100 эпох обучения нейронной сети и измерялось среднее время для

10 попыток обучения. Это позволило сразу задействовать алгоритмы прямого распростра-

нения сигнала в нейронной сети и алгоритм iRprop, сравнивать разные реализации алго-

Доклады ТУСУРа, № 1 (21), часть 2, июнь 2010

168 УПРАВЛЕНИЕ, ВЫЧИСЛИТЕЛЬНАЯ ТЕХНИКА И ИНФОРМАТИКА

ритмов в одинаковых условиях и увеличить точность оценок за счет повторения экспери-

ментов.

Были проведены тесты параллельной реализации с различным количеством вычис-

лительных потоков. На каждой системе были проведены тесты с использованием одного

вычислительного потока (то же самое, что использовать последовательные вычисления),

двух, и т.д. до n, где n – максимальное количество параллельных вычислительных по-

токов в системе. Например, для процессора Intel Core i7 920 с 4 физическими ядрами,

каждое из которых содержит два логических, этот показатель будет равен 2·4 = 8. Была

вычислена оценка эффективности параллельных вычислений. Эффективность распаралле-

ливания показывает, какой процент времени вычислительные потоки тратят на эффек-

тивную работу, на вычисления. Значение 60% означает, что вычислительные потоки

60% времени выполняют полезную работу и 40% времени простаивают или тратят на

синхронизацию. Эффективность вычислялась по формуле

T

пос 100% , (1)

n Tпар

где Tпос – время, затраченное на последовательное вычисление; Tпар – время, затрачен-

ное на параллельное вычисление; n – количество вычислительных потоков.

5. Результаты эксперимента

Результаты измерения времени обучения многослойного персептрона для описывае-

мой реализации и FANN приведены в табл. 1.

Таблица 1

Результаты измерения времени, затрачиваемого различными реализациями алгоритма

Описывае-

Описываемая Эффектив-

Время мая реали-

N Дата нача- реализация по- ность рас-

Процессор FANN, зация па-

п/п ла выпуска следовательно, параллели-

с раллельно,

время, с вания, %

время, с

1 Pentium 4 HT @3.0 01.02.2004 24,26 13,07 11,35 57,6

2 Pentium D 805 @2.66 01.03.2006 24,42 13,17 7,52 87,5

3 Core 2 Duo E6400 @2.14 27.07.2006 11,82 6,28 3,58 87,8

4 Xeon E5345 (x2) @2.33 01.10.2006 11,85 6,50 1,89 81,4

5 Core 2 Quad Q6600 @2.4 07.01.2007 12,74 6,34 1,57 100,8

6 Core 2 Duo E7200 @2.53 20.04.2008 10,14 5,33 3,06 87,1

7 Core 2 Duo E8400 @3.0 20.01.2008 8,58 4,46 2,48 90,1

8 Core 2 Quad Q8300 @2.53 30.11.2008 10,16 5,34 1,59 84,1

Core i7 920 (w/o HT)

9 @2.66 01.11.2008 9,16 4,78 1,31 90,9

10 Core i7 920 (HT) @2.66 01.11.2008 9,16 4,77 1,06 56,3

11 Core i7 860 @2.8 01.09.2009 8,75 4,56 1,12 51,0

12 Core i5 750 @2.66 08.09.2009 10,59 4,80 1,31 93,6

В колонке «Процессор» приведено наименование процессоров Intel и тактовая частота

в гигагерцах, на которой работал процессор во время тестирования. Тактовая частота

следует после символа «@».

В табл. 1 видно, что в последовательном режиме описываемая реализация работает

примерно в 2 раза быстрее, чем реализация FANN. Достигается это за счет использова-

ния SSE инструкций процессора. Эти инструкции позволяют выполнять 4 одинаковых

операции за одну инструкцию или за два такта процессора [5].

Для каждого процессора по формуле (1) была вычислена эффективность распаралле-

ливания. В среднем эффективность распараллеливания составила около 90% при исполь-

зовании нескольких физических ядер и 60% при использовании технологии Intel Hyper-

Threading. Intel Hyper-Threading (HT) – технология, позволяющая организовать два вы-

числительных потока на одном процессорном ядре путем удвоения количества регистров

и дублирования очереди команд. Эта технология позволяет оптимально загружать устрой-

ства процессора работой. В данном тестировании процессоры Pentium 4 HT, Core i7 920

и Core i7 860 используют HT. Стоит отметить, что для Core i7 920 приведены результаты

Доклады ТУСУРа, № 1 (21), часть 1, июнь 2010

В.В. Симонов. Оценка эффективности параллельных алгоритмов 169

как с включенной HT (строка №10), так и без нее (строка №9). Эффективность распарал-

леливания без HT выше, чем с HT. Время вычислений с включенной HT меньше, чем без

нее. HT позволяет получить более высокое быстродействие при том же самом количестве

физических ядер, но снижает эффективность распараллеливания программ.

Эффективность распараллеливания могла быть и выше, если бы вычислительным

потокам давались более крупные задания, что привело бы к сокращению накладных

расходов на запуск и остановку потоков. Но в описываемой реализации этого намеренно

не сделано. Кроме создания эффективной параллельной реализации, также стояла задача

выявить как можно большее количество участков кода, способных выполняться парал-

лельно с тем, чтобы потом можно было использовать эти наработки при переходе на дру-

гие стандарты параллельного программирования, такие как OpenCL.

Тестирование на процессоре Core 2 Quad Q6600 показало эффективность распаралле-

ливания более 100%. Это можно объяснить только аномально низким быстродействием

программы при последовательном режиме. Возможно, это было вызвано активностью

фоновых программ или частыми промахами процессора в кэш память [5].

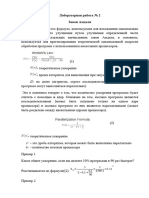

Также в табл. 1 приведены даты выпуска процессоров, что позволяет оценить скорости

роста быстродействия последовательных и параллельных вычислений за 2004–2009 гг., при-

менительно к задаче обучения искусственных нейронных сетей. На рис. 1 показана зави-

симость времени обучения нейронной сети от даты выпуска процессора для параллельных

и последовательных вычислений.

16

Время вычисления, с

1

Дата

выпуска

процессора

Параллельная программа, время Последовательная программа, время

Рис. 1. Зависимость времени вычисления от даты выхода процессора

График построен с использованием логарифмической оси. Согласно закону Мура,

быстродействие вычислительной техники растет экспоненциально, соответственно умень-

шается время, необходимое для выполнения одной и той же вычислительной задачи. То-

гда прирост производительности должен дать на графике с логарифмической шкалой

прямую линию. По методу наименьших квадратов построим линии тренда для последова-

тельных и параллельных вычислений. Из рис. 1 видно, что скорость параллельных вы-

числений со временем возрастает в 2 раза быстрее, чем скорость последовательных.

В табл. 2 приведена зависимость времени работы описываемого параллельного алго-

ритма от количества параллельных вычислительных потоков. Номера строк соответствуют

номерам строк из табл. 1. Количество вычислительных потоков взято меньше или рав-

ным количеству параллельных потоков в системе. Поэтому для системы на Core 2 Duo –

это только 2 потока, а для Core i7 – 8.

На рис. 2 показана зависимость времени обучения нейронной сети от количества вы-

числительных потоков.

Для процессоров, не использующих HT, график представляет собой гиперболу (с по-

правкой на эффективность распараллеливания, см. табл. 1).

Иначе дела обстоят с процессором Core i7 920. Для первых вычислительных потоков

график представляет собой гиперболу, но затем уменьшение времени замедляется. Свя-

зано это с тем, что на 4 физических ядрах может параллельно выполняться только 4 по-

тока, при увеличении количества потоков на одном ядре процессора начинает выпол-

няться по 2 логических потока (благодаря HT). Производительность продолжает расти,

но эффективность распараллеливания падает.

Доклады ТУСУРа, № 1 (21), часть 2, июнь 2010

170 УПРАВЛЕНИЕ, ВЫЧИСЛИТЕЛЬНАЯ ТЕХНИКА И ИНФОРМАТИКА

Таблица 2

Зависимость времени вычисления от количества параллельных вычислительных потоков

№ Зависимость времени обучения от кол-ва потоков

п/п 1 2 3 4 5 6 7 8

1 13,07 11,35

2 13,17 7,52

3 6,28 3,58

4 6,50 3,54 2,47 1,89 1,60 1,43 1,23 1,00

5 6,34 3,15 2,07 1,57

6 5,33 3,06

7 4,46 2,48

8 5,34 2,86 2,02 1,59

9 4,78 2,56 1,75 1,31

10 4,77 2,55 1,75 1,43 1,41 1,31 1,18 1,06

11 4,56 2,47 1,76 1,52 1,38 1,26 1,24 1,12

12 4,80 2,56 1,75 1,31

6

Core i7 920

(HT) @2.66

Время вычисления, с

5

Core 2 Quad

Q8300 @2.53

4

Core 2 Quad

3 Q6600 @2.4

2 Xeon E5345

(x2) @2.33

1

1 2 3 4 5 6 7 8

Количество параллельных потоков, шт.

Рис. 2. Зависимость времени обучения нейронной сети от количества параллельных потоков

Пара процессоров Xeon E5345 (2 процессора по 4 ядра) позволяет нам взглянуть на

будущее параллельных настольных вычислительных систем.

Заключение

Разработана, создана и протестирована эффективная параллельная реализация мно-

гослойного персептрона и алгоритма обучения iRprop. Алгоритмы оформлены в виде биб-

лиотеки классов на C++, что обеспечивает высокое быстродействие и позволяет повторно

использовать эти классы в приложениях.

В ходе проведенных экспериментов установлено, что использование параллельных

вычислений позволяет получить прирост скорости вычисления от 60 до 600%, по сравне-

нию с последовательными вычислениями.

Литература

1. Сайт проекта Fast Artificial Neural Network Library (FANN) [Электронный ре-

сурс]. – Режим доступа: http://leenissen.dk/fann/, свободный (дата обращения

21.04.2010).

2. Igel С. Improving the Rprop Learning Algorithm / C. Igel, M. Husken // Proceed-

ings of the Second International Symposium on Neural Computation. – 2000. – С. 115-121.

3. Открытая спецификация OpenMP API для параллельного программирования

[Электронный ресурс]. – Режим доступа: http://openmp.org/wp/, свободный (дата обра-

щения 21.04.2010).

Доклады ТУСУРа, № 1 (21), часть 1, июнь 2010

В.В. Симонов. Оценка эффективности параллельных алгоритмов 171

4. Свободная Интернет энциклопедия «Википедия». Статья «SSE» [Электронный ре-

сурс]. – Режим доступа: http://ru.wiki pedia.org/wiki/SSE, свободный (дата обращения

21.04.2010).

5. Intel® 64 and IA-32 Architectures Optimization Reference Manual November 2009

[Электронный ресурс]. – Режим доступа: http://www.intel.com/assets/pdf/manual/248966.pdf,

свободный (дата обращения 21.04.2010).

6. Открытый стандарт параллельного программирования для гетерогенных сред

OpenCL [Электронный ресурс]. – Режим доступа: http://www.khronos.org/opencl/, сво-

бодный (дата обращения 21.04.2010).

______________________________________________________________________________

Симонов Василий Владимирович

Аспирант каф. автоматизированных систем управления ТУСУРа

Тел.: +7-960-971-77-53

Эл. почта: simonov.vasiliy@gmail.com

Simonov V.V.

Efficiency estimation of parallel algorithms for multilayer perceptron modeling

There is a brief descri ption for parallel algorithm for modeling of multilayer perceptron and iRprop

learning algorithm, introduced in this article. The algorithms has been developed using parallel calcu-

lations with shared memory model and parallel instructions for CPU. The performance comparison for

serial and parallel programs and the analysis of their dynamics over the past 6 years have been done.

Keywords: multilayer perceptron, multilayer perceptron training, parallel calculations with shared

memory, SIMD instructions.

______________________________________________________________________________

Доклады ТУСУРа, № 1 (21), часть 2, июнь 2010

Вам также может понравиться

- 1669487422Документ21 страница1669487422Elyor GaybullayevОценок пока нет

- Lab - 1Документ9 страницLab - 1Андрей МайоровОценок пока нет

- 1669475791Документ12 страниц1669475791Elyor GaybullayevОценок пока нет

- 1669488310Документ14 страниц1669488310Elyor GaybullayevОценок пока нет

- Лекция 9 АЛГОРИТМ ФУНКЦИОНИРОВАНИЯ ПРОГРАММЫ SPICEДокумент10 страницЛекция 9 АЛГОРИТМ ФУНКЦИОНИРОВАНИЯ ПРОГРАММЫ SPICEАлексей АндрияшОценок пока нет

- PP 2Документ19 страницPP 2Valeria MoraruОценок пока нет

- Computational Simulation Using ParticlesДокумент18 страницComputational Simulation Using ParticlesaozeritskyОценок пока нет

- Paralab. Инструкция по проведению эксперементов.Документ39 страницParalab. Инструкция по проведению эксперементов.София СлабаОценок пока нет

- ИИДокумент12 страницИИ380961824600sОценок пока нет

- 1. Возможности пакета Quantum ESPRESSOДокумент14 страниц1. Возможности пакета Quantum ESPRESSOIlias GazizullinОценок пока нет

- КурсоваяДокумент26 страницКурсоваяAndreevichОценок пока нет

- 2ч FAQ for AdvancedДокумент72 страницы2ч FAQ for Advanceddimaminsk264Оценок пока нет

- Tsani 06Документ20 страницTsani 06Ccc AaaОценок пока нет

- МОДУЛЬ 2 - лекц3Документ24 страницыМОДУЛЬ 2 - лекц3Максим КравченкоОценок пока нет

- Merged Document MergedДокумент177 страницMerged Document MergedAna NicuțăОценок пока нет

- Intrebari Evaluarea a-2-A - КопияДокумент6 страницIntrebari Evaluarea a-2-A - Копияsobormaria2003Оценок пока нет

- Lab - 2Документ8 страницLab - 2Андрей МайоровОценок пока нет

- Лабораторный Практикум ИСКУССТВЕННЫЕ НЕЙРОННЫЕ СЕТИДокумент140 страницЛабораторный Практикум ИСКУССТВЕННЫЕ НЕЙРОННЫЕ СЕТИjalgasova02Оценок пока нет

- ктоеяДокумент3 страницыктоеяNelly SkorikОценок пока нет

- Os Obschiy DokumentДокумент5 страницOs Obschiy DokumentgfgffgfОценок пока нет

- Снимок экрана 2024-03-19 в 8.20.49 AMДокумент72 страницыСнимок экрана 2024-03-19 в 8.20.49 AMtaniapurimОценок пока нет

- Многопроцессорные и многомашинные вычислительные системыДокумент11 страницМногопроцессорные и многомашинные вычислительные системыcourse2009Оценок пока нет

- отчет нетемулДокумент10 страницотчет нетемулkvykhvОценок пока нет

- Как Работает Процессор (Основа Текста)Документ2 страницыКак Работает Процессор (Основа Текста)Кирил СтепанокОценок пока нет

- 2015-02-06Документ16 страниц2015-02-06LeonardoОценок пока нет

- (RUS) Tasks и Parallelism. Новая волна многопоточностиДокумент17 страниц(RUS) Tasks и Parallelism. Новая волна многопоточностиdmitryОценок пока нет

- Лекция 5. Метод обратного распространения ошибокДокумент13 страницЛекция 5. Метод обратного распространения ошибокРомас БуткусОценок пока нет

- Opracowanie Wykladu Z Informatyki Sem1 Budowa PC I Wstep Programowania RuДокумент9 страницOpracowanie Wykladu Z Informatyki Sem1 Budowa PC I Wstep Programowania RucleananwashОценок пока нет

- Лабораторная работа 2Документ11 страницЛабораторная работа 2Elena AОценок пока нет

- сети к экзаменуДокумент31 страницасети к экзаменуshibaev.260404Оценок пока нет

- KSPD Cns PDFДокумент43 страницыKSPD Cns PDFTrịnh Bá HuyОценок пока нет

- Пополнение Библиотеки Схемных Элементов Симулятора Ltspice.: Circuit Emphasis) Алгоритм МоделированияДокумент12 страницПополнение Библиотеки Схемных Элементов Симулятора Ltspice.: Circuit Emphasis) Алгоритм МоделированияVitaliyGОценок пока нет

- AlgorithmsДокумент21 страницаAlgorithmsffffttttsdrОценок пока нет

- Lektsii Dichina 15-21Документ321 страницаLektsii Dichina 15-21Ericko JaramilloОценок пока нет

- UntitledДокумент7 страницUntitledMR CrimorОценок пока нет

- 2 5206677110776660809 PDFДокумент9 страниц2 5206677110776660809 PDFАлександр ИванцовОценок пока нет

- КоганЯС 6307 отчет НИР бакалавра 6семестр 2022Документ26 страницКоганЯС 6307 отчет НИР бакалавра 6семестр 2022Jacob KoganОценок пока нет

- Практич занятие №3 Примеры АС в PDFДокумент52 страницыПрактич занятие №3 Примеры АС в PDFGaboxjng KuteОценок пока нет

- Лекция 5 (ЦИКЛИЧЕСКИЙ АЛГОРИТМ WHILE)Документ17 страницЛекция 5 (ЦИКЛИЧЕСКИЙ АЛГОРИТМ WHILE)dfhfghf fghfghfОценок пока нет

- ответыДокумент33 страницыответыRoss HelsinОценок пока нет

- Quantum Espresso - Introduction-1-2Документ2 страницыQuantum Espresso - Introduction-1-2jndjkgbgrОценок пока нет

- Фенина О.В. - статья -Документ4 страницыФенина О.В. - статья -Ольга ФенинаОценок пока нет

- Obidov Khoperia 435 1 1Документ47 страницObidov Khoperia 435 1 1Давид ХоперияОценок пока нет

- Применение ДКП для фильтрации изображенийДокумент4 страницыПрименение ДКП для фильтрации изображенийВиктория ЧеботареваОценок пока нет

- 12 100229 1 135966Документ7 страниц12 100229 1 135966Егор ПорожняковОценок пока нет

- Вопросы по темам 2022Документ3 страницыВопросы по темам 2022Анастасия ЯсаковаОценок пока нет

- вопросы по сетямДокумент44 страницывопросы по сетямshibaev.260404Оценок пока нет

- Ответы (копия)Документ67 страницОтветы (копия)Таня ЕфимоваОценок пока нет

- РефератДокумент29 страницРефератAndrew BuzovskyОценок пока нет

- менеджмДокумент42 страницыменеджмАнастасия ЛищенкоОценок пока нет

- Анализ алгоритмовДокумент3 страницыАнализ алгоритмовDavid MarkovОценок пока нет

- Lecture 5Документ4 страницыLecture 5Olesia TronkinaОценок пока нет

- section - 5 - p - 2 Моделирование в Simulink PDFДокумент116 страницsection - 5 - p - 2 Моделирование в Simulink PDFiko1402Оценок пока нет

- Лаб №2 Закон АмдаляДокумент3 страницыЛаб №2 Закон АмдаляkookiefgcОценок пока нет

- 64 21 ZhabinДокумент6 страниц64 21 Zhabinkoyobit832Оценок пока нет

- MATLABДокумент75 страницMATLABDolghieruRodicaОценок пока нет

- F 959943Документ56 страницF 959943dominion1Оценок пока нет

- Лабораторная работа 5Документ4 страницыЛабораторная работа 5gpets002Оценок пока нет

- Отчет5 КлименкоДокумент9 страницОтчет5 КлименкоАртем КлиОценок пока нет